Segmentation et structuration en locuteurs

Cette tâche traite les signaux de parole contenant les interventions de parole de plusieurs locuteurs. Il s’agit (avant, par exemple, une tâche de reconnaissance de la parole) de décomposer le signal en segments supposés propres à un seul intervenant et de classifier ces segments pour reconstituer le panel des participants et leurs interventions.

Corpus et campagnes d’évaluation (LDC – NIST)

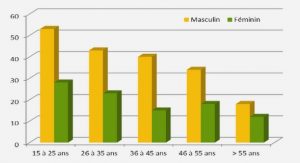

Présentation L’organisme public américain de métrologie NIST est le maître d’ouvrage du gouvernement américain pour les campagnes d’évaluation de traitements automatiques de la parole, en particulier des systèmes de VAL . Les objectifs stratégiques de ces campagnes concernent essentiellement les questions de sécurité du territoire et de renseignement. Ces campagnes s’appuient sur les données collectées depuis plus d’une quinzaine d’année par le LDC. Les sessions portent sur des personnes des deux sexes, d’âge varié, pouvant parlant en anglais natif ou pas, mais aussi dans une vingtaine d’autre langues. Les énoncés sont enregistrés à l’aide de différents microphones dans une salle peu bruitée, ou bien les locuteurs sont mis en relation téléphonique de manière aléatoire et conversent entre eux. Les durées sont variables (quelques secondes à plusieurs minutes), dans des cadres environnementaux et techniques variés (niveaux de bruit ambiant, d’effort vocal, caractéristiques du microphone et du canal de transmission, processus de codage du signal). Un important travail de nettoyage, validation, étiquetage et correction du corpus a été effectué récemment (Ferrer et al., 2011), permettant la constitution de fichiers d’apprentissage plus cohérents. Par la taille considérable de leurs corpus, la possibilité qu’ils offrent aux organismes de recherche de comparer leurs systèmes et configurations, la relative variété de leurs conditions, les jeux d’évaluation NIST constituent l’un des moyens d’expérimentation les plus répandus dans le domaine de la VAL.

Evolution des campagnes En dehors de l’élargissement du spectre des caractéristiques du corpus (cité plus haut), les campagnes NIST ont évolué par une inflation des volume de tests. A l’heure du big data, cette politique -coûteuse pour les participants- espère multiplier les tests de comparaison et permettre ainsi de mieux cerner certaines insuffisances particulières des systèmes.

Corpus et campagnes d’évaluation (LDC – NIST) Jusqu’en 2008, le système pénalisait principalement les fausses alertes (une politique habituelle dans les procédures de détection d’événements rares, où la prudence est de mise). Les nouveaux paramètres depuis 2010 accentuent encore ce déséquilibre. Il faut également noter que la fréquence a priori des tests-cible πcible ne correspond pas à celle, effective, des jeux d’évaluation, ce qui ne facilite pas l’appréciation exacte de la qualité d’un système. Depuis la campagne d’évaluation en reconnaissance du locuteur 2012, NIST propose une nouvelle DCF. Celle-ci tient compte du fait que l’apprentissage de modèles des locuteurs-cibles à partir de plusieurs de leurs segments de voix est autorisé (Bousquet et al., 2012c), ainsi que l’inclusion de locuteurs-cibles dans les données d’apprentissage des modèles de représentation. Ainsi, NIST distingue, parmi les tests-imposteur, ceux pour lesquels le locuteur proposé appartient à la liste des locuteurs-cible et ceux où il s’agit d’un inconnu vis à vis de cette liste

Paramétrisation acoustique

Le signal de parole est une onde acoustique convertie en signal électrique par un microphone. Ce dernier ne peut être traité directement. Après numérisation, la phase de paramétrisation acoustique a pour objectif de transformer ce signal, afin d’en extraire des caractéristiques morphologiques du conduit vocal du locuteur. La démarche adoptée suit une voie usuelle en traitement du signal : ce dernier est découpé en séquences de durée suffisamment courte pour considérer ses paramètres périodiques comme invariants (pseudo-stationnarité du signal sur un bref intervalle de temps). Chaque séquence doit être alors résumée par un jeu de mesures prédéfini, aboutissant à une représentation vectorielle de dimension fixe de cette séquence, appelée trame (frame,feature) : la théorie de Fourier sur les fonctions périodiques permet de considérer l’onde comme une combinaison linéaire de fonctions périodiques et de la résumer par des coefficients de ces fonctions. La prise en compte du problème de reconnaissance du locuteur dès cette phase de paramétrisation est un point important, qui a fait l’objet de nombreuses études. La différenciation des locuteurs sera facilitée par une paramétrisation acoustique moins sensible à leurs variabilités extrinsèques : conditions d’enregistrement, bruit, variabilité intra-locuteur, … A cet effet, des étapes de pré-traitement sont habituellement réalisées : pré-accentuation des hautes fréquences, filtrage passe-bande, … Les séquences de signal sont extraites sur une fenêtre temporelle glissante, avec recouvrement partiel, de durée variant généralement entre 20 et 50 millisecondes. Les trames sont constituées des vecteurs de coefficients cepstraux (coefficients de décomposition en série de Fourier du logarithme de la densité spectrale de puissance du signal (Bogert et al., 1963)). D’autres techniques de vectorisation, plus complémentaires que concurrentielles de l’analyse cepstrale, seront citées plus bas. L’extraction des coefficients cepstraux est réalisée suivant deux approches ; elles ont en commun de produire des coefficients statistiquement décorrélés, cette indépendance permettant en théorie d’en limiter le volume. La première approche utilise la transformée de Fourier rapide (FFT) sur chaque trame, puis une analyse par bancs de filtres qui est censée mieux rendre compte de la perception des fréquences par l’oreille humaine. Les fréquences centrales des coefficients d’énergie obtenus sont alors fixés suivant une échelle linéaire (Linear Frequency Cepstral Coefficient : LFCC) ou une échelle Mel (Mel Frequency Cepstral Coefficient : MFCC) (Stevens et al., 1937) (Davis and Mermelstein, 1980). Enfin, une transformée en cosinus discrète (DCT) appliquée au logarithme de ces coefficients d’énergie permet de les décorréler. La seconde approche s’appuie sur la corrélation entre les échantillons successifs de paroles, attribuable à la résonance du conduit vocal. Une prédiction linéaire (Linear Predictive Coding, LPC) permet d’estimer des coefficients supposés significatifs de l’enveloppe spectrale. Leur transformation dans l’espace cepstral génère alors des coefficients cepstraux (Linear Predictive Cepstral Coefficient : LPCC) (Atal, 1974). La technique de prédiction linéaire est également utilisée pour produire des coefficients censés tenir compte du modèle de perception humaine de la parole (Perceptual Linear Prediction, PLP)(Hermansky, 1990), en particulier la perception non linéaire des fréquences par l’oreille. Une analyse spectrale relative (RASTA) peut alors éventuellement être effectuée, simulant l’insensibilité de l’oreille aux variations temporelles lentes (Hermansky et al., 1991) (Hermansky et al., 1992). Citons également l’approche VTLN (Vocal Tract Length Normalisation) (Eide and Gish, 1996) de modélisation du conduit vocal du locuteur pour extraire des paramètres caractéristiques du locuteur. Elle est actuellement utilisée dans (Singer et al., 2012) pour un système de reconnaissance du langage. Dans tous les cas de paramétrisations précédents, seuls les premiers coefficients cepstraux sont conservés (moins d’une vingtaine en général). La paramétrisation peut être enrichie par des informations dites « dynamiques » : il s’agit des variations immédiates du spectre. La vitesse et l’accélération de ces variations sont contenues dans les dérivées temporelles, première (∆) et seconde (∆∆), formant les coefficients habituellement retenus pour tenir compte du caractère dynamique du signal (Furui, 1981). Remarquons que ces dérivées sont estimées localement par l’étude du taux d’accroissement sur des séries de trames consécutives et que des coefficients supplémentaires de mesure dynamique ont été proposés (Fredouille, 2000) (Magrin-Chagnolleau, 1997), les coefficients ∆ et ∆∆ restant toutefois les plus répandus. Le vecteur acoustique d’une trame contient au final un nombre de coefficients variant en général entre 30 et 60. Le LIA, par exemple, utilise actuellement les 19 premiers coefficients cepstraux de fréquence linéaire (LFCC), leurs 19 ∆ correspondants, 11 ∆∆ et enfin le ∆ d’énergie, soit 50 valeurs par trame. D’autres méthodes de paramétrisation ont été proposées. Certaines visent à mieux prendre en compte certaines informations phonologiques de haut niveau : c’est le cas des paramétrisations prosodiques qui s’appuient sur des indices et paramètres tels que les formants F0, les intensités, « vallées » des éléments voisés, durées des mots, états ou pauses, … (L. Ferrer and and et E. Shriberg, 2010) (Shriberg and Stolcke, 2008). Il existe également des paramétrisations basées sur les niveaux glottique, segmental ou lexical (Campbell et al., 2004). Ces paramétrisations sont utilisées par certains laboratoires (Scheffer et al., 2011), mais toujours en combinaison avec des systèmes basés sur les paramètres acoustiques -en général les coefficients cepstraux-, pour gagner en performance.

Un bref inventaire de représentations et modèles en VAL

Une fois paramétré un segment de parole par une série de trames, le problème se pose de séparer les locuteurs à partir de ces séries. Les trames d’un segment constitue un ensemble de points, d’effectif variable, d’un même espace acoustique. La comparaison de nuages de points appartient au domaine statistique des processus spatiaux. Mais les méthodes employées dans ce domaine, aussi perfectionnées soient-elles, semblent encore trop complexes pour s’appliquer dans notre espace acoustique (un grand nombre d’entre elles travaillent sur des représentation de l’espace géographique réel, en 2 ou 3 dimensions). Une phase de modélisation est donc effectuée en VAL. La stratégie la plus communément adoptée consiste à produire une représentation vectorielle de chaque énoncé de voix dans un espace commun. Si la distinction naturelle entre les locuteurs est suffisamment préservée par ses représentations, des modélisations à hypothèses probabilistes permettent alors d’effectuer efficacement la reconnaissance du locuteur. Nous présentons ici un bref inventaire de méthodes de représentation et de modélisation utilisées en VAL. La description détaillée des modélisations basées sur les mixtures de gaussiennes (dont les nouveautés de la solution i-vector) est effectuée plus loin (paragraphe 2.3), ainsi que celle de la modélisation par clés binaires du locuteur (paragraphe 2.8) à laquelle nous avons contribué et qui est aussi utilisée comme solution alternative pour les évaluations de systèmes i-vectors effectuées au chapitre 4. La quantification vectorielle (Vector Quantization VQ) (Soong et al., 1985) (Mason et al., 1989) effectue, à partir des données d’enrôlement d’un locuteur donné, un partitionnement de l’espace acoustique en un nombre fini de régions et représente chacune par un vecteur centroïde. L’ensemble de ces vecteurs forme ce qu’on appelle un dictionnaire de quantification. La mesure de proximité entre ce dictionnaire et les trames d’un segment de test, calculée comme la moyenne des distances minimales entre chaque trame et les centroïdes, permet la comparaison de segments de parole. Cette méthode est qualifiable de déterministe, mais aussi de vectorielle et de non-paramétrique. Ses résultats dépendent très fortement de la taille fixée du dictionnaire. Les approches à noyaux, telles que les machines à vecteur support (Support Vector Machine SVM) (Vapnik, 1979) (Vapnik, 1998) (Vapnik, 1995) (Wan and Campbell, 2000) (Fine et al., 2001) appliquent aux trames une transformation non-linéaire vers un surespace de grande dimension. La méthode assure alors de maximiser la marge linéaire entre les classes. Les performances des systèmes basés sur les SVM concurrencent aujourd’hui celles de l’état de l’art par mixture de gaussiennes que nous présentons plus loin. Cette méthode est qualifiable de semi-déterministe (la transformation peut ou pas découler de lois théoriques), vectorielle et discriminante. Dans la famille des classifieurs linéaires discriminants, (Burget et al., 2011) a introduit le classifieur par régression logistique, celui-ci ayant l’avantage de s’appuyer sur des hypothèses probabilistes et bayesiennes. Ses performances n’égalent toutefois pas celles des SVM dans les expériences de (Burget et al., 2011). Signalons également une approche récente de classifieur linéaire discriminant basé sur les SVM, Pairwise SVMs (Cumani et al., 2013), qui va au-delà des limites des SVM basés sur les supervectors. Les modèles d’ancrage (Merlin et al., 1999) (Collet, 2006) représentent un locuteur relativement à un espace de modèles, sous la forme d’un vecteur de similarités vis à vis de ceux-ci. Une similarité peut être calculée par un score de comparaison (modèle d’ancrage vs données d’apprentissage du locuteur). Cette méthode est fortement dépendante de la robustesse des modèles d’ancrage. Elle dépend de leur faculté à synthétiser par un recouvrement discret les informations structurelles de l’espace acoustique. D’autres méthodes ont été présentées depuis une vingtaine d’années, ainsi que des variantes des méthodes précédentes. Elle sont « orientées » génératives ou discriminatives : Réseaux Bayesiens Dynamiques (DBN) (Cooper and Herskovitz, 1992) (Heckerman, 1995), modèles de mélanges de segments (SMM) (Starpert and Mason, 2001) combinant les approches GMM (que nous proposons plus bas) et Dynamic Time Warping (DTW) (Furui, 1981) pour prendre en compte la structure temporelle du signal de parole. Citons également l’approche GDW (Gaussian Dynamic Warping) de (Bonastre et al., 2003), qui constitue un hybride exploitant la généralisation propre aux approches génératives et la modélisation structurelle du DTW.

Le modèle GMM-UBM

Les paramètres GMM des imposteurs de s, nécessaires au calcul de P (X |H1), peuvent être estimés à partir des trames d’une cohorte d’imposteurs, de modèles « proches » de s(Higgins et al., 1991) (Rosenberg et al., 1992). Mais la difficulté à déterminer la liste de ses imposteurs pour un locuteur donné, ainsi qu’à gérer des énoncés « éloignés » à partir d’imposteurs proches, a conduit (Carey and Parris, 1992) (Reynolds, 1995) à élaborer un modèle GMM unique appelé modèle du monde. La stratégie adoptée consiste à collecter un nombre considérable de trames, issus de sessions de voix différentes et de locuteurs distincts, pour entraîner une mixture de gaussiennes générique. L’initialisation des paramètres peut être aléatoire, arbitraire ou assistée (par exemple par un dictionnaire VQ). La convergence vers un maximum local et non absolu s’avère moins préoccupante, étant donné la masse considérable de données d’entraînement. Cette masse autorise pour l’instant à se passer des raffinements algorithmiques consistant à ajouter régulièrement du bruit pour sortir de la « selle » d’un maximum local et espérer relancer la convergence vers une meilleure valeur d’optimisation, ou à des démarches par sous-échantillons tirés aléatoirement (Breiman, 2001) (Celeux and Diebolt, 1985) (Celeux and Diebolt, 1986). Le choix des données d’apprentissage du GMM-UBM est primordial dans la qualité d’un système de reconnaissance. Quantité et variabilité des données sont des facteurs prévisibles de qualité. Les modélisations par GMM-UBM privilégient les segments bien renseignés (longue durée, grand nombre de locuteurs). L’apport d’informations plus pauvres : enregistrements bruités, durée insuffisante, … ne contribue que de manière minime à la qualité du résultat.

Performances successives de systèmes basés sur le GMMUBM

Nous présentons ici, à titre de comparaison, les performances de systèmes basés sur les représentations issues des mixtures de gaussienne avec GMM-UBM, qui ont chronologiquement pris le titre d’état-de-l’art dans cette gamme de systèmes de VAL. Elles sont données pour une configuration du LIA qui est détaillée dans le paragraphe suivant.

– Le premier système utilise un GMM-UBM, la représentation par statistiques du GMM (supervecteurs) adaptées par MAP et un scoring LLR-by-frame dans lequel le modèle imposteur est approximé par le GMM-UBM. Il est noté MAP en abrégé.

– Le second est basé sur les avancées de la Factor Analysis. Il soustrait le terme attribué au canal Ux au supervecteur et applique le scoring LLR-by-frame. Il est noté FA.

– Le troisième est la meilleure fusion obtenue au LIA, en terme de performance, d’un système du type du précédent et d’un système par classifieur SVM (Larcher et al., 2010). Une normalisation des scores par les techniques z- ou zt-norm (Auckenthaler et al., 2000) a été également réalisée. Il constitue donc la meilleure solution dans notre laboratoire avant l’apparition des i-vectors. Il est noté FA+SVM.

– Le quatrième utilise la solution i-vector proposée par son initiateur N. Dehak : une réduction de dimension par LDA suivie du scoring WCCN-cosinus. Il est noté IVECT+COS.

Gaussianité

Les modèles génératifs et méthodes de scoring utilisés dans le cadre des i-vectors s’appuient sur des hypothèses de gaussianité, qu’il s’agisse de configurer la variabilité totale, locuteur ou session. La modélisation par mixture de gaussienne de l’espace acoustique ne traduit pas nécessairement une gaussianité des données : il est toujours possible d’approximer une distribution quelconque par une combinaison linéaire de lois normales, de même qu’on interpole une fonction par des polynômes, ou des séries de Fourier lorsqu’elle est périodique. Une fois transférés les segments de parole dans l’espace compact des i-vectors, les hypothèses sur la nature de leur distribution dans un cadre de modélisation confirmatoire (basée sur des a priori que l’empirique doit vérifier et ainsi valider) constitue le principal obstacle à lever. Des stratégies basées sur la loi normale, bien entendu, mais aussi sur la loi de Student (« Heavy-tailed » HT-PLDA) ont été mises en place et la porte reste ouverte à d’autres propositions. Mais la souplesse des lois basées sur la famille exponentielle, dont les formulations mathématiques autorisent la constitution de distributions conjuguées 1 en forme close et des calculs de vraisemblance exacts et rapides à mettre en oeuvre, a beaucoup contribué à maintenir les investigations dans leur domaine. Le défaut de gaussiannité qui a conduit à introduire la HT-PLDA doit être constaté. Pour cela, une mesure de gaussianité sur des observations multidimensionnelles est à déterminer, dont les résultats seront commentés sur les jeux de données à disposition. D’autre part, si des transformations sont mises en place sur les i-vectors, comme nous l’avons envisagé, la mesure doit présenter un caractère absolu pour comparer les jeux initiaux et après transformation. Les techniques de gaussianisation des données s’incluent dans celles dites de « blanchiment » des données (whitening), destinées à éliminer, redresser ou au moins atténuer des anomalies par rapport aux hypothèses probabilistes émises.

|

Table des matières

I Introduction au domaine de recherche

1 La reconnaissance automatique du locuteur

1.1 Procédures de reconnaissance

1.1.1 Identification du locuteur

1.1.2 Segmentation et structuration en locuteurs

1.1.3 Vérification du locuteur

1.2 Mesures de performance en VAL

1.2.1 Fonction de coût

1.2.2 Mesures d’erreurs en développement

1.3 Corpus et campagnes d’évaluation (LDC – NIST)

1.3.1 Présentation

1.3.2 Evolution des campagnes

2 Systèmes de vérification automatique du locuteur

2.1 Paramétrisation acoustique

2.2 Un bref inventaire de représentations et modèles en VAL

2.3 Modélisations basées sur les mixtures de gaussiennes

2.3.1 Densité d’une mixture de gaussienne

2.3.2 Mesures de vraisemblance

2.3.3 Le modèle GMM-UBM

2.3.4 Adaptation à posteriori (MAP)

2.3.5 Calcul de score

2.3.6 Observations diverses autour des GMM

2.3.6.1 Structuration de l’espace acoustique par le GMM-UBM

2.3.6.2 Pertinence de la représentation par supervecteur

2.3.6.3 Facteur de confiance

2.3.6.4 Adaptation des moyennes

2.3.6.5 Le score LLR-by-frame : proximités absolue et directionnelle

2.4 Décomposition en facteurs et réduction de dimensionnalité

2.4.1 Les diverses décompositions

2.4.2 Réduction de dimensionnalité

2.4.3 Scores après décomposition en facteurs FA et JFA

2.5 Le concept de i-vectors

2.6 Modèles décisionnels et scorings avec les i-vectors

2.6.1 Outils mathématiques

2.6.1.1 Score « log-ratio d’hypothèses complémentaires »

2.6.1.2 Matrices de covariance

2.6.1.3 Analyse discriminante linéaire (Linear Discriminant Analysis LDA)

2.6.2 Modèle LDA + WCCN-cosine-scoring

2.6.3 Modèle et scoring de Mahalanobis

2.6.4 Modèle et scoring LDA-Two-covariance

2.6.5 Modèles PLDA

2.6.5.1 PLDA gaussienne (G-PLDA)

2.6.5.2 PLDA « heavy-tailed » (HT-PLDA)

2.6.6 Commentaires et détails sur les méthodes

2.7 Performances successives de systèmes basés sur le GMM-UBM

2.8 Modélisations par clés binaires

2.8.1 Extraction de clés binaires

2.8.2 Recouvrement

2.8.3 Scoring

2.8.4 Objectifs du modèle de clés binaires : le concept d’exceptions

II Contributions

3 Analyse statistique de la représentation

3.1 Un outil visuel d’analyse : le graphe spectral

3.2 Transformations des i-vectors

3.2.1 Standardité

3.2.2 Gaussianité

3.2.3 Unitarité

3.3 Conclusion

4 Techniques de normalisation

4.1 La transformation EFR (LΣ)

4.2 Premières propriétés de la normalisation EFR

4.2.1 Convergence vers le modèle standard

4.2.2 Gaussianité

4.3 Propriétés générales de la normalisation EFR

4.3.1 Uniformité des probabilités

4.3.2 Dispersion maximale

4.3.3 Correspondances entre les décompositions en valeurs singulières locuteur et session

4.3.4 Equivalence des techniques LDA et NAP

4.3.5 Optimalité de la LDA

4.3.6 JFA vectorielle (notion d’eigenfactors)

4.3.7 Généralisation des métaparamètres

4.4 Opportunité de l’algorithme EFR après LDA

4.5 Performances comparées des scorings après normalisation EFR

4.6 Adaptation de la normalisation au modèle PLDA

4.6.1 Investigation préliminaire

4.6.2 Normalisation spécifique à la PLDA Gaussienne : Spherical Nuisance (LW)

4.6.3 Convergence vers le modèle isotropique

4.6.4 Généralisation des métaparamètres

4.6.5 Stationnarité

4.6.6 Graphe spectral

4.6.7 Initialisation de la PLDA

4.7 Propriétés après normalisation « Spherical Nuisance »

4.7.1 Dispersion maximale

4.7.2 Correspondance entre les décompositions en valeurs singulières

4.7.3 LDA

4.7.4 Analyse des métaparamètres après initialisation

4.8 Performance de la PLDA après normalisation SphN

4.9 Bilan et conclusion

5 Fondements du paradigme

5.1 Objectifs

5.2 Evaluation des étapes d’un système basé sur les i-vectors

5.2.1 Protocole expérimental

5.2.2 Modèles et scorings i-vectors

5.2.3 Réduction de dimension

5.2.4 Représentation issue du GMM-UBM

5.2.5 Synthèse

5.3 Investigations complémentaires

5.3.1 Analyse du concept i-vector par les accumulateurs GMM et modèle binaire

5.3.2 Evaluation des représentations par accumulateurs

5.3.3 Dimension initiale et performance en discrimination

5.4 Bilan et conclusion

6 Limites de la modélisation linéaire gaussienne

6.1 Introduction

6.2 Anisotropie dans l’espace des i-vectors normalisés

6.2.1 Présentation

6.2.2 Mesure de l’anisotropie

6.3 Conclusion

7 Conclusion et perspectives

III Contributions complémentaires

8 Contributions aux modèles de clés binaires du locuteur

8.1 Algorithmes de recouvrement

8.1.1 Recouvrement par base de modèles imposteurs

8.1.2 Recouvrement par extension locale du GMM-UBM

8.2 Egalisation des appels par gaussienne

8.3 Performance sans apprentissage de la variable locuteur

8.3.1 Score modèle vs modèle

8.3.2 Score modèle vs trames

8.3.3 Indépendance des clés binaires

8.3.4 Conclusion

8.4 Extraction de typicalités

8.4.1 Quantité d’informations

8.5 Perspectives

9 Adaptations des systèmes i-vectors à des contextes particuliers

9.1 Introduction

9.2 Application des i-vectors sur les énoncés de courte durée

9.2.1 Analyse de variance

9.2.2 Combinaison des systèmes

9.2.3 Expérimentation

9.2.4 Complément : échelonnement des durées d’apprentissage

9.2.5 Conclusion

9.3 Extension bayésienne du modèle two-covariance aux applications mixtes

9.3.1 Le modèle 4-covariance

9.3.2 Adaptation du scoring au modèle 4-covariance

9.3.3 Expérimentation

9.3.4 Conclusion

IV Annexes

![]() Télécharger le rapport complet

Télécharger le rapport complet