Régression linéaire simple

Introduction

Ce chapitre introduit la notion de modèle linéaire par la version la plus élémentaire : expliquer Y par une fonction affine de X. Après avoir explicité les hypothèses nécessaires et les termes du modèle, les notions d’estimation des paramètres du modèle, de prévision par intervalle de confiance et la signification des tests d’hypothèse.

Modèle linéaire simple

On appelle généralement modèle linéaire simple unmodèle de régression linéaire avec une seule variable explicative.

On a donc deux variables aléatoires, une variable expliquée Y, qui est un scalaire, une variable explicative X, également scalaire. On dispose de n réalisations de ces variables, (Xt)1 ≤ t ≤ n et (Yt)1 ≤ t ≤ n. Le modèle a deux paramètres : Yt= β0+ β1Xt+Et.

• β0 :l’ordonnée à l’origine ;

• β1 :le coefficient directeur ;

dont l’objectif est d’expliquer les variations de l a variable Y à partir des valeurs observées pour la variable x .

On suppose Y=β0+β1X+ où E est un terme résiduel aléatoire ou erreur. Nous donnons une estimation du modèle par : E(Y) = b0 + b1 X

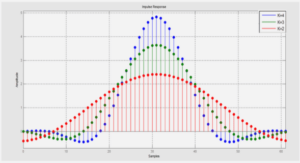

FIGURE 1 – Exemple de régression du poids d’un arbre en fonction de la variable diamètre _ hauteur

Remarque : Nous supposerons pour simplifier que X est déterministe. Dans le cas contraire, X aléatoire, le modèle s’écrit alorsconditionnellement aux observations de X : E(Y |X = x) = b0 + b1X et conduit aux mêmes estimations. Les hypothèses relatives à ce modèle sont les suivantes :

la distribution de l’erreur est indépendante de X où X est fixe.

l’erreur est centrée et de variance constante:

E( ) = 0; Var( ) = 2:

β 0 et β 1 sont constants, pas de rupture du modèle.

Hypothèse complémentaire pour les inférences : 2 suit la loi N(0 , 2)

Coefficient de corrélation linéaire

Soit r = avec -1 ≤ r ≤ 1.

Le paramètre r est appelécoefficient de corrélation.

r est une mesure symétrique qui mesure le lien linéaireentre X et Y : r = −1 : X et Y sont proportionnels et varient en s ens opposé.

r = 1 : X et Y sont proportionnels et varient dans le même sens.

r= 0 : X et Y ne sont pas corrélés.

La corrélation n’indique aucune causalité.

Remarque :

Si X et Y sont indépendants, alors r(X, Y ) = 0.

Si X et Y sont gaussiens, il y a équivalence entre indépendance et corrélation nulle.

Estimateur de la variance 2:[2]

Soit le modèle a deux paramètres : Yt= β0+ β1Xt+Et. et E(Yt)=Ῠt = b0 + b1Xt .

Les résidus calculés ou estimés sont : Et = Yt – Ῠt

La variance 2 est estimée par la variation résiduelle : s2 = . Et)2

Précision sur les paramètres b et b

Soit x̅et y̅les moyennes de n réalisations de ces variables, (Xt)1 ≤ t ≤ n et (Yt)1 ≤ t≤ n

D’après la méthode des moindres carrés on peut écrire :b0= -b1.x̅et

b1=s xy/ s2x.

avec,

S xy= y t – ) ( xt – ) et, S x= xt – )2 alors, E(b0)=β0. v(b0)= 2. ( +( 2 / xt – ) 2))

et E(b1)=β1.

S2 (b )=S2 . ( + ( x 2 x – ) 2 )

V(b1)=σ 2 / xt – )2

Estimation de V(b1) et de V(b0)

S2 (b )=S2.( + ( x 2 x – ) 2 )

S 2 (b1)= S2 / xt – ) 2

Intervalle de confiance de β1

b1 T n-2 .S(b1)

Intervalle de confiance de β0

b0 T n-2. S (b0) où T est la loi de Student à n – 2 degrés de liberté pour un risque α .

Tests de nullité

Si les valeurs de β0 ou de β1 sont faibles, on peut se demander si elles sont significativement différentes de zéro. Le test de ullitén consiste à regarder si 0 est dans l’intervalle de confiance de β0 ou de β1, intervalle défini ci-dessus avec l’hypothèse de normalité.

Le test de nullité deβ1 est appelé « test d’indépendance des variables »En. effet, si β1 = 0 (ou, plus précisément, siβ1 n’est pas significativement différent de zéro), alors X et Y ne sont pas liés.

Si l’on a β0 = 0 (ou, plus précisément, siβ0 n’est pas significativement différent de zéro), alors on peut utiliser une loi strictemen linéaire Y=β1•X+E

Avec b1= xt yt / xt 2

S(b1)= Et=Yt-Xt.b1-b0

s2= et2

l’intervalle de confiance β1 : b1 s(b1). T ,n-2 .

Prévision statistique

Le but de la régression est d’établir la loi Y = ƒ(X). Une fois cette loi estimée, on va chercher à prédire une valeur de Y pour une valeur de X donnée ; on note Y cette valeur estimée, Y = β0+ β1X

Il faut donc donner un intervalle de confiance pour cette valeur de Y.

Inférence concernant la moyenne de la distribution conditionnelle de Y en X=Xh

On va faire une estimation de E(Yh) en X=Xh est Ῠh=b0+ b1.Xh suit un loi normale de paramètres N ( E(Ῠ), var(Ῠ))

E(Ῠh )=β0+β1.Xh

V(Ῠh)=V( Y̅+ b1 .(xh – X̅) )

=Y(Y)+(X̅h-X)̅.V(b1)

= 2 ( ( ( xh – x̅) 2 xt – ) 2))

Avec ;

V(b1)2 / xt – ) 2

Estimation de 2 (Ўh).

s2( )=s2. [ + ( ( x h – x ) 2 x t – ) 2 )].

Intervalle de confiance de E (Ўh) . Ῠh T ɑ/2 ;n-2 . s(Ῠh ) .

où T est la loi de Student à n – 2 degrés de liberté pour un risqueα.

On peut donc se demander avec quelle précision on estime E(Y(x)). Pour un risque α donné, nous voulons pouvoir dire : j’aiα chances que E(Y(x)) soit dans l’intervalle :

[Ῠh -T ɑ/2;n-2 .s(Ῠh ) ; Ῠh+ T ɑ/2;n-2 . s(Ῠh ) ].

Prévision d’une valeur de la variable dépendante pour une nouvelle observation de X et intervalle de prévision :

La prévision d’une valeur éventuelle de Y notée hY(p) pour une nouvelle observation Xh est : Yh(p)=b0+b1. Xh

on note ; dh=yh-yh(p)=yh-Ўh

var(dh)=var(yh-Ўh)=var(yh)+var(Ўh)

Estimation de la variance :

S2(dh)= s2 + s2(Ўh)=s2. [ 1 + +( ( xh – x̅)2 / xt – ) 2 ) ]

L’intervalle de prévision de yh

Ўh T ;n-2 . s(dh).

|

Table des matières

Remerciements

Dédicace

Introduction

Chapitre1 :présentation de la RADEEF

1-Présentation générale de la RADEEF

2-Organigramme de Direction

3- Les travaux effectués :

3.1-Département gestion permanent

Chapitre 2 : régression linéaire simple

Introduction

1-Modèle linéaire simple

2-Coefficient de corrélation linéaire

3-Précision sur les paramètres b0 et b1

4-Tests de nullité

5-prévisions

Chapitre 3 :les séries chronologiques

Introduction :

1.1-Définition d’une série chronologique

2-Les modèles d’une série chronologique

3-Les composantes d’une série chronologique

4- Choix du modèle

5-Caractéristiques du modèle additif

6-Caractéristiques du Model multiplicatif

7-Les moyennes mobiles

8-Les différents lissages exponentiels

8.2-Le lissage exponentiel simple

8.3-Le lissage exponentiel de Holt

8.3-Le lissage de Winters :

8.3.3-Prévision avec le modèle additif

8.3.4-Prévision avec le modèle multiplicatif

Chapitre4 : Applications

Introduction

Application1

Application2

Application3

Application4

Conclusion

Inférences

![]() Télécharger le rapport complet

Télécharger le rapport complet