Contexte Scientifique

La Reconnaissance Automatique de la Parole (RAP) est devenu aujourd’hui un moyen largement utilisé pour répondre à des besoins d’interaction homme-machine. Le canal vocal représente en effet le canal favori de l’humain pour communiquer, et plus important encore, le canal vocal représente le canal contenant le plus grand volume d’information par unité de temps : on peut prononcer jusqu’à 200 mots en moyenne pour une durée de 1 minute de parole ; cependant, pour la même durée de temps, on peut écrire uniquement 40 mots en moyenne. Le domaine de la Reconnaissance Automatique de la Parole (RAP) a bénéficié d’avancées scientifiques considérables durant ces trente dernières années. Ces avancées sont dues aux évolutions technologiques en lien avec le développement d’ordinateurs de plus en plus puissants, à l’émergence des méthodes et architectures neuronales du domaine Deep Learning (Goodfellow et al., 2016; Deng and Yu, 2014), à l’explosion des quantités de données vocales recueillies et aux explorations/expérimentations plus exhaustives des techniques de traitement des données séquentielles dans le domaine de la RAP. Le problème du domaine de la RAP se résume à faire correspondre les représentations audio et textuelles, pour ce faire, deux phases principales sont nécessaires : 1) une phase d’alignement des représentations des deux séquences, 2) une phase de reconnaissance de la représentation textuelle à partir de l’observation audio. Le principe de la RAP se basant sur la formulation statistique bayésienne introduite en 1976 a grandement été bouleversé par l’arrivée des modélisations neuronales. Deux grandes familles ont pu émerger :

— Les approches traditionnelles nécessitant 3 composants : acoustique, phonétique et linguistique pour la prédiction des mots à partir du signal audio.

— Les approches neuronales appelée “End-to-end” permettant de prédire directement les mots à partir du signal audio.

Les approches traditionnelles ont longuement été développées durant les 4 dernières décennies (Baum et al., 1970; Rabiner and Juang, 1986; Baum, 1972; Theodoridis and Koutroumbas, 2003; Woodland et al., 1994; Povey et al., 2011) ; cette approche consiste à modéliser le problème de la RAP en le découpant en trois composants : acoustique, phonétique et linguistique en utilisant la formulation statistique bayésienne. Le composant acoustique permet de résoudre le problème de prédiction de la représentation phonétique à partir du signal audio, le composant phonétique permet de lier la représentation phonétique aux mots phonétiquement possibles à l’aide d’un dictionnaire de prononciation phonétique, le composant linguistique quant à lui permet de sélectionner le mot le plus probable sachant le contexte d’apparition du mot dans la phrase (grammaire et conjugaison). La gestion des alignements des données séquentielles avec cette approche a été effectuée par l’introduction des modélisations cachés de Markov (“Hidden Markov Model (HMM)”). La partie reconnaissance, quant à elle, a été traitée par l’introduction de densité de probabilité pour la prédiction de la représentation phonétique (phone, tri-phone..) à partir des données d’apprentissage : les modèles de mélange de lois gaussiennes (“Gaussian Mixture Model (GMM)”) ont précédé les approches neuronales. La combinaison des modèles neuronaux et des modèles HMM est appelée dans la littérature “modèle hybride” : on associe les approches neuronales (pour la reconnaissance) à la modélisation HMM (pour l’apprentissage des transitions/alignements). Plusieurs contraintes ont été identifiées dans cette approche traditionnelle :

1. (Trad-P1) Le modèle de prononciation (dictionnaire) est figé, cela limite les systèmes RAP utilisant cette approche à reconnaître uniquement les mots existant dans ce dictionnaire.

2. (Trad-P2) L’optimisation des trois composants ne résout pas le problème de base de la RAP. Le composant acoustique traite la problématique d’alignement et de reconnaissance de données séquentielles et il permet la prédiction de représentation phonétique et non la prédiction des mots.

L’approche traditionnelle permet à ce jour d’apprendre à partir des données la dépendance acoustique et la dépendance linguistique est traitée avec un modèle probabiliste estimé à partir des fréquences de mots dans un corpus de données textuelles. Les approches “End-to-End” ont bouleversé le domaine en permettant d’apprendre à prédire des sorties textuelles directement à partir d’entrées audio sans avoir à construire des composants intermédiaires. Les problèmes (Trad-P1 et P2) ont été résolus par le développement de ces architectures neuronales, notamment avec :

— L’introduction de la fonction de perte CTC (Graves et al., 2006; Graves and Jaitly, 2014; Amodei et al., 2016; Seide et al., 2011) permet l’apprentissage de la représentation textuelle directement à partir de l’observation acoustique avec l’introduction d’une prédiction fictive permettant de gérer l’alignement des deux séquences d’entrée et de sortie. On parle d’alignement monotone.

— L’introduction de l’architecture RNN-T (Graves, 2012; Li et al., 2019b; Rao et al., 2017) permet de joindre l’information issue de deux composants neuronaux : acoustique et linguistique.

— L’introduction de l’architecture seq2seq avec mécanisme d’attention (Bahdanau et al. (2016); Chorowski et al. (2015)) permet d’encoder l’information acoustique avec un composant neuronal appelée “Encodeur” et produit la séquence de sorties avec un deuxième composant neuronal appelée “Décodeur”. Cette architecture permet de réaliser la tâche de RAP en deux phases, une première d’encodage de l’information acoustique puis une deuxième phase de reconnaissance de la séquence de sorties avec un mécanisme d’attention. Plusieurs problèmes ont été identifiés avec l’avènement de cette approche, notamment :

1. (E2E-P1) Le choix de l’unité de prédiction de la modélisation E2E. Le choix de ces unités ainsi que la façon avec laquelle le système RAP combine ces unités pour représenter les mots est un axe important à explorer.

2. (E2E-P2) L’important volume de données pour l’apprentissage de système E2E RAP. Plusieurs solutions ont été proposées pour répondre au problème (E2E-P1) par l’introduction de prédiction au niveau : caractère, pièce de mot, mot. La prédiction au niveau mot produit un grand nombre de problèmes liés à l’apprentissage et au vocabulaire restreint (problème équivalent au Trad-P1). Les prédictions au niveau graphème ou pièce de mot peuvent être sous optimales. Le problème (E2E-P2) représente un grand problème au niveau coût. Baidu dans le projet DeepSpeech (Hannun et al. (2014)) a construit un corpus de 5000 heures enregistrées par 9600 locuteurs ; le coût d’enregistrement a été évalué à 2 Millions de dollars et a permis en 2014 d’enregistrer le meilleur taux de performance des moteurs RAP industriels au monde. Microsoft utilise pour ses recherches sur les systèmes E2E un corpus d’environ 30000 heures issues de Cortana, Xbox et de données conversationnelles pour la langue anglaise. Face à ce problème d’insuffisance de données et d’adaptation aux conditions réelles d’utilisation, goulet d’étranglement pour la construction de modèle E2E, nous trouvons dans la littérature plusieurs tentatives de résolution les problèmes :

1. Augmenter le corpus d’apprentissage

— Utiliser des techniques de perturbation de données pour adapter aux conditions réelles Ko et al. (2015); Jaitly and Hinton (2013).

— Enregistrer/synthétiser un ensemble de données vocales similaire au cas d’utilisation, pour adapter le modèle à toutes les conditions observées, accents, dialectes, environnements sonores Kim et al. (2017a); Ko et al. (2017).

2. Changer de technique et d’architecture par rapport aux volumes de données disponibles.

— Utiliser des techniques plus adaptées aux petits/moyens corpus. (par exemple, la technique d’alignement/apprentissage proposée par Kaldi Povey et al. (2011))

— Utiliser des techniques plus adaptées à la parole avec l’exemple des sinc-net par rapport aux CNN (Ravanelli and Bengio, 2018))

— Utiliser des techniques de transfert learning et/ou d’apprentissage multi-tâche. (Krishna et al., 2018; Belinkov and Glass, 2017; Rao and Sak, 2017; Kim et al., 2017b)

— Utiliser des techniques permettant d’inclure des données non supervisées. (Meng et al., 2019)

Un grand nombre de ces approches et techniques seront détaillées et analysées dans le chapitre 2, voire approfondies au cours des chapitres suivants.

18ème et 19ème siècle : Les machines parlantes

Les premiers progrès de la RAP remontent au 18ème siècle, notamment avec l’invention de Wolfgang Von Kempelen (1791) qui s’est concentré principalement sur la création de sons de voyelles. Ce système avait comme but d’imiter la production de la parole et ainsi permettre de définir une base pour le développement d’un système qui pourrait également apprendre à interpréter les phonèmes (les unités sonores élémentaires pour la production d’un mot). Thomas Edison Edison (1888, 1916) s’est intéressé à un dispositif capable d’enregistrer la parole humaine en 1889. Ce dispositif appelé “phonographe” (en anglais “Talking machine” ou bien “Dictation machine”) a longtemps servi à enregistrer des notes au quotidien par les administrations et le corps de santé. Les limitations technologiques de l’époque ont gêné la progression de ce domaine qui ne disposaient que de moyens élémentaires pour inventer des machines parlantes. Néanmoins, ils fournissent un contexte important pour des innovations plus récentes.

Le bouleversement des techniques d’alignement neuronal

Le domaine de la RAP a radicalement changé à partir de 2012, les premières publications montrant des résultats prometteurs de la reconnaissance vocale avec l’utilisation de méthodes dites End-to-End, qui permettent de prédire des sorties textuelles directement à partir de l’audio ( Graves et al. (2006); Graves (2012); Graves and Jaitly (2014); Hannun et al. (2014); Amodei et al. (2016); Collobert et al. (2016); Li et al. (2019a); Chiu et al. (2018)). Les anciennes approches consistaient à définir des modèles distincts pour les sons élémentaires (partie acoustique), les séquences de mots (partie linguistique) et les prononciations (lien entre la partie acoustique et linguistique). La maîtrise de chacun de ces modèles distincts prend un temps considérable pour un ingénieur, et constitue un fardeau pour la mise en oeuvre des systèmes RAP en production. En outre, l’approche hybride traditionnelle est toujours compliquée à mettre en oeuvre car chaque modèle nécessite sa propre fonction d’optimisation lors de l’estimation des paramètres et, à ce titre, l’estimation conjointe de tous ces modèles n’est pas toujours optimale. Les approches hybrides traditionnelles ne gèrent pas les mots hors vocabulaire. La RAP de type End-to-End, en revanche met en oeuvre une seule fonction d’optimisation pour l’estimation des paramètres. Cette fonction permet de modéliser directement le problème : trouver la meilleure transcription pour un segment audio donné. Cependant, les modèles de type End-to-End n’ont pas accès à l’information d’alignement généralement utilisée dans l’apprentissage des modèles traditionnels. Ainsi, le modèle de RAP End-to-End doit trouver un alignement du texte et de l’audio pendant l’apprentissage, ce qui n’est pas une tâche simple. Les premières approches de la reconnaissance vocale End-to-End ont utilisé une fonction d’apprentissage appelée Classification temporelle (en anglais “Connexionist temporal classification” (CTC)) introduit par Graves et al. (2006). Le modèle CTC se base sur une fonction de coût et un encodeur neuronal récurrent pour modéliser la dépendance des séquences d’entrées et de sorties. Des modélisations plus évoluées à base de CNN et RNN ont vu le jour telles que l’architecture DeepSpeech 1 et 2 de Hannun et al. (2014); Amodei et al. (2016) ainsi que l’architecture Wav2Letter construite avec des couches purement convolutionnelles proposée par Collobert et al. (2016). En parallèle au CTC, un nouveau type d’approche appelée en anglais : “Transducer models” prenant en compte la dépendance linguistique (en anglais : “output-output dependency”) a été introduit par Graves (2012). Cette approche a suscité beaucoup d’intérêt dans la communauté et a fait l’objet de plusieurs améliorations notamment pour le décodage en temps réel Battenberg et al. (2017); Rao et al. (2017). À partir de 2014 (Chorowski et al. (2014); Bahdanau et al. (2016)), une extension notable a été proposée avec l’introduction des modèles séquence-à-séquence et mécanisme d’attention. L’un des modèles les plus marquants durant cette période, est le modèle dit “Listen, Attend and Spell » (LAS) (Chan et al. (2016)) proposé par Google.

|

Table des matières

1 Introduction générale

1.1 Contexte Scientifique

1.2 Contexte Industriel

1.3 Contributions de la thèse de doctorat

1.3.1 Contributions sur les approches traditionnelles

1.3.2 Contributions sur les approches End-to-End

1.4 Organisation du manuscrit

2 Des machines parlantes aux réseaux de neurones profonds

2.1 Historique

2.1.1 18ème et 19ème siècle : Les machines parlantes

2.1.2 Reconnaissance de mots isolés : “Pattern Matching”

2.1.3 L’évolution de la RAP : Modélisation séquentiel par chaîne de Markov Cachées (HMM)

2.1.4 L’âge d’or de la RAP : la modélisation statistique avancée

2.1.5 Le bouleversement des techniques d’alignement neuronal

2.2 Approche statistique : principe et modélisation traditionnelle

2.2.1 Modélisation Acoustique

2.2.2 Modélisation Linguistique

2.2.3 Phase de Décodage

2.3 Approches End-to-End (E2E)

2.3.1 Approche End-to-End CTC

2.3.2 Calcul de p(l|x) : l’algorithme CTC forward-backward

2.3.3 Apprentissage et Décodage dans le cadre CTC

2.3.4 Approche End-to-End RNN-Transducer

2.4 Modélisation séquentielle avec des réseaux de neurones

2.4.1 Modèles récurrents – RNN

2.4.2 Ajout du mécanisme de porte

2.5 Conclusion

3 Ressources pour la reconnaissance automatique de la parole

3.1 Introduction

3.2 Corpus de parole

3.2.1 Corpus de parole en langue française

3.2.2 Corpus de parole en langue anglaise

3.3 Corpus textuel pour le français

3.4 Processus de pré-traitement

3.4.1 Pré-traitement de l’audio

3.4.2 Pré-traitement des données textuelles

3.5 Conclusion

4 Approche hybride large vocabulaire pour le français

4.1 Du GMM au TDNN : une modélisation acoustique progressive

4.1.1 Systèmes GMM-HMM

4.1.2 Systèmes DNN-HMM

4.2 Évaluation de la modélisation linguistique

4.3 Évaluation de la modélisation acoustique

4.3.1 Évaluation des systèmes GMM-HMM et DNN-HMM de base

4.3.2 Évaluation des variantes des systèmes de type DNN-HMM

4.3.3 Analyse approfondie du système DNN-HMM-TDNN-F-selfAttn

4.4 Application industrielle et adaptation aux contextes clients

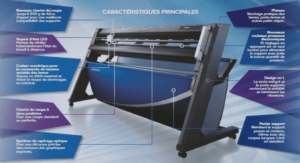

4.4.1 La plate-forme LinSTT

4.4.2 Deux exemples de transfert

4.5 Conclusion

5 Char+CV-CTC : approche multi-tâche dans un système End-to-End

5.1 Le système CTC-GRU de référence

5.1.1 Corpus d’étude et traitement de signal

5.1.2 Le modèle BiGRU

5.1.3 Les systèmes mis en oeuvre

5.1.4 Evaluation des systèmes CTC-GRU

5.2 Les systèmes CTC-MTL

5.2.1 Quelques systèmes CTC-multi-tâches antérieurs

5.2.2 Trois nouvelles propositions de système CTC-MLT

5.3 Évaluations, résultats et analyse des systèmes CTC-MLT

5.4 Conclusion

6 Approche End-to-End : unités et modélisation CRDNN

6.1 La modélisation « Convolutional Recurrent Deep Neural Network « CRDNN »

6.1.1 Augmentation de données à la volée sur GPU

6.1.2 Les modèles CRDNN dans le cadre d’une architecture CTC

6.1.3 Évaluation de l’impact des modèles CRDNN selon l’architecture E2E CTC, RNN-T et seq2seq

6.1.4 Evaluation de l’approche CRDNN sur le corpus LibriSpeech 100 heures

6.2 Choix des unités de prédiction

6.2.1 Génération des unités Subword/Crossword avec l’algorithme Byte Pair Encoding

6.2.2 Évaluation comparée des unités de prédiction : caractère, subword, crossword avec le système CRDNN Attention+CTC

6.3 Modélisation RNN-T : parallélisation des calculs et initialisation du modèle

6.3.1 Parallélisation GPU du calcul de la fonction de perte du RNN-T

6.3.2 Initialisation du modèle RNN-T

6.4 Résultats du projet SpeechBrain sur LibriSpeech 1000 heures

6.4.1 Évaluation du modèle de langage sur le système E2E RAP de 100 heures LibriSpeech

6.4.2 Modélisation SpeechBrain sur LibriSpeech 1000 heures

6.5 Conclusion

7 Conclusion

7.1 Synthèse des contributions

7.2 Perspective

7.2.1 Systèmes hybrides LVCSR pour la langue française

7.2.2 Modélisation RAP E2E

A Annexe : article sur la détection de l’emphase

![]() Télécharger le rapport complet

Télécharger le rapport complet