Télécharger le fichier pdf d’un mémoire de fin d’études

Etude de l’existant

Chaîne de traitement classique des données de recensement

De 1976 à 2002, le traitement des données de recensement se faisait à travers les étapes de collecte sur le terrain, saisie et ressaisie des questionnaires, apurement des données (recodification et regroupement de variables, contrôle des données, traitement des valeurs extrêmes et des données manquantes, recherche de doublons, contrôle de vraisemblance), tabulation et production de rapports. La saisie se justifie par le fait que les questionnaires au format papier étaient utilisés pour la collecte, la ressaisie étant un moyen de contrôle. En effet, les agents de saisie induisaient des erreurs différentes de celles liées à la collecte. Le recensement de 2013 a suivi les mêmes étapes à l’exception de celles liées à la saisie car les PDA ont permis de faire la collecte directement sur un format numérique.

Deux logiciels étaient utilisés dans la chaîne de traitement classique des données de recensement : SPSS (logiciel d’analyse statistique aujourd’hui propriété d’IBM) et CsPRO (logiciel développé par le Bureau du Recensement des Etats-Unis). CsPRO est utilisé dans la confection des programmes de saisie et d’apurement, tandis que SPSS sert à l’analyse statistique.

L’innovation technologique de 2013 avec le choix des PDA comme outil de collecte a permis d’allonger la liste des solutions logicielles. En effet, en plus de CsPRO et SPSS, nous avons noté l’existence de programmes de chargement développés avec le langage C# et de programmes d’exportation de la base de données vers CsPRO. Les programmes de chargement ont permis le stockage des données collectées au niveau de la base de données sous SQL Server 2012.

Afin de retrouver la chaîne classique de traitement des données, la base de données sous SQL Server est exportée au format CsPro au moyen des programmes d’exportation. A partir de cette étape, les corrections et les imputations sont directement appliquées sur la base de données. Cette dernière est ensuite exportée au format SPSS pour la production des syntaxes permettant de disposer des tableaux statistiques ou tableaux de bord.

Toutes ces étapes (SQL Server vers CsPro, puis CsPro vers SPSS, tabulation) sont réalisées par les informaticiens en charge du traitement de données d’enquêtes. La liste des tableaux à générer est reçue des statisticiens.

Sur la durée, la production des tableaux génériques nécessitait quatre à cinq mois. Les tableaux permettant de répondre à des demandes spécifiques étaient produits après la publication des rapports définitifs, donc au-delà des 5 ans, à la fin de l’exploitation.

Solutions techniques

L’ANSD est née suite à la mutation institutionnelle de l’ex-Direction de la Prévision et des Statistiques (DPS) en 2006. En 2004, l’ex-DPS avait initié la mise en place d’une solution informatique nommée « REQUETEUR » pour effectuer des comparaisons entre des variables issues d’enquêtes différentes. Le constat de l’époque était qu’il y avait beaucoup de données, mais aucun moyen d’étendre facilement les capacités d’analyse en comparant les données provenant des différentes enquêtes.

La mise en place du « REQUETEUR » avait nécessité la centralisation des données d’enquêtes et l’harmonisation des variables à des fins de comparabilité. Les principales difficultés résidaient sur le fait que ces données étaient difficiles à exploiter car elles étaient sur support papier et pas totalement harmonisées.

Les points forts du « REQUETEUR » sont :

• les variables issues des différentes enquêtes sont liées entre elles par les trois niveaux de thèmes hiérarchisés (supra thèmes, thèmes et sous thèmes). Cette organisation permet de réaliser de manière simple des agrégations par niveaux ;

• la notion de type de variable (qualitative ou quantitative) est prise en compte à travers la nomenclature. Cela permet de mieux gérer les comparaisons pour obtenir des résultats réalistes ;

• l’affichage des valeurs prises par ces variables et le comptage du nombre d’occurrences des unités statistiques observées selon les valeurs prises par ces variables ;

• l’accès aux métadonnées.

Nous notons aussi plusieurs applications web :

• l’ANADS (Archive Nationale des Données du Sénégal) permet d’accéder plus facilement aux métadonnées des enquêtes statistiques réalisées au Sénégal. En effet, l’ANADS représente la mémoire des enquêtes : toutes les données et ressources (documents de projet, note méthodologique, rapports techniques, manuels, questionnaires, documents de budget, etc.) sont sauvegardées et accessibles en ligne pour permettre aux usagers de disposer d’un maximum d’informations sur le déroulement des enquêtes, aux statisticiens d’améliorer les prochaines opérations de collecte en tirant profit des difficultés répertoriées ;

• le Portail de données du Sénégal est un outil avancé de présentation de données d’enquêtes. Les résultats des requêtes des utilisateurs sont présentés sous formats tabulaire, cartographique et graphique ;

• le SIG-STAT est un système d’information géographique sur les données statistiques. Il permet aux usagers de disposer d’informations sur la localisation des principales infrastructures sociales de base (aéroports, structures de santé, fontaines, routes, etc.).

Critiques de l’existant (domaines d’amélioration)

Ces outils présentés ci-dessus sont pratiquement les seuls éléments de manipulation et de restitution de données statistiques traitées au sein de l’agence.

Cependant, nous notons quelques limites sur ces outils :

• Le Requeteur

– Il ne donne pas de statistiques sur les données

– Problème d’harmonisation et de duplication des données

– Pas de politique de gestion des rôles (qui peut voir et qui ne peut pas voir)

• L’ANADS, le Portail de données du Sénégal et le SIG-STAT

Tous ces outils présentés ci-dessus ont une grande importance dans l’exploitation des données statistiques mais ils n’interagissent pas encore avec les données du RGPHAE d’où la nécessité de mettre en place un système d’information. Ce système permettra en premier d’avoir un entrepôt de données fiable puis en deuxième lieu de tirer le plus d’information sur les données du recensement pour ensuite constituer un outil d’ aide à la décision.

Missions

L’ANSD est une structure administrative dotée de la personnalité juridique et d’une autonomie de gestion et placée sous l’autorité du ministre chargé de la statistique. En particulier, l’Agence est chargée:

– de coordonner les activités statistiques du système statistique national ;

– de produire des données de qualité.

Organigramme

L’ANSD est une structure autonome placée sous la tutelle du ministre chargé de la statistique et administrée par un Conseil de surveillance. Elle se compose de services centraux et de subdivisions au niveau régional. L’ensemble est organisé en Cellules, Directions, Divisions, Bureaux et Services.

La Direction Générale

Outre les Conseillers et chargés de mission, elle comprend la Cellule de passation des marchés (CPM) et la structure d’audit interne.

Les Directions

L’ANSD comprend huit (8) unités principales :

– la Direction des Statistiques Economiques et de la Comptabilité Nationale (DSECN) ;

– la Direction des Statistiques Démographiques et Sociales (DSDS) ;

– la Direction du Management de l’Information Statistique (DMIS) ;

– la Direction de l’Administration Générale et des Ressources Humaines (DAGRH) ;

– l’Agence Comptable Particulière (ACP) ;

– l’Ecole Nationale de Statistique et de l’Analyse Economique (ENSAE) ;

– la Cellule de Programmation, d’harmonisation de Coordination statistique et de Coopération Internationale (CPCCI) ;

– les Services Régionaux de la Statistique et de la Démographie (SRSD).

La DSECN est chargée d’établir des statistiques économiques globales et les comptes nationaux. La DSDS est chargée de la conception, de l’exécution et de l’analyse des enquêtes et recensements démographiques et socio-économiques auprès des ménages.

La DMIS est chargée d’assurer la mise à disposition d’un système d’information efficient pour l’ensemble des activités de l’ANSD et de gérer la diffusion des produits de l’ANSD. Elle est structurée en deux divisions:

– la Division de la Documentation, de la Diffusion et des Relations avec les Usagers ;

– la Division des Systèmes d’Informations et des Bases de Données.

La DAGRH est chargée de la gestion du personnel et des compétences de l’agence, d’assurer la sécurité de l’agence sur toutes les questions juridiques et réglementaires, d’assurer l’approvisionnement de l’agence et la gestion de la logistique et du matériel.

L’ACP assure la gestion des moyens financiers. Elle tient la comptabilité des deniers de l’agence selon le système de comptabilité en vigueur, veille à la disponibilité d’une bonne information financière fiable, à temps et régulière.

La CPCCI a pour mission d’appuyer le Directeur Général dans la préparation des dossiers relatifs au Conseil National de la Statistique (CNS) et au Comité Technique des Programmes Statistiques (CTPS).

Les Services Régionaux de la Statistique et de la Démographie (SRSD) sont chargés de la coordination des activités statistiques des différentes régions.

Définition des notions de base en système d’information décisionnel1

Le système d’information décisionnel

Le système d’information décisionnel (SID) désigne l’ensemble des outils et bases qui collectent les données, les sauvegardent, les retraitent et les restituent dans le but de faciliter la prise de décisions. On parle d’informatique décisionnelle ou Business Intelligence (BI).

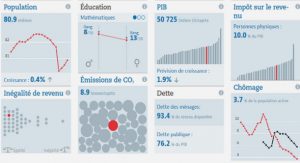

Le SID offre des possibilités d’analyse des données sélectionnées selon différentes techniques :

le reporting avec la construction de tableaux de bord, d’indicateurs, de graphiques ;

la navigation multidimensionnelle dans les données avec la technologie OLAP ;

la fouille dans les données à l’aide des méthodes de Data Mining.

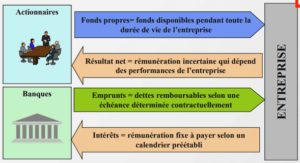

L’entrepôt de données

L’entrepôt de données ou le datawarehouse (en abrégé DW), est une base de données dédiée au stockage de l’ensemble des données utilisées dans le cadre de l’analyse décisionnelle et de la prise de décision. Il est alimenté en données par les bases de production grâce notamment aux outils d’extraction, de transformation et de chargement (en anglais, ETL ou Extract, Transform and Load). Un datawarehouse a les caractéristiques suivantes:

• Orienté sujet

Les données sont organisées par thème. Les données propres à un thème, les ventes par exemple, seront rapatriées des différentes bases de production et regroupées ;

• Intégré

Les données proviennent de sources hétérogènes utilisant chacune un type de format. Elles sont intégrées avant d’être proposées à l’utilisation ;

• Non volatile

Les données ne disparaissent pas et ne changent pas au fil des traitements, au fil du temps. Elles sont en lecture seule ;

• Historisé

On peut visualiser l’évolution dans le temps d’une valeur donnée. Le degré de détail de l’archivage est bien entendu relatif à la nature des données.

Un fait

Un fait représente le sujet à analyser. Il est constitué de mesures représentant les données de l’activité à analyser.

Une dimension

Une dimension est un axe d’analyse d’une mesure pour un fait selon plusieurs perspectives. Par

exemple pour un fait sur les individus, nous pouvons analyser suivant le sexe, la région et le

niveau d’instruction.

Elle contient des champs appelés attributs qui permettent de la décrire.

Les mesures

C’est une donnée numérique stockée dans la table des faits. Il peut s’agir du nombre d’individus de la population, du taux de mortalité ou de fécondité, etc.

Une hiérarchie

Une hiérarchie est un ensemble d’éléments organisés en une structure afin de faire des agrégations à différents niveaux. Par exemple, la hiérarchie de la localité se compose du milieu de résidence, de la commune, du département et de la région. Le sous-total pour un département est la somme des sous-totaux de toutes ses communes, dont chacun est la somme des sous-totaux de ses milieux de résidence.

Base de données multidimensionnelle

Une base de donnée multidimensionnelle ou cube OLAP est une méthode de stockage des données dans une forme multidimensionnelle, généralement à des fins d’analyse. Dans les cubes OLAP, les données (mesures) sont classées par dimensions.

Ci-dessous quelques opérations sur un cube :

Drill-down: Faire un drill-down, c’est avoir un niveau de détails sur les données. Par exemple Supposons qu’on veuille voir le détail des ventes pour le premier trimestre de l’année 2014. On dit qu’on fait un drill-down sur la dimension temps. C’est-à-dire qu’on ne veut pas voir seulement les données de l’année 2014 mais descendre à un niveau de détail plus bas.

Roll-up: Rollup est le contraire de drill-down. C’est donc faire de l’agrégation (ou résumé) des données.

Datamart

Un datamart (DM) ou magasin de données peut constituer un extrait de l’entrepôt, où les données sont préparées de manière spécifique pour faciliter leur analyse et leur exploitation par un groupe d’utilisateurs, en fonction par exemple d’une orientation métier.

Par exemple dans un entrepôt sur les ventes au Sénégal, on peut avoir un datamart concernant uniquement les ventes réalisées dans la région de Thiès. Il offre l’avantage d’accéder directement aux informations du secteur concerné.

Le modèle dimensionnel

C’est un modèle de données structuré de façon à optimiser la performance des requêtes et la facilité d’utilisation. Nous pouvons distinguer le modèle en étoile et le modèle flocons.

Modèle en étoile ou schéma en étoile

Dans cette représentation d’un modèle dimensionnel au sein d’une base de données relationnelle, nous avons une table de faits associée à un ensemble de tables de dimensions. Ces dernières sont toujours directement liées à la table de faits.

Modèle en flocons ou schéma en flocons

C’est une représentation dans laquelle une ou plusieurs tables de dimensions ne sont pas reliées à la table de faits.

Etapes dans la mise en place d’un SID

La phase de collecte

La collecte s’effectue à partir de données appelées : données sources. Ces données peuvent se présenter sous différents formats. Il peut s’agir de fichiers « plats » (fichiers CSV avec séparateurs, fichiers XML, fichiers EXCEL…) mais aussi de systèmes de bases de données (export de base MySQL, PostgreSQL, DB2, ORACLE…). Ces sources de données sont donc en général hétérogènes. Cela explique la phase dite d’intégration pour pouvoir manipuler les données avant de les stocker dans notre système d’aide à la décision.

La phase d’intégration

C’est à ce niveau qu’apparait la première couche logicielle de l’environnement décisionnel à savoir l’ETL. Cette couche offre des fonctions d’extraction de données issues de différents systèmes (internes ou externes), de transformation de ces données (homogénéisation, filtrage, calcul) et de leur chargement dans une zone intermédiaire ou directement dans le DW (entrepôt de données). Elle garantit la délocalisation de la charge de calcul et une meilleure disponibilité des sources.

La deuxième couche logicielle est celle qui fait office de structure intermédiaire destinée à stocker les données issues des systèmes de production opérationnelle. Ce sont en quelque sorte des zones de préparation avant l’intégration des données dans le DW : périodicité journalière, données qualifiées, premier niveau de filtrage et d’agrégat. On peut se passer d’utilisation d’une zone intermédiaire dans un seul cas : si les données du DW sont une simple copie (c’est-à-dire qu’il n’y a pas de traitements à faire et que les données extraites ne vont pas évoluer) des données de production (sources) ce qui n’est malheureusement pratiquement jamais le cas dans de grosses structures.

La phase d’organisation

La troisième phase permet de stocker les données dans un entrepôt appelé : Datawarehouse. Cet entrepôt contient les données orientées métier, non volatiles, historisées (datées) et documentées. Cette structure de données est de manière volontaire généralement dénormalisée pour pouvoir optimiser les temps de réponses lorsque l’on fait des analyses de type OLAP qui se réfèrent à une base de données multidimensionnelle (aussi appelée cube ou hypercube). Elle est constituée de dimensions ou axes d’analyse (l’axe temporel ou géographie sont des exemples courants) et de faits ou indicateurs (tels que le chiffre d’affaires). Un élément important vient du fait que les données stockées dans le DW ne doivent plus changer une fois à l’intérieur. Ce sont des données consolidées et figées qui vont nous permettre de faire toutes sortes d’analyses et statistiques. Une fois ces données stockées dans le Datawarehouse, on va pouvoir créer des magasins de données appelés : Datamarts (DM). Comme le Datawarehouse, c’est un entrepôt de données mais dédié à une fonction de l’entreprise pour des raisons d’accessibilité, de facilité d’utilisation ou de performance. Les données sont généralement équivalentes à celles présentes dans le DW principal mais elles sont représentées de façon adaptée aux besoins spécifiques de la fonction et/ou du domaine utilisateur (par exemple, on va créer un DM dédié pour le service Marketing ou Commercial). Le DM peut avoir une implémentation physique (cube).

La phase de restitution

La dernière phase concerne la restitution des résultats, on distingue à ce niveau plusieurs types d’outils différents :

• les outils de reporting et de requêtes ;

• les outils d’analyse ;

• la phase de Datamining.

Les outils de reporting et de requêtes permettent la mise à disposition de rapports périodiques, pré formatés et paramétrables par les opérationnels. Ils offrent une couche d’abstraction orientée métier pour faciliter la création de rapports par les utilisateurs eux-mêmes en interrogeant le datawarehouse grâce à des analyses croisées. Ils permettent également la production de tableaux de bord avec des indicateurs de haut niveau pour les managers, synthétisant différents critères de performance.

Les outils d’analyse OLAP permettent de traiter des données, de les afficher sous forme de cubes multidimensionnels et de naviguer dans les différentes dimensions. Cet agencement des données permet d’obtenir immédiatement plusieurs représentations d’un même résultat, en une seule requête sous une approche descendante des niveaux agrégés vers les niveaux détaillés (Drill-down).

Les outils de Datamining offrent une analyse plus poussée des données historisées permettant de découvrir des connaissances cachées. Le Datamining est basé sur des algorithmes statistiques et mathématiques, et sur des hypothèses métier.

|

Table des matières

INTRODUCTION GENERALE

PARTIE 1 : CONTEXTE ET PROBLEMATIQUE

Introduction

Présentation du sujet

I. Le recensement de la population

1. Contexte et enjeux

2. Objectifs visés et résultats attendus

3. Dispositif organisationnel

II. Problématique

III. Objectifs

IV. Etude de l’existant

1. Chaîne de traitement classique des données de recensement

2. Solutions techniques

V. Critiques de l’existant (domaines d’amélioration)

Présentation de la Structure d’accueil

I. Missions

II. Organigramme

Conclusion

PARTIE 2 : NOTIONS DE BASE SUR LES SYSTEMES D’INFORMATION DECISIONNELS

Introduction

I. Définition des notions de base en système d’information décisionnel

1. Le système d’information décisionnel

2. L’entrepôt de données

3. Un fait

4. Une dimension

5. Les mesures

6. Une hiérarchie

7. Base de données multidimensionnelle

8. Datamart

9. Le modèle dimensionnel

II. Processus de mise en place d’un système d’information décisionnel

1. La phase de collecte

2. La phase d’intégration

3. La phase d’organisation

4. La phase de restitution

Conclusion

PARTIE 3: NOTRE SOLUTION

Introduction

A. Notre solution : principaux objectifs visés

B. Architecture

C. Modèle

Conclusion

PARTIE 4 : IMPLEMENTATION DE NOTRE SOLUTION

Introduction :

A. Choix des technologies à utiliser

I. Etude des différentes solutions (ETL, OLAP, REPORTING, DATAMINING)

1. La phase de collecte, de préparation et de chargement des données (ETL ou Extract, Transform and Load)

2. La phase d’analyse multidimensionnelle

3. REPORTING

II. Choix de la solution

B. Implémentation de notre solution

I. Présentation des inputs

II. Chargement des données

III. Conception base de données multidimensionnelles

Conclusion

PARTIE 5 : PRESENTATION DES PRINCIPAUX RESULTATS

Introduction :

I. Alphabétisation et scolarisation

II. Emploi

III. Structure de la population

IV. Mortalité

V. Fécondité

VI. Habitat

VII. Migration

VIII. L’Agriculture

IX. L’Elevage

Conclusion

Conclusion – Bilan et perspectives

ANNEXES

Bibliographie et Webographie

Télécharger le rapport complet