Recherche web et recherche catalographique

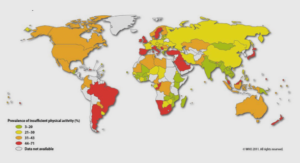

L’OPAC relève d’une économie des métadonnées structurellement différente, dans des processus d’indexation différents, et nourrit des visées divergentes avec ce que peut proposer une plateforme web (qui elle, peut être indexée par un robot). La gestion des données disponibles sur le web offre de multiples avantages dont les usagers ont conscience, et sont attrayantes par leur caractère englobant : une croissance exponentielle et un gigantesque volume de données58. Ce caractère englobant est séduisant, surtout qu’il offre la plupart du temps une recherche plein texte, là où les plateformes de bibliothèques vont proposer de préférence une navigation cantonnée à l’univers des métadonnées. Cet immense réservoir détourne l’usager d’une approche qualitative, et peut baisser son niveau d’exigence dans les résultats obtenus. Le web gère des sources hétérogènes et mélange dans les résultats des domaines parfois peu compatibles : approche commerciale, scientifique ou de vulgarisation se côtoient (Mkadmi et Saleh 2008, p. 56). Les points forts de la plateforme de bibliothèque, ou de toute interface de gestion spécialisée reposent sur :

– la responsabilité de constitution, de mise à jour et d’indexation de la base ;

– l’homogénéité des sources et des informations [par exemple pour une bibliothèque universitaire, une garantie que l’approche des sources proposées est de caractère pédagogique ou scientifique, et qu’elles sont reconnues par la communauté universitaire] ;

– un format unique de présentation des données, ou un ensembles de formats cohérents (MARC, EAD, etc.) ;

– des bases structurées ;

– le monolinguisme.

Chacune de ces raisons qui rendent les OPAC plus « fiables » relève d’un seul caractère global : les sources sont présentées comme des collections, dont la qualité est garantie par une politique documentaire. En effet, une politique d’acquisition permet de peser chaque élément de la collection et interroge le rattachement intellectuel de l’élément par rapport à son ensemble, et le qualifié en fonction de l’appropriation prévue :

– thématique (ou thesaurus), indexation matière;

– niveau (L/M/D) ;

– usage déterminé (vulgaire, pédagogique ou scientifique).

Ainsi, les métadonnées qui « enveloppent » la ressource sont des informations secondaires, elles sont le produit de l’intermédiation entre bibliothécaires et usagers. D’une certaine façon, les sources mise en œuvres sont validées par la communauté universitaire, validées par l’édition, et peuvent de fait être citées comme des sources fiables, au contraire des sources librement indexées et librement mises à disposition des usagers sur Internet, caractérisées par :

– l’absence de structure ;

– l’absence de langage d’indexation ;

– une indexation de très bas niveau (morphologique) ;

– l’absence de validation ;

– le multilinguisme ;

– le mélange des modes de recherche : répertoire, mots, navigation ;

– l’alimentation réalisée par des webmestres qui ne répondent pas forcément aux mêmes problématiques (ibid, p. 57 sqq).

Ces deux axes divergents favorisent la rupture, et génèrent une crise dans l’intermédiation. L’OPAC, comme tout système de communication, est placé comme l’élément principal de l’intermédiation dans un contexte numérique. « L’interface de consultation a pour objectif d’assurer la communication entre la base d’informations et l’utilisateur. Elle représente un intermédiaire chargé de chercher et de présenter l’information à l’utilisateur » (Mkadmi et Saleh, 2008, p. 57). Pourtant, si la collection est censée représenter un attrait parce qu’elle est le produit d’une démarche intellectuelle collective centrée sur la connaissance, la pédagogie ou la recherche (fruit des politiques d’acquisition, politiques documentaire, politiques d’indexation, et du catalogage), l’OPAC qui concrétise ces relations intellectuelles se doit d’être englobant. Souvent la collection numérique reste inaccessible dans le pôle de métadonnées organisé par le SIGB comme dans son point d’accès public. Comment faire côtoyer des métadonnées structurées à haute valeur ajoutée comme par le passé construites autour de l’imprimé, avec des métadonnées décrivant des collections numériques alors que leur contrôle échappe aux bibliothécaires ? Il est impossible de l’envisager sans une démarche de construction d’une sémantique commune, ni sans une démarche plus industrielle, de contrôle qualité.

Le SIGB

Le catalogue est un univers en crise : il est délaissé par les usagers qui lui préfèrent les outils de recherche généralistes. Or il est le résultat du travail combiné de plusieurs services internes : la gestion des achats (politique documentaire et veille informationnelle), le catalogage, l’indexation sujet qui apportent de la valeur ajoutée, la communication, plus proche du traitement matériel des documents. Nous pouvons dégager globalement trois éléments problématiques :

– l’acquisition de sources, qui interroge la notion de collection ;

– la forge des métadonnées. Pour cela nous devons plonger dans le format utilisé (MARC), rappeler que la stratégie dominante pour la production de l’information bibliographique repose sur la récupération de notices et le catalogage dérivé ;

– la matière pour laquelle le SIGB est désigné reste l’imprimé.

Cette combinaison explique peut-être l’installation dans un état de crise. Elle enferme dangereusement les données dans le web profond, et rend difficile l’adoption de standards émergents qui sont employés de façon coutumière à présent dans la sphère du web, qui évolue selon un rythme plus soutenu que les applications pour bibliothèques. L’on peut voir à quel point les contraintes du SIGB sont fortes dans l’élaboration du système d’information. Plusieurs groupes de recherche nationaux ou internationaux n’hésitent pas à mettre ses capacités en cause pour tenter d’étendre ses possibilités et de le hisser à la hauteur des attentes des usagers, notamment le groupe ILS-Discovery Interface Task Group (ILS-DI), qui va jusqu’à émettre des recommandations techniques (ILS-DI, 2008). Pour comprendre la rupture, il convient donc d’observer attentivement le complexe applicatif des bibliothèques, et particulièrement son cœur, le SIGB (back-office) qui permet de produire et de gérer l’information dispensée par son module d’intermédiation : l’OPAC (front-office), et de mesurer à quel point le numérique influence les modèles applicatifs, les choix technologiques et les priorités de déploiement (Bley, 2008). Le SIGB est un système qui réalise automatiquement une série d’opérations (outil de traitement), dans lequel une base de données commune peut servir à plusieurs applications (outil de gestion), concrètement un progiciel qui regroupe plusieurs fonctions. Il s’agit d’un système « intégré » par lequel on touche la notion de « tout en un ». Dans ses traits principaux, il comprend généralement une base de données relationnelle (SGBDr), deux interfaces graphiques (GUI) : une pour les lecteurs (OPAC) et une pour l’équipe de gestionnaires de la bibliothèque, enfin il intègre des programmes discrets, c’est-à-dire des « unités isolables par l’analyse, mais indécomposables au niveau hiérarchique »59. Le SIGB se compose d’unités modulaires, intellectuellement définies, mais incapables de fonctionner de façon indépendante du socle applicatif. Le SIGB réunit donc plusieurs modules :

– un module d’acquisitions, préparant l’accueil d’une ressource dans la collection, capable de gérer son repérage dans une base d’achat, voire la construction ou l’intégration d’une notice d’acquisition, injectant les informations dans une chaîne de traitement, jusqu’au dépôt du document sur un rayonnage ou dans une collection numérique.

– un module de catalogage ou de référencement, permettant la création, l’insertion ou la modification de notices (bibliographiques, exemplaire, indexation matière, autorités, éditeur, etc.) reliées entre elles par un lien au niveau de la couche applicative et à un plus bas niveau (SGBDr).

– un module de gestion des périodiques ;

– un module de communication gérant les transactions liées au prêt de documents ;

– un module d’administration, pour faciliter le paramétrage de fonctionnalités, pour gérer des utilisateurs en créant des profils, des vues appropriées et l’émergence d’outils pour les bibliothécaires ou pour le public ;

– enfin un OPAC.

L’OPAC, selon les technologies employées, est souvent perçu comme un module autonome, surtout dans une architecture client-serveur. Il n’est pas rare de rencontrer des OPAC, dans une période de transition (2005-2010), employant des technologies différentes de celles utilisées pour la gestion des autres modules, « détaché » du SIGB, n’ayant pour seule relation avec lui qu’un moteur spécifique destiné à écouter des requêtes et répondant selon un modèle de sortie (output) structuré. Les bibliothèques ayant perçu les avantages de la diffusion de l’information par les moyens du web (via un navigateur) ont investi massivement dans des plateformes capables de produire leur catalogue dans cet environnement, même si l’information continuait d’être gérée par une application clientserveur reposant sur des technologies étrangères au web. Les plateformes actuelles d’information documentaire (SID) envisagent d’être nativement compatibles avec le web ; nous observons cette évolution dans la terminologie employée pour désigner le lectorat, avec la généralisation du terme d’ « usager ». Le lecteur devient un usager consommateur de service, avec des droits qui lui sont propres. Les classes d’authentification sollicitées par lui et par les utilisateurs sont les mêmes, mais le profil attribué à l’usager permet une définition plus restreinte des actions et des modèles de vue, avec des prérogatives d’écriture sur les données réservées aux bibliothécaires, et majoritairement des droits de lecture pour le public. La couche applicative gère des attributions de droits sur les données, mais ces droits sont reportés sur la ou les bases de données avec des modèles d’accès spécifiques (<db:access>, <db:tables>, etc. ). Cela change radicalement le paysage applicatif, en tournant résolument l’application dans un environnement web, permet de déporter l’authentification sur des classes standardisées, un recours à un annuaire LDAP (Light directory Access Protocol) visant la gestion des utilisateurs au niveau de l’établissement universitaire, la délivrance d’un ticket d’authentification avec CAS (Central Authentification Service) voir un ticket SSO permettant le rebond vers d’autres applications autres que documentaires (ENT, plateformes de cours, gestion des salles/cours, résultats d’examens, forums d’informations, etc.), ou encore la fédération d’identités. Les contraintes d’accès sont appliquées à différents niveau :

– frontal : avec apache, permettant d’autoriser une couche TCP/IP, HTTP et HTTPS ;

– du serveur d’application (conteneur de servlets java) : tomcat (ASF)60, Caucho Resin, etc. pour la gestion des requêtes et exécution du code ;

– de l’applicatif (SIGB) : gestion des rôles, des vues, des actions, etc. ;

– de la base de données : gestion d’utilisateurs.

Le SIGB s’intègre peu à peu dans un environnement applicatif plus englobant et s’inscrit dans une politique de convergence technologique au niveau de l’établissement. L’OPAC délivre des informations, mais se perçoit comme une couche applicative de service car il met en œuvre des fonctionnalités qui gravitent autour de l’information. Aujourd’hui, la fonctionnalité « Mon compte » est un service standard attendu par la plupart des plateformes et devient systématiquement mentionné dans les appels d’offres ou bien fait partie intégrante du paquet de services offert par les prestataires (Maisonneuve, 2008). Un usager peut avoir accès à un ensemble de services personnalisés garantis par son authentification : situation (emprunts, réservations, mises à disposition en cours), récapitulatif des droits de circulation, informations relatives à l’identité, module de communication (interactivité : suggestions d’achat, écriture de commentaires, envoi de messages à un SSD), etc. Comme nous l’avons vu plus haut, l’un des reproches essentiels adressé à l’OPAC est son manque de caractère intuitif ; il n’est qu’une « version dégradée » de la recherche professionnelle et met en œuvre des index de recherche qui nécessitent une bonne connaissance des contraintes métier chez l’usager. Mais il est surtout le reflet du modèle socio-économique de production ou d’intégration des données, plus que de la stratégie de service. Les données liées intellectuellement et matériellement qui figurent dans un catalogue sont le produit du catalogage dérivé très majoritairement exploité, résultat de l’intégration de notices livrées par le SUDOC, dans un souci de cohérence. Le module de catalogage est souvent laissé dans sa forme la plus rudimentaire, à la faveur d’efforts concentrés sur les outils de récupération de notices. Les transferts réguliers de l’ABES proposent une récupération quotidienne ou hebdomadaire, par des transferts réguliers qui éclatent les données bibliographiques et les données d’autorité dans deux fichiers .RAW au format ISO 2709. C’est cette cohérence qui est primée dans cette stratégie de composition du catalogue. En effet la routine d’import repère les documents déjà existants dans la base et opte pour un recouvrement des données. L’établissement peut choisir l’option de mises à jour générales (des modifications effectuées par tous les membres du réseau sur une notice donnée provoqueront le transfert de la notice auprès des établissements dépositaires de la ressources qui ont choisi cette option) ou de mises à jour propres (seules les notices qui ont fait l’objet de modifications par un établissement donné lui seront transférées). Les notices déjà présentes dans le système feront l’objet d’un recouvrement, les notices n’existant pas encore seront créées. Un repérage sera effectué sur les notices d’autorités par lecture du PPN (identifiant unique) et les liaisons seront rétablies, ou si la notice d’autorité liée n’existe pas encore, elle sera créée et liée selon le modèle de liaison propre au système local. Les liaisons reposent sur le modèle conceptuel de données (MCD) local.

En recherche de compétitivité : écosystèmes, optimisation de service, évaluation

La notion d’architecture de l’information est encore en devenir, car elle est en étroite relation avec le web (Morville, 2007) (Marcoux, 2013) dans sa définition proposée par le collectif francophone :

« La conception structurelle des espaces d’information partagée;

L’art et la science d’organiser et de cataloguer des sites Web, des intranets, des communautés virtuelles et des logiciels pour en faciliter l’utilisation et le repérage;

Une communauté de pratique émergente fondée sur l’apport de principes du design et d’architecture spécifiques à un environnement numérique. »

Or le web est en évolution constante, de fait, l’architecture de l’information aussi. Plus généralement, il s’agit d’une notion qui traverse toute l’ingénierie logicielle, « dépasse maintenant la simple conception de sites web pour s’élargir à l’ensemble des supports, y compris les supports traditionnels, et inclut des dimensions comme les besoins des utilisateurs, l’organisation de l’information et des connaissances et l’évaluation de l’expérience utilisateur » (Marcoux, 2013) ; elle concerne donc aussi les complexes applicatifs utilisés en bibliothèque. Elle intervient lorsqu’il ne suffit plus, pour désigner ce complexe, de convoquer des notions classiques de « portail de l’information » ou « SIGB ». Elle suppose une « architecture de médiation » ; l’ensemble des applications nécessaires pour la constitution d’un SID doivent se représenter comme un écosystème, visant l’optimisation de services, et se fondant sur l’interopérabilité des données tant au niveau sémantique que syntaxique. Elle dispose de son propre écosystème dans la production des métadonnées, mais aussi dans leur exploitation comme matière de recherche, et dans leur restitution de l’information au niveau de l’usager. Les motivations sont certes poussées par la constitution d’un point d’entrée unique à l’information, qui bouleverse la représentation classique en silos (Fig. 18), et ces changements sont bien en relation avec le traitement numérique, les données se représentant comme flux d’information, avec la dématérialisation des collections. L’interopérabilité n’est donc plus un seul aspect de l’architecture de l’information, mais un socle indispensable – elle participe de son essence – qui soutien tous les efforts d’ingénierie, de modélisation de données, en vue de la fédération de sources (Fig. 19), et le couplage (plus ou moins fort) entre sources hétérogènes. Cette interopérabilité – sans revisiter en profondeur la définition de base – qui s’appuie sur la transparence des dispositifs mis en œuvre, permet à une requête exprimée dans un certain langage et d’être interprétée dans un autre langage. Dans la figure 18, une requête multisource doit être envisagée pour laisser à chaque service une autonomie de gestion qui considère les contraintes respectives. Par exemple, la bibliothèque numérique gère des périodiques en ligne qui ont des états de collections spécifiques, qu’il faut bien mettre en perspective avec les états de collection de la collection imprimée gérée par le SIGB et restituée par l’OPAC. L’un et l’autre ne peuvent s’ignorer, mais il n’est pas question non plus que l’un impose à l’autre son mode de gestion. De même, la consultation des e books ne doit pas bouleverser les propriétés de gestion des monographies imprimées, soumises à des contraintes de prêt ou de disponibilité. La mise en valeur de ce patrimoine documentaire est un enjeu qui dépasse le simple niveau des services communs de documentation, mais constitue un indice d’évaluation dans la qualité du cursus universitaire, des services environnants offerts à l’usager, et participe finalement du contexte de mise en concurrence des universités dans le choix que fera un étudiant ou un enseignant pour rejoindre une communauté donnée125.Le compte rendu analytique de séance du Sénat du 11 juillet 2007 rapporte que « le classement de Shanghai était certes critiquable mais que puisqu’on ne pouvait changer les indicateurs dont nous n’étions pas maîtres, il valait mieux les retourner en notre faveur. Lorsqu’ils choisissent leur future université, les étudiants américains, australiens, chinois, indiens regardent ce classement. C’est la mondialisation. On ne peut s’en abstraire et nous devons donc gagner des places, ce qui n’est pas contraire à l’exigence d’excellence de l’université française ». La fourniture des services documentaire ne compte peut-être pas directement dans les critères de choix d’un établissement, mais comme les indices de citation, et les performances académiques sont inspectés, les critères d’accès à la haute technologie finiront par l’être : l’accès aux collections numériques à distance, l’accès à la documentation en général, d’autant que le lien entre l’accès à la documentation et la réussite des études tend à se démontrer (Heusse, 2012). Il faut hisser la bibliothèque au niveau des projets d’établissement, et la visibilité des collections est un enjeu majeur. Bien que conscient des différences profondes de fonctionnement entre le Royaume Uni et la France, le rapport cite le plan stratégique de l’Imperial College de Londres, qui, actualisé pour le contrat 2010-2014, livre un volet spécifique aux bibliothèques126 en faisant émerger plusieurs aspects stratégiques qui supposent une organisation conforme aux schémas dits « orientés architecture » :

– rechercher l’efficacité dans la fourniture documentaire ;

– accompagner la réussite universitaire (dialogue avec d’autres univers : scolarité, enseignement, etc.) ;

– proposer une approche encyclopédique de la connaissance ;

– être capable de soutenir des développements agiles ;

– rendre les services faciles d’utilisation et intuitifs, créer de la transparence dans les usages ;

– faciliter l’accès aux ressources ;

– élaborer une collection adaptée et garantir l’accès à un ensemble d’informations dont la qualité scientifique et technique est reconnue au niveau mondial ;

– améliorer les outils de gestion de l’information.

Ces objectifs témoignent d’une volonté d’excellence, et ressemblent plus à un engagement politique qu’à des préconisations fonctionnelles, mais ils sont accompagnés de préconisations sur les aménagements techniques qui observent les méthodes d’architecture de médiation. La recherche d’excellence, de compétitivité, s’inscrit aussi dans la culture de l’évaluation, ce qui est dénoté par la question de confiance, la question de la compréhension des différents modèles de publication. L’on ne peut s’empêcher de noter une certaine convergence avec les objectifs énoncés lors des Assises de l’Enseignement Supérieur et de la Recherche, notamment dans le volet « Favoriser la réussite des étudiants », auquel les bibliothèques universitaires sont sensibles, comme l’ADBU porte un document de sensibilisation à ce sujet127. Ce document témoigne de la volonté des bibliothèques de se situer au niveau des projets généraux des établissements universitaires, et poursuit un effort d’urbanisation dans ce but. Cette vision plus globale, qui interroge métaphoriquement la relation entre urbanisme et architecture n’est pas nouvelle (Sassoon, 1998, p. 28) : « L’urbanisme n’est pas l’architecture. L’architecture est « l’art de construire, de disposer et d’orner les édifices ». L’architecture respecte les règles de l’urbanisme qui aura défini la finalité du bâtiment et les contraintes de construction ». Rapportée à la réalité du système d’information, chaque partie de l’urbs (ou bloc), doit garantir la cohérence avec l’ensemble du quartier, voire de la ville, s’intégrer dans le paysage urbain. C’est par cette notion qu’il faut interroger les vagues de modélisation qui viennent structurer l’espace documentaire, comme lieu de rencontre de différentes activités, de différentes cultures, mais qui sont intellectuellement rattachées à un projet commun d’innovation (initié par l’université). Chaque individu doit se retrouver dans cet espace habitable : c’est cette représentation qui rend plus difficile le travail des concepteurs de service : « une démarche d’urbanisme nécessite de reconsidérer périodiquement la représentation de la cible ; l’évolution de la stratégie, la transformation de l’existant, la dynamique des changements intervenus peuvent impliquer sa révision » (Le Roux, 2009, p.33). Enfin, il s’agit d’interroger la stratégie de l’établissement qui est par définition dans l’innovation, sociale, intellectuelle, dans ses trois dimensions de pédagogie, d’enseignement et de recherche. La question de cet investissement est posée de façon centrale dans un contexte de crise. Un phénomène anxiogène se dessine quand « on constate une désaffection des jeunes pour les études scientifiques supérieures marquée par une chute en dix ans des inscriptions universitaires en France » (Tassin, 2008), alors que les efforts de la communauté universitaire sont perçus par elle-même comme l’expression déterminée de la recherche d’innovation, comme un capital d’investissement. En 2007, le développement de l’éducation supérieure est défini comme un atout et comme une priorité par le gouvernement128, comme pour beaucoup de pays industrialisés, et la recherche et le développement de l’innovation technologique accompagnent ce développement prioritaire, dans un contexte de mondialisation. Dans les faits, la recherche de l’excellence est une réponse à la crise. Le défi technologique fait partie de l’objectif de compétitivité, d’efficacité, de travail communicationnel sur l’image (marketing), de la notoriété, et s’inscrit dans un plan de réussite. Les Learning centres et toutes les expectatives qui entourent ces projets innovants en témoignent : ils «intègre[nt] le plus souvent la bibliothèque et les services liés aux nouvelles technologies, avec dans la plupart des cas, un réseau sans fil, des équipements multimédias et des services d’aide aux utilisateurs par des bibliothécaires ou des spécialistes des technologies » (IGB, 2009)129. Ces initiatives rejoignent l’usager qui hausse la place de l’avancement technologique dans ses critères de consommation. Soulignons au passage cette projection posée comme réorganisation indispensable : « le concept de Learning centre va exiger de nouvelles formes de gouvernances, car si la bibliothèque est une composante majeure du centre, la notion de service intégré appelle une gouvernance élargie et spécifique, à la fois sur le plan scientifique et sur le plan administratif et financier »130, ce qui confirme bien le changement de niveau de perception des projets induits par l’urbanisation des applications informatiques et des services de l’université, qui suppose une vision plus globale de l’intégration de la bibliothèque dans les processus d’acquisition et de diffusion des connaissances. Le développement de services vise un rapprochement avec l’usager (ses pratiques, ses usages, ses besoins, mais aussi ses souhaits), une compréhension et une recherche d’adéquation avec ses objectifs, quel que soit son niveau : globalement, réussir ses études pour un étudiant, en veillant à la validation de compétences qui ne relèvent pas uniquement de l’acquisition de connaissances (utilisation de logiciels, compétences informationnelles, navigation entre sources, exercer son esprit critique par rapport à la recevabilité d’un résultat scientifique, etc.), pour un chercheur, produire un rapport scientifique, pour un enseignant, préparer un cours en faisant intervenir des artefacts numériques, pour un administratif, diffuser un compte-rendu, etc. Cela oblige les bibliothécaires à se représenter comme un maillon dans une chaîne d’efforts et de bien connaître d’autre maillons (acteurs) dans cette synergie, voire de s’ouvrir positivement à d’autres secteurs qui ne sont traditionnellement pas les leurs : formation des usagers, publications, aide à la rédaction de bibliographies scientifiques, fournisseur d’accès au réseau (là où se trouvent les bibliothèques numériques, devenir gestionnaire d’espace de stockage), sachant que la diffusion de bibliothèques numériques implique nécessairement une diversification de l’activité des bibliothèques, qui peut être considérée parfois comme un « dispersion » des efforts (Bekaert et al., 2004)131. La modélisation des services mobilise des ressources et passe par la prise de conscience d’une nécessité de réorientation des services, une analyse plus fine des besoins et une multiplication des moyens de fournir l’information (Chadwell et Nutefall, 2012). Dans son célèbre ouvrage, J. Sassoon explique l’histoire de l’évolution (et de la domination) de la compagnie American Airlines (Sassoon, 1998) qui, en recherche d’optimisation de vente de sièges d’avion, a imaginé de mettre les informations relatives à l’occupation de ses aéronefs à ses concurrents, moyennant une redevance, afin de faciliter l’information sur les disponibilités et favoriser une vente indirecte (p.79) : « En ouvrant son système de réservation aux autres compagnies aériennes, AA réalisa un changement de paradigme. Elle n’était plus seulement une compagnie d’aviation, elle était devenue aussi une compagnie de réservation. Mais avec ce glissement de métier ou changement de paradigme, de nouvelles activités venaient de s’ouvrir pour AA. Si elle devenait une compagnie de réservation, alors il convenait d’ouvrir son réseau, non seulement aux autres compagnies d’aviation, mais également à tous les services nécessitant des réservations au cours d’un voyage, comme les hôtels et les voitures de location ». Ainsi, cela obligea la compagnie d’aviation à repenser le voyage comme un tout, et ce, du point de vue de l’usager : un voyage en avion éloignant une personne de chez elle, va certainement aboutir à la réservation d’une chambre d’hôtel, à la location d’une voiture, au recours à la restauration, à des dépenses liées au déplacement. De même le système d’information documentaire se doit de refléter cette reconsidération de point de vue dans une perspective consumériste, s’adapter aux besoins émergents de usagers, étudiant, enseignant ou chercheur (les trois simultanément), en obligeant le bibliothécaire à sortir de son strict périmètre et acquérir une culture qui dépasse son cadre traditionnel. Le système d’information se situe au centre de toutes ces problématiques, et relève indubitablement d’une architecture en rejoignant la philosophie du SOA132 pour accompagner les usagers : leur offrir un service, de la même façon qu’un site de vente offre un service à un client qui le consomme « dans une relation de confiance établie entre les deux parties », et qui ne s’intéresse pas qu’au résultat immédiatement produit. Il faut en outre se demander comment ce service est produit, se poser des questions sur ses contraintes, sur l’organisation économique de laquelle il relève. L’institution qui propose un service, perçoit l’usager qui la sollicite dans son intégralité et peut créer une représentation de l’usager, assortie d’un effort organisationnel important pour mettre en perspective le service avec la réalité de l’usager, et ne pas se cantonner à une vision segmentée, mais créer une vision élargie, cohérente, d’un besoin particulier – exprimé ou pas – qui doit être mis en relation avec l’univers dont il émane, doit prendre en considération la situation du demandeur :

– du cursus d’apprentissage quand il s’agit d’une demande d’un étudiant (connaître l’offre de formation, les dates de périodes d’examens, avoir une idée des contenus des programmes pédagogiques) ;

– du contexte de la recherche quand il s’agit d’un chercheur (quels sont les secteurs de pointe, les événements scientifiques importants, quel est le contexte de production d’articles et outils de diffusion de la recherche ?) ;

– de l’offre de formation quand il s’agit d’un enseignant (connaître le fonctionnement des UFR, l’organisation de l’offre de formation).

De même, la perception du document change pour s’insérer dans ce paysage, et s’appuie avec le numérique sur des « opérations interdépendantes » et non plus « disjointes » (Zacklad, 2011). La production d’une donnée sera mise en relation avec d’autres données, nécessairement, pour aboutir à sa consommation, et les possibilités d’imbrication doivent être imaginées au moment de la création de cette donnée, ce que doit permettre l’architecture du système d’information.

|

Table des matières

Introduction

Problématique générale

L’espace documentaire

Positionnement de nos travaux

Enrichissement des catalogues

Web social

Architecture de l’information

Web sémantique

Méthodes de travail

Observation participante et approche constructiviste

Immersion dans la normalisation et dans les associations professionnelles

Enquête (RDA-en-France, FULBI)

Appui sur la lecture de productions issues des milieux professionnel et scientifique (SIC)

Plan de la thèse

Partie 1 : Points d’entrée, points d’accès : évolution de l’offre de service

1.1 Le catalogue : un univers en crise

1.1.1 Etat des lieux

1.1.1.1 Quelques pas de plus vers la modernité [2000-2010]

1.1.1.2 Les résolveurs de liens

1.1.1.3 Les bases de connaissance (KB)

1.1.1.4 Les problématiques d’accès

1.1.1.5 La fourniture de documents

1.1.1.6 Contenus enrichis

1.1.1.7 Outils et ressources pour les réseaux sociaux

1.1.1.8 La recherche fédérée

1.1.1.9 Eléments de rupture

1.1.2 Deep web vs Internet

1.1.2.1 Le web facteur de rupture

1.1.2.2 Gestion de liens profonds

1.1.2.3 Recherche web et recherche catalographique

1.1.3 Le SIGB

1.1.4. Etat d’informatisation des bibliothèques en France

1.1.5 Synthèse

1.2 Recherche intégrée vs recherche fédérée

1.2.1 Lier des sources hétérogènes

1.2.2 L’interopérabilité dans les systèmes d’information documentaires

1.2.2.1 Dispositifs asynchrones

1.2.2.2 Dispositifs synchrones

1.2.3. Schémas d’interopérabilité

1.2.3.1 Traitement des périodiques

1.2.3.2 Introduction de la notion d’interopérabilité de niveau 2

1.2.3.3 Les grammaires de l’interopérabilité

1.2.4. Intégration OAI-PMH : étude de cas

1.2.4.1 Traitement du titre

1.2.4.2 Traitement de l’auteur

1.2.4.3 Traitement des descripteurs, des mots-clés et de la catégorisation

1.2.4.4 Traitement du niveau

1.2.4.5 Traitement iconographique

1.2.4.6 Recherche multisource

1.2.5. Limites de l’interopérabilité dans un contexte d’intégration (OAI-PMH)

1.2.5.1 Dans la perspective de la politique documentaire

1.2.5.2 Dans une perspective technique

1.2.5.3 Du point de vue de la négociation entre les acteurs

1.2.6. En recherche de compatibilité avec le web

1.2.7 L’échange bibliographique

1.2.8 Pantomime

1.3 L’architecture de l’information

1.3.1 Enjeux de l’interopérabilité

1.3.1.1 Anatomie du Système d’ingénierie documentaire

1.3.1.2 L’interopérabilité : une fin ou un moyen ?

1.3.2 Dialogue entre SID et SI

1.3.3 En recherche de compétitivité : écosystèmes, optimisation de service, évaluation

Conclusion partielle

Partie 2 : L’espace documentaire : lieu de rencontre entre professionnels de l’information-documentation et les usagers. La reconquête de l’intermédiation

2.1 Les outils de gestion de l’information

2.1.1 Qu’est-ce que la collection ?

2.1.2 L’intermédiation en question

2.1.3 Nouvelle donne avec les ERMs

2.1.4 Le cas des périodiques et des publications en série

2.1.5 Des résolveurs de liens pour renforcer le signalement des ressources

2.2 Une nouvelle orientation pour le développement de services

2.2.1 Volte-face

2.2.2 Micro développements au cœur des projets documentaires

2.2.2.1 Combinaisons de données

2.2.2.2 Intégration de contenus enrichis et de services avancés dans les notices de catalogues

2.2.2.3 Exemple de micro service proposé par l’ABES, et de son exploitation locale

2.2.3 De nouvelles méthodologies à l’origine de nouveaux projets

2.3 Evolution de l’offre de service et évolution des métiers

2.3.1 La part du numérique dans le changement

2.3.1.1 Les plateformes de méthodologie documentaire

2.3.1.2 Accompagnement des doctorants

2.3.1.3 Conclusion

2.3.2 Architecture d’accès aux ressources

2.3.2.1 Tunnel VPN

2.3.2.2 Réécriture d’URL

2.3.2.3 Reverse proxy / SSO /ENT

2.3.2.4 Shibboleth

2.3.2.5 Développements ponctuels

2.3.2.6 Pluralité des publics

2.3.3 Vers la fonction découverte : élargissement du périmètre

Conclusion partielle

Partie 3 : L’espace documentaire construit sur la modélisation sémantique des données

3.1 La modélisation des données bibliographiques

Principes généraux

3.1.1 Perspectives historiques

3.1.1.1 L’héritage de l’histoire

3.1.1.2 Le catalogue facteur d’opacité

3.1.1.3 La modélisation FRBR

3.1.1.4 Scénarios d’implémentation dans le monde et en France

3.1.1.5 Entre tradition et innovation

3.1.1.6 Craintes et méfiances

3.1.1.7 De fortes aspirations au changement

3.1.1.8 Des bénéfices pour l’utilisateur

3.1.1.9 Des bénéfices pour les institutions

3.1.2 Pourquoi FRBR ?

3.1.2.1 Un nouveau point de vue

3.1.2.2 Un univers hyperlié

3.1.2.3 Une sortie de crise ?

3.1.2.4 FRAD : extension du modèle FRBR aux données d’autorité

3.1.2.5 FRSAD : extension du modèle FRBR à la notion de sujet

3.1.2.6 De nouveaux principes internationaux de catalogage

Conclusion

3.1.3 L’adoption de RDA et les questions sous-jacentes

3.1.3.1 Comment FRBériser ?

3.1.3.2 Un framework pour l’information bibliographique

3.2 L’innovation des catalogues

3.2.1 Enjeux et perspectives

3.2.1.1 Les chaînes de production de l’information bibliographique

3.2.1.2 Faut-il adopter un outil de gestion commun ?

3.2.1.3 Quelle(s) méthode(s) adopter ?

3.2.1.4 Des avancées progressives

3.2.1.5 Tirer parti des technologies du web

3.2.1.6 …sans chercher à concurrencer le web

3.2.2 Mobilisation et initiatives des acteurs

3.2.2.1 Le Comité stratégique bibliographique

3.2.2.2 Le groupe d’incubation « Bibliothèques et web de données » (W3C)

3.2.3 Sous-groupe « Modélisation de données et évolution des SID » (RDA-enFrance)

3.2.3.1 La question des identifiants

3.2.3.2 La gestion de relations dynamiques avec les référentiels

Conclusion

3.3 Des problématiques à l’échelle planétaire

3.3.1 Mondialisation vs globalisation

3.3.2 La place de l’IST et du document numérique dans le web de données

3.3.3 La bibliothèque universitaire, un accès au patrimoine scientifique de l’humanité

Conclusion partielle

Conclusion générale

4. Bibliographie

5. Glossaire

6. Annexes

Télécharger le rapport complet