Télécharger le fichier pdf d’un mémoire de fin d’études

Les progrès technologiques et informatiques

Cependant les avancées en statistiques seules ne permettent pas de répondre aux enjeux liés à l’explosion des données, qui nécessitent des solutions technologiques appropriées au stockage et au traitement de l’information. Alors que les cartes perforées montrent leurs limites évidentes et que l’ordinateur théorique est déjà imaginé par l’inventeur Charles Babbage, IBM s’attaque en 1937 au projet ASCC, dit Harvard Mark I. Conçu par Howard Hathaway Aiken, ce calculateur électromécanique n’est pas doté de la possibilité de programmation, et fonctionne avec des cartes perforées qu’il est nécessaire de remettre en entrée manuellement en cas de boucle » conditionnelle. En parallèle, le Z3, première machine programmable automatique, est créé entre 1938 et 1941 en Allemagne par Konrad Zuse. La conception des deux premiers ordinateurs entièrement électroniques débute en 1943. Les Etats-Unis lancent le développement de l’ENIAC, et la Grande Bretagne celui du Colossus Mark I. Ce dernier est conçu pour déchiffrer le code Lorenz, utilisé par les Allemands, tout comme le code Enigma, mais seulement pour de rares communications entre hauts dirigeants allemands. Le développement de ces ordinateurs s’est largement appuyé sur les travaux de Turing et de Shannon, et intègrent le calcul binaire. Le développement futur des ordinateurs à travers l’introduction de transistors dans les années 50’ s’appuie sur ce système binaire. D’autres solutions technologiques, comme la compression (Marron & de Maine, 1967) ou VLSI, technologie de circuit intégré permettant la fabrication de puces comprenant des millions de transistors, commencent à faire leur apparition. Lorsque sont conçues les puces électroniques, Moore, directeur de recherche et de développement chez Fairchild Semiconductor et futur co-fondateur de Intel en 1968, formule la conjecture, dite la loi de Moore (Moore, 1965), qui anticipe un doublement de la capacité des composants électroniques tous les 18 mois. Sa conjoncture se vérifie (Fanet, 2008; Schaller, 1997) depuis sa formulation, en traversant la période de développement des circuits intégrés lancés par Intel : tous les 18 mois, le nombre de transistors qui peuvent être installés sur une puce double, avec une baisse des coûts des microprocesseurs, liée aux progrès de la miniaturisation, au traitement collectif de silicium et au parallélisme. Cependant, le manque de fondements de cette conjecture est largement souligné (Kish, 2002; Meindl, 2003), que ce soit en termes théoriques, pratiques ou physiques, en particulier en se basant sur ses limites de consommation énergétique ou de taille de support en silicone, voué à être remplacé grâce au développement des nanotechnologies. En attendant, la baisse des coûts de production des ordinateurs et autres dispositifs développés, notamment la téléphonie mobile, et plus généralement les objets communicants (réseaux de capteurs, mouvement Quantified Self…), permet la multiplication des usages auprès de la recherche, du grand public, des institutions publiques ou des entreprises.

Au-delà de l’aspect technique et industriel, la programmation informatique évolue (Knuth, 1969) et les langages développés donnent la possibilité d’implémenter des algorithmes de plus en plus sophistiqués, appliqués par des programmes. En 1970, Xerox PARC (Palo Alto Research Center) est fondé en Californie par Jacob Goldman et Robert Taylor. Le premier est physicien, travaillant pour Xerox, qui fabrique à l’époque des imprimantes et craint la concurrence japonaise. Le second, Robert Taylor, est directeur du Bureau des techniques de traitement de l’information de l’ARPA au Pentagone, responsable du projet ARPAnet (Taylor & Licklider, 1968), lancé dans le cadre du retard pris sur les soviétiques dans l’aérospatial et précurseur d’Internet. Xerox PARC a alors pour objectif d’accélérer l’innovation pour Xerox, et donne lieu, au cours de la décennie, à la mise en place de standards informatiques, comme l’invention de l’imprimante laser, la souris, la programmation orientée objet, la conceptualisation de l’ordinateur personnel (PC), l’interface graphique utilisateur ou encore Ethernet et le calcul distribué. Ces avancées, couplées avec le développement de l’ergonomie et des sciences cognitives, contribuent à la propagation des ordinateurs auprès d’un public moins expert. A ces progrès s’ajoute la mise à disposition dans le domaine public par le CERN, en 1993, du logiciel World Wide Web, créé quatre années plus tôt par le scientifique britannique Tim Berners-Lee. En s’appuyant sur l’effet réseau (Bomsel, 2007), commun dans les télécommunications, Internet atteint rapidement les ordinateurs personnels, et permet l’explosion de l’univers des objets connectés (IOT, Internet Of Things). Il participe ainsi à l’augmentation du flux informationnel, effaçant (Béra & Méchoulan, 1999) les spécificités des notions de « donnée », « information » ou « communication », et nourrissant l’avènement de la société de l’information (Duff, 2000; Gillies & Cailliau, 2000).

L’un des paradigmes nouveaux en informatique, mentionné plus haut, est le calcul distribué. Il fonde une branche de recherche des sciences mathématiques et informatiques. De nombreux projets permettent des avancées dans ce sens, notamment des projets utilisant la bande passante inutilisée des ordinateurs personnels connectés. A Berkeley, Seti@home, projet utilisant des ordinateurs reliés à internet pour la recherche d’une intelligence extraterrestre en analysant une quantité de signaux impossible à traiter jusqu’alors, est rendu public en 1999 et prouve, entre autres et pour commencer, la fiabilité du calcul distribué. Le calcul distribué est utilisé en mathématiques à partir de 1996 pour divers projets scientifiques marqués par une limite infinie de solutions comme GIMPS (recherche de nombres premiers) ou distributed.net (recherche sur le chiffrement et les règles de Gollomb), ou bien dans la branche cryptologie. En informatique, la recherche sur le parallélisme se développe avec l’étude de langages comme le π-calcul de Milner, pour fusionner avec le domaine de calcul distribué grâce au déploiement d’Internet. Ces technologies sont utilisées en science pour les supercalculateurs comme Roadrunner avec une application à des domaines très variés, et s’imposent en paradigme dominant dès le début du millénaire grâce à la décroissance du coût de matériel permettant la construction des systèmes à multiprocesseurs, mais aussi grâce aux progrès dans l’intégration à très grande échelle et l’augmentation de la vitesse de traitement des ordinateurs.

D’autres progrès technologiques marquent ce début du siècle, dont certains sont régulièrement cités comme associés au phénomène Big Data (Varian, 2014). Tout d’abord, le modèle de programmation MapReduce distribué, développé en 2004 par Google (Dean & Ghemawat, 2004), puis breveté en 2010 (Dean & Ghemawat, 2010), permet d’accéder et de manipuler les données dans des structures de données volumineuses, comme BigTable, table de données présente dans le système GoogleFS. Sur ce parton d’architecture s’appuient des frameworks comme Hadoop, créé en 2009 par Doug Cutting et récupéré par Yahoo avec son créateur. Le modèle MapReduce est jugé prometteur (Ranger et al., 2007), la technologie Hadoop, en open source, est largement reprise dans les logiciels comme Oracle, Microsoft, IBM ou EMC, et donne lieu à de nouveaux développements, tels que Spark qui connait un succès croissant en 2015. Ensuite, le Cloud, comme moyen d’exploitation de la puissance de calcul ou de stockage distance à travers internet, fait son apparition progressivement (ASP, mails, CRM) et le terme se popularise dès 2006 grâce à l’introduction de l’Elastic Compute Cloud par Amazon.com. Par ailleurs, les outils de Business Intelligence, qui comprennent généralement des bases de données relationnelles extraites par des ETL pour être chargées dans un Data Warehouse structuré, puis requêtées pour des besoins de reporting et de prise de décision, s’adaptent à l’apparition des systèmes de stockage qui utilisent des bases de données orientées objet, grâce l’évolution des langages de traitement de l’information comme le NoSQL (Not Only SQL).

En réaction, les fournisseurs de bases de données relationnelles s’ajustent avec des structures horizontales utilisant les langages NewSQL, comme MySQL. Ces progrès guident la constitution du concept de Data Lake, outil de stockage de données dans leur format natif, qui, contrairement à un Data Warehouse classique, s’affranchit du besoin de structuration amont (voir Annexe 2 – Data Lakes et Informatique Décisionnelle). Enfin, les outils de Data Visualisation évoluent (Tableau, Target…) pour permettre la représentation de données plus volumineuses de façon ergonomique. Ces évolutions constituent le socle technologique des opportunités liées au phénomène Big Data en 2015.

Il semble complexe de trancher entre les tenants du principe que la technologie ait été développée en conséquence des besoins militaires, gouvernementaux, scientifiques ou individuels (Edmunds & Morris, 2000), et les défenseurs de l’idée que les possibilités offertes par le progrès technologique aient crée un vide et tiré l’explosion des données (Tjomsland, 1980). De même, le débat entre l’explosion d’information comme continuité des progrès passés (Barnes, 2013) ou comme révolution (Gillies & Cailliau, 2000; Mayer-Schönberger & Cukier, 2013; McAfee & Brynjolfsson, 2012) reste ouvert. Les efforts de standardisation sur la mesure de l’information (Coffman & Odlyzko, 1998; Dienes, 1994; Pool, 1984; Varian & Lyman, 2003) butent sur l’absence de consensus autour de la définition de celle-ci (Hilbert, 2012). Pourtant, les points de vue s’accordent sur les difficultés à absorber cette information, et la nécessité d’avoir recours à des machines pour préserver la possibilité de découvrir de nouvelles connaissances dans les données (Denning, 1990; Lesk, 1997) ou bien simplement pour visualiser (Cox & Ellsworth, 1997a) de façon digeste l’information existante. Les fruits de la convergence des écoles en statistiques et les derniers progrès en informatique peuvent alors apporter des réponses à l’enjeu de l’explosion des données.

Le « Big Data » : des origines du terme au phénomène sociotechnique

Le terme « Big Data » semble éclore dans la littérature scientifique en informatique, en mai 1997 dans la publication « Managing big data for scientific visualization » (Cox & Ellsworth, 1997b). Les deux auteurs de l’article sont alors chercheurs en infographie à NASA Ames Research Center, centre de recherche à vocation militaire et civile pour l’aviation américaine, et leurs publications précédentes ciblent le rendu par la programmation parallèle (parallel rendering, ou distributed rendering). L’article en question soulève le concept de Big Data en tant que problème en cours de résolution par les applications commerciales classiques, comme les systèmes de réservation des compagnies aériennes, et par les applications plus récentes, comme le stockage et la fédération de bases de données. Ce problème étant moins appréhendé par l’ingénierie et la visualisation scientifique, l’article fournit des explications en gestion de données, à partir notamment de l’étude sur la visualisation d’écoulement de fluides. Les auteurs continueront à aborder le sujet Big Data sous l’angle de la visualisation des données (Bryson et al., 1999), mais l’apport majeur pour la définition de « Big Data » de ce premier article, qui s’inscrit dans un débat à la NASA sur l’intérêt de l’automatisation ou de l’interaction (Kenwright, 1999) face au Big Data, est la première utilisation du terme associé à une définition qui se précise. Il s’agit de l’accumulation de deux problèmes distincts : « Big Data Collections » et « Big Data Objects ». Le premier correspond à l’agrégation d’un grand nombre de bases de données en provenance de plusieurs sources, souvent pluridisciplinaires, et généralement distribués sur des sites physiques et types de référentiels différents. Le second indique un ensemble de données trop volumineux pour être traité par des algorithmes et logiciels standards sur le matériel disponible. « Big data objects » sont particulièrement problématiques lorsqu’ils sont générés par la méthode de simulation de phénomène physique dans divers domaines scientifiques, comprenant la dynamique des fluides, l’analyse structurelle, la modélisation météo ou l’astrophysique. La combinaison de ces deux problèmes est alors de plus en plus répandue, notamment avec l’approche scientifique double alliant l’expérimentation et la simulation. Big Data, en tant que méthode combinatoire de recherche utilisant l’informatique, est par ailleurs présentée dans des publications scientifiques dans d’autres domaines, comme la génomique (Lenski, 2002).

La seconde apparition du terme « Big Data », sans lien traçable avec la première, a lieu en statistiques dans la préface du livre « Predictive Data Mining » (Weiss & Indurkhya, 1998) de Page 24 sur 419 Weiss et Indurkhya en 1998 lorsqu’ils décrivent le volume de données accumulées dans des entrepôts centralisés de stockage de données. Cette masse de données représente alors une opportunité théorique avec un renforcement des conclusions, mais aussi une difficulté pratique pour ses applications de Data Mining, les techniques duquel sont traitées dans le livre. Il s’agit de l’extraction, de la transformation et de l’organisation de données brutes en vue d’effectuer des recherches multidimensionnelles pour des solutions prédictives. Big Data n’est pas traité en tant que concept, mais comme la première caractéristique du Data Mining, la seconde étant le nombre de dimensions, sujet principal du livre. Plusieurs publications en statistiques se réfèrent à cette définition, comme en 2001 le livre « Data Mining for design and Manufacturing : methods and applications » (Braha, 2001), où, dans un chapitre rédigé avec deux ingénieurs industriels, Dan Braha précise les caractéristiques du Big Data (p.236 : « many variables, many values, and many records »), composante du Data Mining englobant et le nombre d’observations, et leur richesse en termes de dimensions. Cette publication met en évidence le changement dans l’approche scientifique : les techniques de Data Mining dans un contexte Big Data constituent alors une clé permettant de passer d’un modèle de recherche classique guidé par les hypothèses à une approche nouvelle basée sur la donnée.

La définition de Big Data comme accumulation de données stockées décrite par Weiss et Indurkhya est par ailleurs reprise en science informatique après l’intervention de John Mashey en conférence annuelle à USENIX en 1999. Il présente la notion d’Infrastress, due au Big Data (accroissement accélérée du stockage) ainsi qu’à la croissance de l’attente des utilisateurs du Net en termes de type de données différentes et complexes. Notons que ces deux facteurs sont bien distincts, mais leur représentation confondante conduit le lecteur à envisager le Big Data comme un déluge d’information tout court auquel fait face le progrès technique actuellement. La recherche dans la base de données ACM (Association for Computing Machinery digital library) du terme « Big Data » indique par ailleurs que les premières utilisations du terme par d’autres chercheurs dans le domaine SI ont lieu suite à cette conférence de 1999, en particulier dans la recherche sur le World Wide Web (Gschwind & Hauswirth, 1999) ou en gestion de systèmes de fichiers (Randolph Y. Wang et al., 1999).

En 2000, le terme « Big Data » apparait accompagné d’une définition nouvelle dans la publication en statistiques et économétrie de Francis X. Diebold « Big Data Dynamic Factor Models (DFM) for Macroeconomic Measurement and Forecasting » (Diebold, 2012) et désigne un phénomène se référant à « l’explosion en quantité (et parfois qualité) de données disponibles et potentiellement pertinentes ». L’objectif du terme utilisé consiste alors à marquer le contraste entre l’ancien et le nouvel environnements économétriques DFM décrits par Reichlin et Watson, mais aussi mettre en évidence cette nouvelle caractéristique commune à un ensemble de domaines de recherche plus large que l’économétrie. En effet, le Big Data est un phénomène auquel est confrontée et dont bénéficie la recherche scientifique en physique, biologie et sciences sociales. Ce phénomène nouveau est induit par des avancées technologiques significatives, touchant d’une part à la création, et d’autre part au stockage de données.

Enfin, le terme « Big Data » fait son apparition dans le marketing en 2005 (Ratner, 2004), où la nouveauté est lié à l’entrée dans le domaine, jusqu’alors basé sur la statistique classique, de l’architecture orientée évènement, ou EDA (Event-Driven Architecture). Celle-ci est permise pour un grand volume de données par la possession d’ordinateurs personnels et inverse la relation fournisseur-client classique grâce à l’émission par un service d’un évènement auquel le client doit répondre. Ratner précise qu’il reprend le concept de « Big Data » de Wiess et Indurkhya tout en appuyant d’autres caractéristiques, à savoir son opposition avec « Small Data », représentable sous forme de table de lignes (observations ou individus) et de colonnes (variables ou paramètres) pour un échantillon atteignant rarement 200 lignes pour une poignée de colonnes, caractérisée par sa « propreté » et sa complétude. L’ajout de la notion d’évènement extérieur, la multiplication des tables et l’existence de données secondaires (captées en parallèle de celles qui devaient servir un objectif prédéfini) poussent à revoir les techniques de l’échantillonnage et les méthodes de calcul de répartition, ce qui constitue selon lui le phénomène Big Data.

Le terme se structure progressivement autour d’un ensemble de concepts issus des paradigmes informatiques et statistiques pour être transposés en économétrie et en marketing, et globalement dans un jargon plus commun au service du Data Management moderne. En particulier Doug Laney rédige en 2001 une note de recherche de Gartner, à l’époque META Group (Laney, 2001) où il associe au Big Data trois dimensions : « 3D Data Management : Controlling Data Volume, Velocity, and Variety ». Aucune limite quantitative n’est alors précisée pour que les dimensions soient propres au Big Data, cependant Laney annonce la nécessité pour les entreprises, de e-commerce notamment, de contrôler ces facteurs dont l’ampleur croit rapidement, et donne des solutions concrètes afin de les maîtriser. Gartner affiche alors cette définition du terme Big Data : « Big data is high-volume, high-velocity and high-variety information assets that demand cost-effective, innovative forms of information processing for enhanced insight and decision making ».

Ces dimensions sont rapidement reprises sous l’abréviation des « 3V », et enrichies sans modération par des « V » supplémentaires, comme la « Valeur », la « Vulnérabilité », mais aussi la « Validité », la « Versatilité », la « Visibilité » ou la « Véracité », voire d’autres dimensions encore moins inspirées, comme la « Complexité ». Les grands acteurs du marché de l’informatique, comme IBM, Microsoft, SAS et leurs observateurs donnent chacun leur propre définition de Big Data, mettant généralement en valeur l’opportunité que le Big Data représente pour un client. La communauté de professionnels Opentracker recense ainsi plus d’une trentaine de définitions du terme1. Pour résumer, il s’agit soit d’outils et de processus permettant à une organisation de capturer, créer, traiter et gérer une masse de données importante, soit d’un ensemble de données qui devient tellement volumineux qu’il en devient difficile à travailler avec des outils classiques de gestion de bases de données ou de gestion de l’information. Malgré l’absence de consensus apparent sur l’objet pointé par le terme, l’intention commune dans l’arène commerciale publique est de désigner une évolution technologique actuelle, basculant les entreprises vers des solutions d’une nouvelle génération.

Ce sens est limité par son manque de spécificité et de limites de l’extension du concept. En effet, une définition similaire était d’ores et déjà attribuée (Senge, 1990) à l’information en entreprise dans les années 90, et rien dans la définition ne fait référence à la nature des outils classiques, ni ne quantifie les seuils. Enfin, le concept même d’« ensemble des données » est discutable. Pourtant, cette définition des « 3V » reste actuellement courante, et sera saluée par Francis X. Diebold lorsqu’il reviendra sur son terme en 2012 (Diebold, 2012). Il s’affranchit alors de toute définition quantitative, propose de considérer le Big Data comme un phénomène évolutif, et l’élève au niveau d’une discipline émergeante, intégrant des concepts tels que le Cloud Computing ou les algorithmes massivement parallèles. Ces concepts ne sont pas, selon lui, couverts par les domaines de science existants seuls, comme la statistique ou l’informatique. Diebold s’attribue à cette occasion le mérite de la première définition du terme en citant un ensemble d’apparitions du terme dans des publications académiques et non académiques.

OpenTracker est la version Open Source des outils de gestion de fichiers et de web analytics, animée depuis 2001 par des webmasters et des professionnels de marketing qui les utilise. https://www.opentracker.net/article/definitions-big-data/

L’un des efforts de formulation les plus intéressants au sein de la communauté scientifique (Boyd & Crawford, 2012) consiste à définir le Big Data comme « un phénomène culturel, technologique et scientifique qui repose sur l’interaction entre :

La technologie : maximisation de la puissance de calcul et de la précision algorithmique dans le recueil, l’analyse, la liaison et la comparaison des grands ensembles de données

L’analyse : représentation à partir de grands ensembles de données pour identifier des tendances (« patterns ») afin de réaliser des déclarations économiques, sociales, techniques et juridiques

La mythologie : croyance largement répandue que de grands ensembles de données offrent une forme supérieure de l’intelligence et des connaissances qui peuvent générer des idées (« insights ») qui étaient auparavant impossibles, avec une aura de vérité, d’objectivité et d’exactitude » L’intérêt de cette définition est de mettre en valeur non pas les caractéristiques des données (les 3V », notions relatives et difficiles à cerner), mais bien les processus associés au traitement des données, c’est-à-dire l’optimisation permise par une technologie et les capacités de représentation facilitant une analyse pour une prise de décision. Ces deux caractéristiques ne semblent pas pourtant pointer une nouveauté particulière en dehors des progrès au niveau des outils et processus associés. Cependant, grâce à la troisième caractéristique, cette définition embrasse la prise de conscience et le buzz autour du phénomène, tout en les mettant en perspective de façon critique. Dans la suite de cette thèse, le Big Data portera le sens de cette définition, en considérant le Big Data comme un phénomène sociotechnique dont les avantages réels devraient être critiqués et examinés avec attention.

Le rapport de stage ou le pfe est un document d’analyse, de synthèse et d’évaluation de votre apprentissage, c’est pour cela chatpfe.com propose le téléchargement des modèles complet de projet de fin d’étude, rapport de stage, mémoire, pfe, thèse, pour connaître la méthodologie à avoir et savoir comment construire les parties d’un projet de fin d’étude.

|

Table des matières

Introduction du contexte

1 L’homme et la donnée : un historique multidisciplinaire

1.1 La donnée, une affaire d’Etat millénaire

1.2 Les progrès technologiques et informatiques

1.3 Le « Big Data » : des origines du terme au phénomène sociotechnique

2 Les enjeux Big Data pour les communautés d’acteurs

2.1 Les pouvoirs publics au service de la recherche et de l’Ecosystème Big Data

2.2 Le buzz face au grand public et aux entreprises

3 Une prise de position des SIC au coeur du phénomène Big Data

3.1 Débat épistémologique

3.2 Spécificités de l’angle de vue

Première partie : Problématique et cadre conceptuel

1 Problématique

1.1 Les processus propres aux dispositifs projet data sont-ils efficients ?

1.2 Quelle est la valeur générée par ces projets ?

1.3 Quelle est la nature de la médiation humaine dans les projets de Data Science ?

2 Plan de thèse

3 Cadre conceptuel

3.1 Processus du projet data

3.1.1 Projet, gestion de projet et processus

3.1.2 Modélisation de processus en Data Science

3.1.3 Méthodes de prise en compte de la technologie dans le processus data

3.1.4 Synthèse des limites des modèles actuels et pistes de recherche

3.2 Indicateurs de valeur

3.2.1 Entreprise, stratégie, savoir-faire et usages

3.2.2 Mesure de la performance et prise de décision

3.2.3 Valeur de l’information et de la donnée

3.2.3.1 Le paradoxe de la valeur économique de l’information

3.2.3.2 Chaine de valeur de la donnée

3.2.3.3 Valeur des usages issus des progrès sur la chaine des données

3.3 Qualité des données

3.3.1 Des approches opérationnelles différents selon les disciplines

3.3.1.1 Le besoin de qualité pour les Sciences de Gestion

3.3.1.2 La réponse de l’Informatique : des indicateurs de qualité génériques

3.3.1.3 Les SIC : une approche de la qualité des données orientée sur le sens

3.3.2 Enjeux de gouvernance à l’échelle de l’entreprise

3.3.3 L’algorithme, un nouveau type de modèle de données à qualifier

3.4 Médiation Homme-Données et co-construction de sens

3.4.1 Acteurs et cadre de compétences mobilisées

3.4.1.1 Intelligence Economique et Knowledge Management, en retrait

3.4.1.2 Médiateurs humains et techniques

3.4.1.3 Data Scientists : un nouvel éventail de compétences encore instable

3.4.2 Interactions au sein d’un projet data

Deuxième partie : Terrains et Méthodes

1 Choix du terrain

2 Approche méthodologique

2.1 Recherche-action

2.2 Posture du chercheur

2.3 Etude de cas multiples

2.4 Stratégie d’observation

2.4.1 Un protocole construit et sous contraintes

2.4.2 Conception de l’échantillon d’études de cas

2.4.3 Recueil d’observations et modélisation itérative de résultats

Troisième partie : Résultats

1 Exposé des études de cas

1.1 Synthèse des études de cas

1.2 Pré-expérimentation

1.2.1 Cas A : Dispositif télématique « urgence »

1.2.1.1 Contexte et enjeux

1.2.1.2 Synthèse des résultats

1.2.1.3 Observations clés

1.2.2 Cas B : Cancer du sein triple négatif

1.2.2.1 Contexte et enjeux

1.2.2.2 Synthèse des résultats

1.2.2.3 Observations clés

1.2.3 Cas C : Placement Publicitaire

1.2.3.1 Contexte et enjeux

1.2.3.2 Synthèse des résultats

1.2.3.3 Observations clés

1.3 Cas réalisés et détaillés

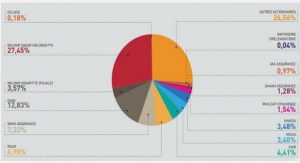

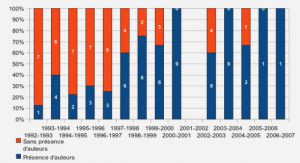

1.3.1 Cas 1 : Attrition en assurance santé

1.3.1.1 Contexte et enjeux

1.3.1.2 Synthèse des résultats

1.3.1.3 Observations clés

1.3.1.4 Compte rendu du projet

1.3.2 Cas 2 : Prévision d’activité

1.3.2.1 Contexte et enjeux

1.3.2.2 Synthèse des résultats

1.3.2.3 Observations clés

1.3.2.4 Compte rendu du projet

1.3.3 Cas 3 : Prévention santé prévoyance

1.3.3.1 Contexte et enjeux

1.3.3.2 Synthèse des résultats

1.3.3.3 Observations clés

1.3.3.4 Compte rendu du projet

1.3.4 Cas 4 : Contrôles de non-conformité

1.3.4.1 Contexte et enjeux

1.3.4.2 Synthèse des résultats

1.3.4.3 Observations clés

1.3.4.4 Compte rendu du projet

1.4 Cas réalisés non détaillés

1.4.1 Cas 5 : Sinistres lourds en dommage aux biens

1.4.1.1 Contexte et enjeux

1.4.1.2 Synthèse des résultats

1.4.1.3 Observations clés

1.4.2 Cas 6 : Prédiction des prix des agrumes

1.4.2.1 Contexte et enjeux

1.4.2.2 Synthèse des résultats

1.4.2.3 Observations clés

1.4.3 Cas 7 : Multi-équipement

1.4.3.1 Contexte et enjeux

1.4.3.2 Synthèse des résultats

1.4.3.3 Observations clés

1.5 Etat des lieux des observations clés

2 Modèle de dispositif projet Data Science et ses dimensions dégagées

2.1 Modèle CRISP_DM et études de cas : analyse comparative

2.1.1 Critique des phases, des tâches et des résultats

2.1.1.1 Prise en compte tardive des usages

2.1.1.2 Facilitation insuffisante de l’interprétation des résultats

2.1.1.3 Insuffisance de la tâche de sélection des données

2.1.2 Critique des dépendances et de la cyclicité

2.2 Proposition de modèle de dispositif de projet data : Brizo_DS

2.2.1 Orientation sur usage

2.2.1.1 Nouveauté des usages

2.2.1.2 Usages directs et indirects

2.2.1.3 L’interaction comme vecteur de convergence sur les usages

2.2.2 Indicateurs clés : bénéfices, ressources et incertitudes

2.2.2.1 Bénéfices

2.2.2.2 Ressources

2.2.2.3 Incertitudes

2.2.2.4 Cadre d’évaluation

2.2.3 Processus de réduction d’incertitudes

2.2.3.1 Réduction d’incertitudes analytiques

2.2.3.1.1 Livrables intermédiaires de la production analytique

2.2.3.1.2 Chemin de traitement des données et gestion des versions

2.2.3.2 Réduction d’incertitudes métier

2.2.3.3 Dynamique de réévaluation des incertitudes projet

2.2.3.4 Tactiques d’allocation de ressources

2.2.3.5 Suite et élargissement : vers une gestion de portefeuille de projets data

2.3 Qualité des données

2.3.1 Databook : documentation dynamique de la qualification des données

2.3.2 Gouvernance des données et métriques propres aux algorithmes

2.4 Dispositif de Médiation Homme-Données

3 Discussion des limites de ces travaux de recherche

3.1 Spécificités du terrain chez Quinten

3.2 Limites de la recherche action

3.3 Un marché non stabilisé

Conclusions et perspectives de recherche

1 Un nouveau modèle de dispositif « projet data » : Brizo_DS

2 La valeur des projets data

2.1 La valeur de la réduction d’incertitudes

2.2 Databook : une mémoire de la dynamique de construction des algorithmes

3 Médiation Homme-Données

4 Pistes de recherche

Bibliographie

Annexes

Télécharger le rapport complet