La remise en question de la notion conventionnelle de guerre à travers le développement de l’armement utilisant l’IA

Le développement de l’armement intégrant l’IA remet fortement en question la notion conventionnelle de guerre. L’IA apporte en effet une dimension supplémentaire à n’importe quelle arme : l’autonomie. En d’autres termes, l’IA permettrait une plus grande rapidité d’analyse et d’exécution, et donc la possibilité d’opérer plus ou moins sans intervention humaine, en fonction du degré d’autonomie. C’est pourquoi, depuis quelques années, avec les avancées et les innovations dans le secteur de l’IA militaire, un débat épineux sur la capacité de prise de décision des armes à IA intégrée a émergé.

Les défis apportés par des armes au niveau d’autonomie croissant

Brice Erbland définit l’autonomie comme un « système [qui est] capable de mener un raisonnement à chaque fois unique quelle que soit la situation perçue pour décider de la meilleure action à mener » (2018, p. 13). Cette autonomie est notamment classée selon l’ONG Human Right Watch en trois niveaux d’intervention humaine dans le processus d’ouverture du feu.

In the loop : une arme intelligente au service de l’Homme

Dans une autonomie in the loop, littéralement « dans la boucle », l’Homme est dans la boucle d’action et de décision et supervise l’intelligence artificielle. Le modèle d’autonomie est donc faible.

Cela signifie que l’IA a besoin de l’intervention humaine, à la fois dans l’entraînement et dans la période de tests de construction d’un algorithme. Il y a donc un système de retour sur expérience continu, où l’Homme valide ou invalide les résultats obtenus par l’IA, ce qui permet à l’algorithme d’améliorer les résultats à chaque fois. Le système human in the loop est intégré à travers deux processus de machine learning : l’apprentissage supervisé et non supervisé. Dans le machine learning supervisé, des groupes de données sont utilisés par des experts afin d’entraîner les algorithmes à faire des prédictions correctes lors d’utilisations à venir. Plus tard, les résultats fournis sont vérifiés et évalués : s’ils sont considérés comme erronés, des ajustements sont faits aux algorithmes, ou bien les données sont vérifiées et redonnées aux algorithmes jusqu’à obtenir un résultat correct (Singh Binsen, 2020).

Ainsi, dans le cadre militaire, les armes avec une autonomie human in the loop sont celles où le robot sélectionne les cibles mais pour lesquelles l’Homme prend la décision finale d’ouvrir le feu. À proprement parler, ces types d’armes ne peuvent pas véritablement être qualifiées d’« autonomes » : elles se rapprochent plus des armes télécommandées, donc contrôlées à distance.

Les drones sont un exemple parlant de ce type d’autonomie. Le marché du drone, en pleine expansion depuis les années 2010, s’est beaucoup développé dans le secteur civil. Dans le domaine militaire, la famille des drones est subdivisée en sous-catégories selon leur vitesse, leur rayon d’action et leurs fonctions : on trouve par exemple les micro et mini drones, les drones tactiques, lents ou rapides, à endurance moyenne ou haute ; les drones volant à haute altitude et de grande endurance appelés HALE (High Altitude Long Endurance), ou encore les drones de combat, appelés UCAV (Unmanned Combat Air Vehicle). Actuellement, les drones développés sont capables de détecter d’éventuelles cibles, mais sont toujours sous contrôle humain : en cas de menace réelle, c’est l’Homme qui ouvrira le feu et lancera l’attaque.

Toujours selon M. Erman, la reconnaissance de cibles dans une image de manière automatique et instantanée est une priorité dans le domaine du renseignement. Il donne ainsi l’exemple des Rafales, que Thales a proposé d’équiper d’une capacité de reconnaissance embarquée à la Direction générale de l’armement. Un avion avec cette capacité constituerait un atout pour les armées françaises afin d’accélérer le tempo des missions. « Aujourd’hui, les images prises par l’appareil sont analysées une fois que l’avion est rentré à sa base. Il s’agit d’un travail titanesque. Sur une heure de vol, un Rafale fournit une cartographie d’environ 3 000 km. Or un bon analyste militaire va analyser en moyenne 10 km en une heure » (Erman, 2019, cité dans l’Usine Nouvelle). Une IA intégrée dans un Rafale permettrait donc une analyse instantanée et un gain de temps considérable.

On the loop : une prise de décision partagée

Avec une autonomie de type on the loop, ou « sur la boucle » en français, on parle d’un modèle non pas basé sur un contrôle total, mais sur une collaboration entre l’Homme et l’IA. Ici, l’Homme peut être le commandant ou bien seulement exercer un droit de veto.

Ainsi, les armes à l’autonomie human on the loop sont celles où le robot sélectionne les cibles et prend la décision d’ouvrir le feu, mais où l’Homme peut intervenir avant l’ouverture du feu et annuler la décision. Ce type de système très élaboré est déjà une réalité.

Un des exemples les plus connus se trouve en Corée. Le robot SGR-A1 de Samsung Techwin, installé dans la zone démilitarisée entre la Corée du Sud et du Nord, tout en étant supervisé par l’Homme, peut détecter, identifier et traiter une cible de façon automatique, tout en faisant les sommations d’usage (de Boisboissel, 2016).

Les capacités d’analyse de ce type d’IA sont considérablement accrues. La combinaison de la capacité humaine et de la maîtrise des algorithmes de la machine améliore l’efficacité et les capacités de traitement. Par rapport au modèle in the loop, ce type d’IA nécessite donc moins d’interventions humaines, ce qui permet de déléguer un plus grand nombre de tâches.

On note ici également une vraie possibilité de gain de temps : la machine étant plus rapide que l’opérateur humain dans ses analyses, diagnostics et décisions, celui-ci n’a plus qu’à valider ou invalider la décision finale.

Concernant les faiblesses d’une telle IA, à l’instar du modèle précédent, une décision humaine demeure nécessaire dans le processus. Si ce type d’autonomie permet un gain de temps, les capacités cognitives et de réaction de l’Homme ralentissent ici aussi relativement le processus d’action, et amoindrissent donc les capacités de la machine. De plus, si les robots doivent toujours recevoir des ordres pour opérer dans le champ de bataille, les forces ennemies peuvent facilement perturber l’armée en interrompant la communication entre ces deux terminaux.

Un autre risque provient de la confiance excessive accordée par l’Homme aux machines.

L’IA étant censée être plus rapide, plus efficace et plus performante que l’Homme, celui-ci risque de ne plus questionner les résultats, manquer de discernement et considérer la machine comme infaillible, même si l’IA peut avoir un fonctionnement défectueux. Il est donc nécessaire que les décideurs maintiennent un certain scepticisme quant à l’application de l’IA aux systèmes militaires.

Le dysfonctionnement du système informatique de l’USS Vincennes en est un bon exemple, cité dans Wired for War: The Robotics Revolution and Conflict in the 21st Century (Singer,2009). Le 3 juillet 1988, au milieu de la guerre Iran-Irak (1980-1988), ce nouveau système, introduit pour aider à défendre les navires de la marine contre les attaques aériennes, enregistra l’avion de ligne Iran Air Flight 655 qui survolait le golfe Persique comme un chasseur iranien F-14 et donc un « ennemi présumé ». Même si les données indiquaient à l’équipage de l’USS Vincennes que l’appareil n’était pas un avion de chasse, aucun des 18 marins et officiers de l’équipage de commandement de l’USS Vincennes n’était prêt à remettre en cause l’ordinateur. Ils validèrent ainsi la décision d’abattre l’avion, tuant les 290 passagers civils et membres d’équipage par erreur.

Il existe donc déjà quelques exemples d’applications militaires de ce type d’IA. Dans la communauté académique et technologique, ce modèle est actuellement reconnu comme le nouvel objectif de développement de l’intelligence artificielle. Cependant, en raison des problèmes moraux et éthiques que cette IA pose, il est difficile pour l’Homme de vraiment quitter la boucle de décision. Par conséquent, les discussions, la recherche et le développement dans ce domaine sont très controversés.

Out of the loop : une délégation de contrôle aux répercussions tactiques et éthiques

L’autonomie out of the loop, « hors de la boucle », est un système qui repose sur une autonomie complète, c’est-à-dire sans supervision ni intervention humaine. L’IA y joue un rôle de chef militaire, ce qui lui donne la capacité de s’adapter au changement d’environnement, d’analyser le contexte et de décider des actions à suivre. Autrement dit, les armes human out of the loop sont celles où l’Homme n’a plus que le rôle de spectateur.

Jusqu’à présent, le système militaire s’approchant le plus de ce type d’autonomie est le Dôme de Fer déployé par Israël. Il est composé de trois éléments : un radar de détection et de pistage, un logiciel de gestion de combat et de contrôle de l’armement et trois lanceurs composés de 20 missiles intercepteurs chacun. Lorsqu’un tir ennemi est repéré par le radar, le logiciel de contrôle se lance pour identifier le type de projectile, calculer sa trajectoire et déterminer son point d’impact probable. Si la roquette vise une zone habitée, le système anti-missiles entre automatiquement en action. Il actionne alors l’un des trois lanceurs pour envoyer dans les airs un missile d’interception.

Des stratégies de recherche et développement révélatrices de l’enjeu militaire que représente l’IA

Comme évoqué plus tôt, bien que la partie la plus brûlante du débat se focalise sur les armes dotées d’IA à degré d’autonomie variable, beaucoup d’instruments de guerre avec une IA intégrée servent aussi, voire exclusivement, à des missions de collecte de données, de renseignement ou encore d’analyse. Sans compter la cyberdéfense, qui n’est pas le sujet de ce mémoire, mais qui crée à elle seule beaucoup d’engouement et de polémique à la fois. À ce jour, la recherche se focalise sur tous les aspects de l’IA qui peuvent aider une armée à prévenir tout type de conflit. La folle course à l’armement qui avait bouleversé le monde avec l’apparition de l’arme nucléaire il y a quelques décennies s’est désormais tournée vers une nouvelle arme, plus discrète, mais peut-être aussi pour cette même raison plus révolutionnaire et plus létale.

En effet, si tout l’enjeu de l’arme nucléaire était de s’en munir dans le but de dissuader l’ennemi et en espérant ne jamais avoir à s’en servir, la course à l’IA est, quant à elle,motivée par un profond désir d’en fournir tous les corps de l’armée et de la déployer sur tous types de terrain. La démarche étant extrêmement coûteuse, pour l’instant seule une poignée de Nations sont prêtes à faire le pas, avec des degrés d’investissement différents.

D’après l’analyse de nos recherches, il nous a été possible de départager les quatre principales puissances de notre étude en deux catégories (d’une part les États-Unis et la Chine, d’autre part la Russie et l’Union européenne) que nous expliciterons ci-dessous.

Les États-Unis et la Chine : une course à l’armement

Tout d’abord, il est important de se pencher sur les budgets que chaque puissance accorde à la recherche et au développement dans le secteur militaire, et plus particulièrement aux dépenses liées à l’IA. Les États-Unis, première puissance militaire mondiale depuis la fin de la Guerre froide, sont tout naturellement la nation qui investit le plus dans sa défense. Avec un budget annuel officiel de 718,3 milliards de dollars en 2020, dont 927 millions dédiés à l’IA (Gould, 2019), le secteur militaire est le deuxième sur la liste des investissements étatiques (Amadeo, 2020). En parallèle, la Chine déclare officiellement avoir adopté un budget de 183,5 milliards de dollars pour le secteur militaire en 2020, dont 70 millions réservés à l’IA selon l’article du CSIS (Centre d’études stratégiques et internationales) publié sur sa plateforme China Power (2020).

L’écart est gigantesque ; et pourtant, il ne faut pas s’arrêter à cette première lecture. D’une part, la Chine reste le plus gros concurrent des États-Unis en termes d’investissement militaire purement sur l’aspect financier et, d’autre part, en 2021, tandis que le budget militaire chinois s’est vu augmenté de 14 % pour arriver à 209,2 milliards de dollars, le budget état sunien a chuté de 1,8 % pour un total de 705,4 milliards de dollars, dont 841 millions pour l’IA (une baisse de 9,2 % comparé à 2020).

La Russie et l’Europe : d’anciennes puissances désormais dépassées

Contrairement aux États-Unis et à la Chine qui se placent en tête de la course à l’IA, l’Europe et la Russie sont légèrement en retard sur son développement. Cependant, les deux entités ont récemment établi des stratégies et plans de financement qui démontrent une volonté de rattraper ce retard afin de ne pas laisser les deux géants dominer le terrain.

L’Union européenne possède le troisième plus gros budget militaire au monde après les États-Unis et la Chine. Il est trois fois et demi supérieur à celui de la Russie (246,3 milliards de dollars contre 69,2 milliards) (Simpere, 2018). L’UE estime qu’une meilleure coopération entre ses États membres permettrait de rationaliser les dépenses. Cependant, il n’existe actuellement aucune politique militaire commune en Europe. Un budget est attribué à certaines industries mais il n’y a pas d’application sur le terrain ou de stratégie à proprement parler.

Du côté russe, Vladimir Poutine a approuvé en 2019 la Stratégie nationale de développement de l’intelligence artificielle, avec des objectifs qui s’étendent jusqu’à 2030 avec une date butoir en 2024. Selon lui « le leader de l’IA deviendra le maître du monde », c’est pourquoi le gouvernement russe a débloqué 2 milliards de dollars grâce à une levée de fonds d’investisseurs étrangers (bne IntelliNews, 2019). Ces fonds sont destinés à la recherche, mais également à la formation dans le domaine. Il souhaite garantir aux chercheurs russes un accès aux ressources et aux informations nécessaires au développement de l’IA.

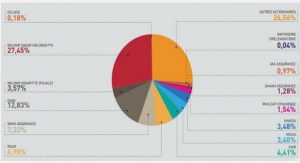

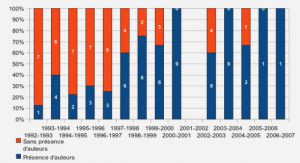

Concernant le financement, les lobbies jouent un rôle très important dans celui de la défense européenne. Entre 2012 et 2017 le budget lobbying des dix plus grosses entreprises d’armement en Europe a atteint 5,6 millions d’euros, soit le double des années précédentes (Simpere, 2018). Ces entreprises comprennent majoritairement Safran, Thales, Naval Group ou encore Airbus. Elles ont notamment obtenu des financements européens grâce au programme Horizon 2020 et un fond dédié à la sécurité intérieure.

L’impact de l’IA sur la guerre de demain

L’introduction de systèmes d’armes autonomes représente un bouleversement dans le domaine militaire. Tout d’abord, on peut penser à son impact en termes économiques.

D’après Peter Warren Singer, le coût de déploiement d’un soldat en Afghanistan, qui représente environ un million de dollars par an, est ainsi bien plus élevé que celui d’un robot. « L’introduction de robots aura un effet à la baisse sur les dépenses budgétaires liées à l’Homme ou à son activité, en volume mais également par recours accru à la simulation pour l’entraînement. Or, l’ensemble constitué par la masse salariale, l’activité opérationnelle et l’entretien programmé des matériels représente une part significative de notre budget de la défense (environ 40 %) » (Beaurenaut, 2018, p. 5).

En outre, la réutilisation de technologies développées par le secteur civil permettra également de limiter l’effort de recherche et développement à leur adaptation aux besoins de la défense. Le développement de l’IA et son intégration dans l’armée pourrait donc, à terme, représenter un véritable atout économique.

Ces propos sont cependant à nuancer avec ceux de Brice Erbland (2018) : d’après lui, si les coûts décrits précédemment peuvent être réduits avec l’introduction de robots autonomes, ceux-ci entraînent cependant inévitablement de nouvelles dépenses. En effet, les règles d’engagement, les protocoles de missions et les ordres devront être programmés exhaustivement dans la machine afin de limiter tout risque d’erreur. Or, cela ne pourra se faire qu’avec l’intervention d’officiers spécialisés, comme « un état-major de planification et de conduite opérationnelle, un LEGAD (Legal Advisor, ndlr), un tacticien dédié et un tacticien programmateur, sans même aborder les besoins en personnel de maintenance » (Erbland, 2018, p41). L’arrivée des SALA, même si ceux-ci sont bien des armes autonomes, pourrait donc tout de même s’accompagner d’une hausse du besoin en effectif, et ainsi de l’intégration dans l’armée de nouveaux types d’emplois, puisque les SALA nécessiteraient un suivi humain spécialisé.

L’arrivée des SALA signifie également un rééquilibrage des forces. Actuellement, le fondement de la puissance militaire étatsunienne comme française repose sur la supériorité technologique. Le développement de la robotique et de l’intelligence artificielle vient remettre fortement en question cette asymétrie. En effet, l’IA et les technologies numériques ne nécessitent pas, pour être implémentées, de savoir-faire spécifique, détenu seulement par un petit nombre de personnes. Les logiciels sont par nature proliférants : ils peuvent être aisément transférés et copiés, et surtout améliorés grâce aux mises à jour (Beaurenaut, 2018).

En outre, tous les éléments et pièces nécessaires pour réaliser des robots autonomes seront accessibles dans le monde civil, comme c’est déjà le cas pour fabriquer des bombes ou autres armes. Cela signifie que les SALA pourraient mettre au même niveau de puissance des États et des groupes terroristes, ont estimé des experts lors d’une table ronde sur les robots de combat lors du dernier Forum économique mondial de Davos (Rickli, 2019). La guerre changerait alors d’échelle : les acteurs traditionnels pourraient tout à fait se retrouver au même niveau de puissance que des civils ou groupuscules terroristes.

De même, la guerre changerait également de terrain : les opérations pourraient se faire en simultané, à plusieurs endroits, sur un territoire physique ou dans le cyberespace. Enfin, si les IA ne sont « que » des logiciels, cela signifie que les SALA ne constitueraient jamais des armes « finies » dont l’acquisition serait un but en soi : au contraire, on entrerait dans une course à l’armement sans fin, chacun cherchant à intégrer une nouvelle mise à jour, un nouveau module, une nouvelle option à ses SALA. L’IA changerait donc également la temporalité de la guerre.

Par ailleurs, l’IA vient bouleverser les compétences humaines traditionnelles. Au contraire des détracteurs des killer robots, certains, plutôt que de voir les robots comme un problème d’éthique ou une menace pour le respect du droit international, voient au contraire dans les SALA une avancée pour l’humanité. L’utilisation de SALA sur le terrain en temps de guerre permettrait selon eux un respect beaucoup plus strict des trois principes fondamentaux des conflits armés : l’humanité, la discrimination et la proportionnalité (Beaurenaut, 2018).

Vers un nouvel équilibre des pouvoirs influencé par la puissance militaire de l’IA

La première partie de ce mémoire s’est donc attachée à démontrer la puissance que confère à un État le développement et le déploiement d’armes utilisant l’IA, et confirme l’hypothèse selon laquelle ces nouvelles armes de pointe vont bouleverser et bouleversent déjà la notion de guerre conventionnelle. Avec de nouvelles façons de faire la guerre, l’équilibre actuel des pouvoirs, que l’on peut désigner par l’expression d’« ordre mondial », pourrait également en éprouver les conséquences. Cette seconde partie tente de répondre à la question suivante : ces nouvelles armes et ces nouvelles guerres vont-elles nous amener à un nouvel équilibre international des puissances ? Si oui, à quel nouvel ordre mondial peut-on s’attendre ?

Des stratégies de défense qui reflètent l’escalade des tensions

Dans cette partie nous allons nous pencher davantage sur les stratégies de défense des grandes puissances de l’IA militaire, c’est-à-dire les États-Unis, la Chine, l’UE et la Russie. En nous appuyant sur leur culture stratégique respective ainsi que sur leur stratégie officielle de défense (et les non-dits de ces stratégies, car ce qui est gardé secret est tout aussi révélateur), nous pourrons avoir une meilleure compréhension de l’usage de l’IA militaire par chacun de ces acteurs. En effet, comme il est détaillé dans la première partie, ces pays ne développent pas exactement le même type d’armes, et ils ne prévoient pas non plus d’en faire le même usage. Cette analyse permettra de repérer des tendances dans la stratégie de chaque acteur, afin de mieux anticiper leurs prises de position sur la scène internationale.

La culture stratégique se définit comme la « mise en évidence des facteurs culturels et immatériels qui influencent les choix stratégiques d’un pays ou d’un groupe armé » (expression de Jack L. Snyder à propos de la stratégie nucléaire soviétique, 1977), ou par « l’ensemble des pratiques traditionnelles et des habitudes de pensée qui, dans une société, gouvernent l’organisation et l’emploi de la force militaire au service d’objectifs politiques » (Colson, 1998). Il s’agit donc de repérer les « préférences stratégiques » des États, qui persistent en général même à travers des variables telles que la période historique et des événements forts, des changements politiques, ou la situation géopolitique.

|

Table des matières

Glossaire

Introduction

1. La remise en question de la notion conventionnelle de guerre à travers le développement de l’armement utilisant l’IA

1.1 Les défis apportés par des armes au niveau d’autonomie croissant

1.1.1 In the loop : une arme intelligente au service de l’Homme

1.1.2 On the loop : une prise de décision partagée

1.1.3 Out of the loop : une délégation de contrôle aux répercussions tactiques et éthiques

1.2 Des stratégies de recherche et développement révélatrices de l’enjeu militaire que représente l’IA

1.2.1 Les États-Unis et la Chine : une course à l’armement

1.2.2 La Russie et l’Europe : d’anciennes puissances désormais dépassées

1.3 La révolution de la notion de guerre

1.3.1 Les facteurs d’évolution de la guerre dans l’Histoire

1.3.2 L’impact de l’IA sur la guerre de demain

2. Vers un nouvel équilibre des pouvoirs influencé par la puissance militaire de l’IA

2.1 Des stratégies de défense qui reflètent l’escalade des tensions

2.1.1 La Chine et la Russie : deux voies parallèles

2.1.2 Les États-Unis et l’Europe : une alliance révolue

2.2 Les bouleversements apportés par l’IA : deux cas d’étude prévisionnels

2.2.1 Un bouleversement de la guerre conventionnelle : le cas de Taïwan

2.2.2 Un bouleversement fondé sur la concurrence économique : le cas de l’OBOR

2.3. Indices, tendances et scénarios possibles d’un bouleversement prochain de l’ordre mondial

2.3.1 L’hégémonie des États-Unis : les deux Écoles

2.3.2 La puissance chinoise : une réelle menace ou un piège de Thucydide ?

2.3.3 Une multipolarité partagée par les grandes puissances de l’IA militaire

Conclusion

Bibliographie

![]() Télécharger le rapport complet

Télécharger le rapport complet