Télécharger le fichier pdf d’un mémoire de fin d’études

Intervalle de référence

Intervalle entre deux limites de référence (celles-ci incluses) qui correspond à l’intervalle spécifié de la distribution des valeurs obtenues à partir de populations de sujets sains.

Il est généralement défini pour un intervalle correspondant à 95 % de la population, centré sur la médiane. Dans certains cas, une seule limite de référence peut être retenue, habituellement une limite supérieure[18,. 42]

Limites de référence

Valeur dérivée de la distribution de référence et utilisée dans un but descriptif ; (définissant un intervalle de référence) sont associées à une population de référence bien définie, généralement constituée de personnes en bonne santé. Elles constituent un des éléments contributifs à la prise de décision médicale en tenant compte des spécificités propres à la personne examinée.

Elles sont descriptives d’un état de santé donné et peuvent, parfois, dans des conditions bien définies servir de limites de décision[9,. 18]

Valeurs de référence

Valeurs mesurées sur des individus en bonne santé se trouvant dans des conditions soigneusement décrites, en particulier du point de vue des facteurs de variations potentiels risquant d’introduire un biais dans la distribution de référence et permettant une interprétation en fonction des objectifs[18,. 42]

Valeurs normales

Valeurs mesurées sur un sous- ensemble bien représentatif de la population d’individus tout venant, non triés, n’ayant pas modifié leurs conditions habituelles de vie. [18, 42]

Valeurs usuelles

Valeurs obtenues sur des populations hétérogènes c’est-à-dire des populations pour lesquelles plusieurs facteurs de variations n’ont pas été suffisamment contrôlés. Ce terme s’applique par exemple à des populations hétérogènes souvent rassemblées pour des raisons de facilité (groupe d’étudiants en médecine, donneurs de sang etc.). [18, 42]

Intérêts des valeurs de référence

Les valeurs de référence sont mises à profit dans de multiples circonstances.

Intérêts dans le diagnostic médical

L’établissement des valeurs de référence pour chaque constituant biologique permet aux cliniciens : [34]

de fixer une limite de décision adaptée à chaque cas particulier de patient, de vérifier un état de santé chez un patient, d’alerter le patient sur les risques encourus, de confirmer ou conforter un diagnostic médical, de dépister une affection cliniquement non décelable[34].

Intérêts dans le pronostic et le suivi thérapeutique

L’étude comparative des valeurs de référence des populations saines et des valeurs des populations malades permet de classer les examens suivant leur pouvoir discriminant.

Les valeurs de référence permettent également d’évaluer l’effet thérapeutique, et/ou de surveiller un risque dû à la prise de médicaments. On peut ainsi évaluer la position d’une mesure isolée par rapport aux limites de distribution d’une population saine ou sous la même thérapeutique et en tirer des conclusions quant à la suite du traitement (le poursuivre ou le modifier). [34]

Intérêts en épidémiologie

L’établissement des valeurs de référence permet de mesurer la prévalence de certaines pathologies dans une population à un échelon régional, national ou international. Pour cela il est souhaitable que l’influence des variations biologiques soit réduite au minimum.

Une autre application épidémiologique est la comparaison des valeurs observées sur des populations très différentes. On peut ainsi étudier des différences ethniques, de régime alimentaire, de régime socioculturel ou génétique.

On peut également suivre l’évolution à long terme des conditions de santé d’une population. De même les conditions de transmissibilité des valeurs de référence d’un laboratoire à l’autre, ou d’un pays à l’autre, pourront être précisées.

En somme, les intérêts multiples des valeurs de référence dans notre contexte justifient le bien fondé de notre travail.[34]

Etablissement des valeurs de référence

Pour un nouvel analyte ou une nouvelle méthode, s’il n’existe pas de données fiables de la littérature, le laboratoire utilisera le protocole de base pour déterminer l’intervalle de référence et ses limites. Si les données existent, il peut être préférable de valider les intervalles de référence publiés[41].

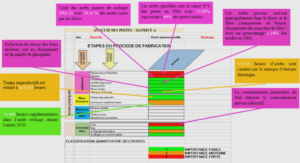

Le protocole de base comportent une série d’étapes successives parfaitement décrites dans les documents publiés par l’IFCC-LM [1, 42] et les récentes recommandations de l’IFCC-LM et du CLSI [2, 12]. En voici un résumé simplifié :

– établir la liste des facteurs de variations biologiques et analytiques (à partir des données de la littérature) ;

– déterminer les critères d’exclusion et de partition sur la base d’un questionnaire adapté ;

– rédiger un formulaire de consentement écrit et le faire signer par les individus sélectionnés ;

– classer les individus de référence potentiels sur la base des données du questionnaire ou d’autres modes d’évaluation de l’état de santé ;

– exclure les individus de l’échantillon de référence en fonction de critères prédéterminés ;

– définir le nombre adéquat d’individus de référence ;

– préparer les individus sélectionnés pour la collecte de l’échantillon en adéquation avec les procédures habituellement utilisées pour les patients au laboratoire ;

– recueillir et traiter les échantillons ;

– collecter les valeurs de référence : analyser les spécimens suivant des méthodes bien définies et décrites ;

– contrôler les valeurs de référence. Établir un histogramme pour évaluer la distribution des données ;

– analyser les valeurs de référence : sélectionner une méthode statistique puis calculer les limites de référence et l’intervalle de référence ;

– documenter l’ensemble des étapes et des procédures suivies.

Sélection des individus de référence

La définition de l’état de « bonne santé » est particulièrement complexe à établir et suppose qu’une multitude de conditions soient réunies.

Dans une première étape, les individus « malades » ou présentant des « facteurs de risques » seront exclus de l’échantillon. Dans une deuxième étape, on divisera l’échantillon de référence en sous-classes représentatives (on se limite, en pratique, le plus fréquemment au sexe et à l’âge). [11]

Technique d’échantillonnage directe

Lorsque les critères d’exclusion et de partition sont bien définis avant la sélection des individus de référence, on parle de sélectionàpriori . Ces critères sont basés sur les données de la littérature. Le processus de sélection sera mis en place avant le prélèvement sanguin.

Lorsque ces mêmes critères sont appliqués après que le prélèvement ait été fait on parle d’échantillonnage à posteriori . On préfère cette méthode pour tout nouvel analyte ou lorsque les données de la littérature sont peu riches en informations pour déterminer les critères de sélection[41].

Elle est réalisée sur une population importante tout venant (généralement > 1000).

Elle consiste d’abord à préparer les sujets pour le prélèvement, ensuite à leur soumettre un questionnaire, Après quoi, on effectue le prélèvement qui est traité pour ensuite être analysé. Avec les résultats obtenus, on sélectionne un échantillon de référence à partir des critères de partition et d’exclusion, Enfin, on établit des valeurs de référence[11,. 41]

Contrairement à la sélection a posteriori, la sélection a priori s’effectue par mesure directe des constituants biologiques sur un échantillon limité de la population (généralement entre 50 et 150 individus de référence)

On sélectionne d’emblée notre échantillon de référence sur la base de critères de partition et d’exclusion.

Une fois les sujets choisis, on les prépare au prélèvement avant de l’effectuer.

Ensuite, les spécimens recueillis sont traités et analysés. Les résultats obtenus sont soumis au traitement statistique en vue de l’établissement des valeurs de référence[11,. 41]

Dans les deux cas de sélection, il est nécessaire de suivre un protocole bien défini qui comporte plusieurs étapes:

. la sélection des individus de référence

. la préparation des individus pour le prélèvement le traitement des spécimens biologiques

. l’analyse biochimique par des méthodes fiables le traitement statistique des résultats obtenus.

Technique d’échantillonnage indirecte

Les informations contenues dans une base de données d’un laboratoire ou d’un hôpital sont utilisées. Cette technique peut être employée principalement s’il est trop difficile de recueillir des échantillons de personnes en bonne santé. Ce procédé est relativement simple et peu coûteux. L’extraction des données est réalisée par des méthodes statistiques sophistiquées, nécessitant le concours de statisticiens chevronnés.

En revanche, des précautions particulières seront prises pour éviter d’inclure des valeurs d’individus « malades » ou « à risques ». Ainsi, en pratique on fera le nécessaire pour utiliser les données provenant d’individus en bonne santé (donneurs de sang, examens périodiques de santé, individus porteurs de pathologies bénignes sans retentissement métabolique…). [11, 41]

Le comité IFCC/CLSI est très réservé quant à l’usage de cette technique qui peut conduire à une « estimation grossière » des intervalles de référence.

Facteurs pré-analytiques

L’objectif est de contrôler et de maîtriser les facteurs pré-analytiques significatifs pour en minimiser l’effet. Il concerne la préparation du sujet avant le prélèvement, la collecte et le traitement de l’échantillon (manipulation et conservation). [43]

Les critères d’exclusion visent à sélectionner des groupes d’individus en bonne santé en éliminant les individus malades ou à risques.

Les facteurs de partition visent à classer les individus de référence en différentes sous-classes. Les deux plus courants sont l’âge et le sexe.

Dans certains cas, un critère d’exclusion peut être considéré comme un facteur de partition.

Des listes exhaustives des différents facteurs de variabilité (pré-analytiques, exclusion et partition) sont publiées dans les documents de référence de l’IFCC-LM et du CLSI. [2, 12]

Facteurs analytiques

Les intervalles de référence sont liés à la méthode de mesure employée. Il convient de la décrire soigneusement et de bien maîtriser les facteurs de variation au cours du temps.

La traçabilité par rapport à un système de référence concerne à ce jour très peu d’examens de laboratoire : quand elle existe, elle sera décrite.

Les paramètres à prendre en compte sont bien décrits par Klein et Junge.[26]

Traitements statistiques et analyses des données

Trois méthodes statistiques différentes ont été décrites dans les documents officiels de l’IFCC-LM et du CLSI [2, 12] ; bien d’autres méthodes ont été publiées et de nouveaux travaux sont publiés chaque année.

Les méthodes présentées ci-dessous ont fait leurs preuves et font l’objet à ce jour d’un consensus international.

Méthode paramétrique

Elle est applicable à des populations dont la distribution est normale (« gaussienne »). En cas de doute sur la nature de la distribution, les tests de normalité permettent de trancher : s’ils sont négatifs, on appliquera l’une ou l’autre transformation statistique afin de la normaliser. Ensuite on vérifiera que la nouvelle distribution suit bien une loi normale.

Cette méthode est peu utilisée en biologie, les distributions observées étant le plus souvent asymétriques.[41]

Méthode non paramétrique

Celle-ci n’exige rien des lois de probabilités, elle est toujours applicable. Elle requiert cependant une sélection soigneuse des individus de référence et un nombre d’individus suffisant ( ≥ 120).

C’est la méthode que recommande actuellement l’IFCC-LM. [2, 41]

Méthode robuste

A été introduite récemment dans le dernier document de l’IFCC/CLSI. Elle peut rendre des services lorsque le nombre de sujets est limité. Elle ne requiert pas que la distribution soit gaussienne.

Sur le plan statistique c’est une méthode proche de la méthode paramétrique, sauf qu’elle mesure la position et la dispersion au lieu de la moyenne et de l’écart-type. [2]

Il existe d’autres méthodes statistiques décrites dans la littérature (méthodes paramétriques traditionnelles, technique de boot-strap, etc.), mais elles nécessitent le concours de statisticiens expérimentés.

Sur le plan pratique, les deux premières techniques, paramétriques et non paramétriques, sont parfaitement décrites dans les documents originaux de l’IFCC-LM (5), la technique robuste est décrite dans un ouvrage publié en 2005 par Horn et Pesce.

Nombre minimum de valeurs de référence

Les méthodes statistiques classiques imposent un nombre minimal d’au moins 120 valeurs par classe ou sous-classe. En effet, le nombre de valeurs conditionne directement la précision du calcul des limites de référence. En cas de difficulté pour atteindre ce nombre (par ex. : examens coûteux, pédiatrie, prélèvement difficile) il est recommandé d’utiliser exclusivement les méthodes non paramétriques (ou la méthode robuste comme alternative).

Le calcul de l’intervalle de confiance de chaque limite permet de valider le nombre d’individus retenus. Il est généralement admis que l’intervalle de confiance pour chaque limite de référence doit être inférieur à 0,2 fois la largeur de l’intervalle de référence concerné[2].

Mise en évidence et élimination des valeurs aberrantes

Il convient de bien se rappeler que l’estimation des limites de référence suppose que l’ensemble des valeurs de référence mesurées représente un ensemble homogène.

Deux cas de figure peuvent se présenter : ou bien ces valeurs se trouvent à l’intérieur de la distribution (par ex. : erreur analytique) donc, quasiment indétectables, ou bien elles sont situées à l’extérieur et sont de ce fait facilement repérables.

La première étape est une inspection visuelle de la distribution : elle permet de mesurer l’importance du phénomène.

Dans un second temps on emploiera une méthode statistique. Plusieurs sont couramment utilisées. La plus populaire est la méthode de Dixon: la plus petite (ou la plus grande) valeur observée peut être considérée comme aberrante si la différence (D) entre les deux plus petites (ou les plus grandes) est égale ou supérieure au tiers de l’étendue de l’ensemble des valeurs (R), dans ce cas la valeur extrême doit être éliminée. Ensuite on recommencera avec les deux valeurs extrêmes jusqu’à ce que le critère d’acceptation soit satisfait.[15]

Une autre méthode a été proposée par Tukey: elle suppose que la distribution soit gaussienne. Comme en biologie clinique la plupart ne le sont pas, cela conduit à procéder la plupart du temps à une transformation préalable. On prendra en considération seulement les valeurs de l’intervalle regroupant 50 % des valeurs centrales de l’intervalle de référence. Pour ce faire on calculera les centiles 25 et 75 %, dénommés Q1 et Q3, on calculera l’intervalle Q3-Q1, appelé intervalle interquantile (IIQ). Les nouvelles bornes sont calculées comme suit : la borne basse sera égale à Q1-1,5×IIQ et la borne haute à Q3+1,5×IIQ.

Tous les points inférieurs à la borne basse ou supérieurs à la borne haute seront considérés comme des valeurs aberrantes[46].

Pour conclure ce point, si la sélection des individus de référence est faite correctement et si le processus analytique est bien contrôlé, il ne doit pas y avoir de valeurs aberrantes. Si leur nombre est trop élevé, la révision des critères d’exclusion et de partition s’impose. [2]

Partition des valeurs de référence

Celle-ci n’est justifiée que si cela présente un intérêt sur le plan clinique ou pour des raisons physiopathologiques. Cette condition sera établie préalablement au traitement statistique. La règle généralement admise est que, si la moyenne entre deux sous-classes est statistiquement significative, une partition s’impose.

Deux approches sont proposées par l’IFCC : l’une est la méthode de Harris et Boyd [22] largement utilisée, mais qui suppose que la distribution soit gaussienne ainsi qu’une égale prévalence de chaque sous-classe ; l’autre, la méthode de Lahti.[27]

Cependant, aucune de ces méthodes n’est idéale, notamment pour répondre à la question de la partition impliquant plusieurs sous-classes.

Intervalle de confiance

Les limites de référence calculées par l’un ou l’autre des procédés proposés précédemment ne sont qu’une estimation des centiles de la population étudiée. Calculer les intervalles de confiance permettra à l’utilisateur de garder à l’esprit que cette variabilité est bien une réalité et donner ainsi une estimation objective de celle-ci.

En conséquence, si l’intervalle de confiance paraît trop large, il est toujours possible à l’utilisateur d’élargir la taille de l’échantillon de référence pour atteindre une meilleure précision de l’intervalle de référence[2,. 9]

GENERALITES SUR LES TRANSAMINASES

La mesure de l’activité des transaminases est un marqueur spécifique de la cytolyse cellulaire et fait partie des tests de routine les plus utilisés.

Classification des transaminases

La classe des transaminases ou amino-transférases (Amino acide amino transférases) assure le transfert de groupement aminé d’une molécule à une autre.

Deux transaminases existent uniquement chez l’Homme:

– L’alanine amino transférases anciennement dénommée Sérum Glutamo-Pyruvique Transférase (SGPT) ; on lui attribue le N° EC 2.6.1.2 selon la Classification enzymatique.

– L’aspartate aminotransférase : anciennement dénommée Sérum Glutamo-Oxaloacétate Transférase (SGOT), N° EC 2.6.1.1 suivant la même classification. [17, 33, 47]

Exploration biochimique

Conditions pré-analytiques

Chez un patient à jeun, en position allongée, on effectue un prélèvement veineux sur un tube sec habituellement, un tube hépariné ou avec EDTA, ensuite on centrifuge immédiatement à 2500 tr/minute pendant 10 minutes.

Les échantillons doivent être traités dans les 60 minutes suivant le prélèvement, sinon une conservation du plasma ou du sérum est possible pendant 24heures entre 2°c et 8°c. [10]

Il faut noter que la congélation dissocie l’apoenzyme du phosphate de pyridoxal qui joue le rôle de cofacteur dans le métabolisme des transaminases ce qui influence directement sur leurs métabolisme.

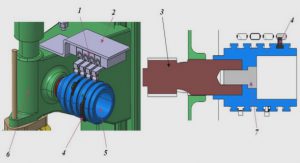

Méthodes de mesure de l’activité enzymatique des transaminases

Il existe des méthodes colorimétriques anciennement élaborées qui sont actuellement abandonnées du fait de leur manque de spécificité et de sensibilité ; une méthode enzymatique bien qu’elle soit spécifique mais de réalisation délicate [38,46]; enfin les méthodes cinétiques enzymatiques qui sont actuellement les méthodes de référence recommandées par l’IFCC .

a) Mesure de la cinétique de l’activité des ALAT par la méthode enzymatique de Wrobleski et Ladue

C’est la technique la plus utilisée

Une procédure modifiée a été recommandée par la FICC[3]:

L’ALAT catalyse le transfert d’un groupement amino de L-alanine en α-cétoglutarate afin de former du L-glutamate et du pyruvate.

Le lactate déshydrogénase (LDH) catalyse la conversion du pyruvate en lactate. En même temps, la NADH est oxydée en NAD, tel qu’illustré dans la réaction suivant :

ALAT L-alanine + α-cétoglutarate L-glutamate + pyruvate Pyruvate + NADH, H+ LDH Lactate + NAD+.

La variation de la différence d’absorbance à 340 nm induite par la conversion du NADH en NAD+ est directement proportionnelle à l’activité de l’ALAT. [29].

b) Mesure de la cinétique de l’activité des ASAT par la méthode enzymatique de Karmen/Bergmeyer

C’est la méthode recommandée par l’IFCC :[4]

Basée sur le couplage du malate déshydrogénase (MDH) et de nicotinamide dinucléotide réduite (NADH) dans la détection d’ASAT dans le sérum.

Le lactate déshydrogénases (LDH) est ajouté à la réaction pour réduire les interférences causées par le pyruvate endogène.

L’ASAT catalyse la réaction de L-aspartate et α-cétoglutarate en oxaloacétate et L-glutamate. L’oxaloacétate est converti en malate et la NADH est oxydée en NAD+ par le catalyste MDH : [43]

L-aspartate + α-cétoglutarate Oxaloacétate + NADH ASAT

Oxaloacétate + L-glutamate MDH Malate + NAD+

La variation d’absorbance à 340 nm induite par la conversion du NADH en NAD+ est directement proportionnelle à l’activité d’ASAT présente dans l’échantillon. [19, 36]

Variations pré-analytiques et analytiques

La température et le pH du milieu réactionnel au cours du dosage enzymatique influencent considérablement sur les résultats obtenus car ils augmentent la vitesse réactionnelle et en même temps accentuent l’énergie cinétique des molécules qui réagissent[17,. 33, 36]

La position assise ou debout peut également interférer

Un prélèvement hémolytique peut fausser les résultats pour trois raisons[10].

– les enzymes des érythrocytes se mélangent à celles du plasma

– certains composants des érythrocytes interviennent dans les réactions enzymatiques

– l’hémoglobine fausse les mesures spectrophotométriques

Aussi une hyperbilirubunémie et une hyperlipoprotéinémie modifient les mesures spectrophotométriques également[10].

Enfin, en ce qui concerne l’ASAT, son activité augmente en cas de conservation quelque soit son mode et un traitement immédiat est suggéré[10].

Variations physiologiques

Pour ces deux enzymes, on note une variation physiologique des taux en fonction du sexe avec qui est majorée chez les hommes jusqu’à l’âge de 65 ans où les valeurs se rapprochent chez les deux sexes.

Une élévation des ASAT après de courtes périodes d’excès alimentaires ; un régime riche en saccharose est associé à une élévation modérée transitoire des transaminases. [28, 29]

La surcharge pondérale augmente de 60% l’ALAT des hommes obèses par rapport aux hommes non obèses de la même tranche d’âge. L’effet est beaucoup moindre chez les femmes (10%). [35, 39, 40]

Sur le plan génétique, il a été noté que les populations d’origine espagnole présentent des valeurs plus élevées que chez les races d’origine non espagnole et les noirs. [28, 29, 40]

Le rythme circadien varie les activités de 16% pour l’ALAT et de 18% pour l’ASAT. [38]

On note également que l’exercice physique augmente l’activité des transaminases de 2% chez l’homme surtout ceux de l’ASAT. [39]

Certains médicaments comme les contraceptifs oraux, les antiépileptiques, les hypolipémiants et les hépatotoxiques augmentent les transaminases alors que l’alcool diminue leur activité in vivo par baisse de l’absorption de la coenzyme (vitamine B6). [31]

Par contre, la grossesse et le déficit en vitamine B6 font baisser les taux de l’activité sérique des transaminases.[39]

Variations physiopathologiques

Toute augmentation de la concentration de l’activité des transaminases témoigne d’une destruction cellulaire accrue ou d’une augmentation de la perméabilité membranaire.

De plus, le dosage des ALAT couplé à celui des ASAT permet de juger la gravité de la lésion.

Il faut noter que l’augmentation des transaminases ne donne aucune indication sur l’état fonctionnel du foie mais signe seulement la souffrance cellulaire. [25]

L’élévation des transaminases est nette dans plusieurs affections particulièrement cardiaques et hépatiques (jusqu’à 100 fois la valeur normale dans les hépatites aiguës). On observe une augmentation des transaminases dans les affections suivantes:

En pathologie hépatique

ASAT (GOT) et ALAT (GPT) sont des indicateurs de la cytolyse hépatique.

L’augmentation est variable selon le type de pathologie:

– Dans l’hépatite virale aiguë, les valeurs maximales atteintes s’échelonnent de 30 à 100 fois la limite supérieure des valeurs de référence; l’ALAT augmente plus fortement que l’ASAT. [16, 25]

– Dans l’hépatite toxique les valeurs des transaminases peuvent être comparables à celles obtenues lors de l’hépatite virale aiguë.

– Dans l’hépatite alcoolique, l’élévation est plus modérée et le rapport ASAT/ALAT augmenté.[16, 25]

– L’augmentation est modérée lors d’ictères obstructifs.

– En cas de cirrhose, l’augmentation ne dépasse généralement pas 4 à 5 fois la limite supérieure des valeurs de référence.

– Le cancer primaire ou secondaire du foie provoque une majoration souvent modérée des transaminases; l’augmentation porte alors davantage sur l’ASAT (GOT). [16, 25]

– (ASAT/ALAT<1 excepté la cirrhose où ASAT/ALAT>1)

En pathologie cardiaque

L’augmentation de l’ASAT (GOT) dans l’infarctus du myocarde survient habituellement 6 à 8 heures après le début des signes cliniques pour atteindre une valeur maximale après 24 à 36 heures.

Le retour à la normale se fait en général dans les 5 jours. L’ALAT (GPT) n’est que peu ou pas augmentée.[25, 50]

En pathologie musculaire

Certaines myopathies et principalement la dystrophie musculaire progressive type Duchenne provoquent une élévation de l’ ASAT (GOT)[25].

Sensibilité et spécificité des transaminases

Ce sont en effet les marqueurs biologiques les plus spécifiques d’une cytolyse hépatique et de la nécrose hépatocytaire[48,. 49]

La spécificité est plus marquée pour les ALAT, conséquence de leur distribution essentiellement hépatique dans l’organisme.

Il est établi que la spécificité hépatique augmente avec des taux plus élevés des transaminases. Lorsque les transaminases sont utilisées en association avec les autres tests disponibles du bilan hépatique (GGT, PAL), la sensibilité et la spécificité augmentent pour la détection d’une pathologie hépatique.[32]

Cependant, le degré d’élévation des transaminases n’est pas corrélé avec l’importance de la nécrose hépatocytaire trouvée lors d’une biopsie hépatique. Il n’y a qu’une faible corrélation entre le degré d’augmentation et la gravité des lésions histologiques.

Une diminution rapide de leur taux lors d’une hépatite aiguë peut être en rapport avec une diminution du nombre d’hépatocytes viables, et s’avérer de très mauvais pronostic. [32]

|

Table des matières

PREMIERE PARTIE : RAPPELS BIBLIOGRAPHIQUES

I. CONCEPT DE VALEURS DE REFERENCE

1. Définitions

1.1. Valeur observée

1.2. Individu de référence

1.3. Echantillon de référence

1.4. Population de référence

1.5. Intervalle de référence

1.6. Limites de référence

1.7. Valeurs de référence

1.8. Valeurs normales

1.9. Valeurs usuelles

2. Intérêts des valeurs de référence

2.1. Intérêts dans le diagnostic médical

2.2. Intérêts dans le pronostic et le suivi thérapeutique

2.3. Intérêts en épidémiologie

3. Etablissement des valeurs de référence

3.1. Sélection des individus de référence

a) Technique d’échantillonnage directe

b) Technique d’échantillonnage indirecte

3.2. Facteurs pré-analytiques

3.3. Facteurs analytiques

3.4. Traitements statistiques et analyses des données

a) Méthode paramétrique

b) Méthode non paramétrique

c) Méthode robuste

3.5. Nombre minimum de valeurs de référence

3.6. Mise en évidence et élimination des valeurs aberrantes

3.7. Partition des valeurs de référence

3.8. Intervalle de confiance

II. GENERALITES SUR LES TRANSAMINASES

1. Classification enzymatique des transaminases

2. Répartition dans l’organisme

3. Mécanismes et rôles métaboliques

4. Exploration biochimique

4.1. Conditions pré-analytiques

4.2. Méthodes de mesure de l’activité enzymatique des transaminases

a) Mesure de la cinétique de l’activité des ALAT par la méthode enzymatique de Wrobleski et Ladue

b) Mesure de la cinétique de l’activité des ASAT par la méthode enzymatique de Karmen/Bergmeyer

c) Standardisation

5. Valeurs usuelles

6. Variations des taux des transaminases

6.1. Variations pré-analytiques et analytiques

6.2. Variations physiologiques

6.3. Variations physiopathologiques

a) En pathologie hépatique

b) En pathologie cardiaque

c) En pathologie musculaire

7. Sensibilité et spécificité des transaminases

DEUXIEME PARTIE : TRAVAIL PERSONNEL

I. MATERIELS ET METHODE D’ETUDE

1. Cadre et type d’étude

2. Population d’étude

3. Critères d’inclusion

4. Recueil et traitements des échantillons

5. Traitement statistique des données

a. Mise en évidence des valeurs aberrantes

b. Analyse des données

II. RESULTATS

1. Population d’étude

2. Répartition de la population en fonction du sexe

3. Répartition de la population en fonction de l’âge

4. Répartition de la population en fonction du sexe et de l’âge

5. Valeurs usuelles de l’ASAT et l’ALAT dans la population d’étude

6. Valeurs usuelles de l’ASAT et de l’ALAT en fonction du sexe

7. Valeurs usuelles de l’ASAT et de l’ALAT en fonction de l’âge

8. Valeurs usuelles de l’ASAT et de l’ALAT en fonction du sexe et de l’âge

9. Résumé sur les valeurs des transaminases obtenues dans notre population

III. DISCUSSION

CONCLUSION

REFERENCES

Télécharger le rapport complet