Contexte général et enjeux de la thèse

Dans un contexte de sécurité élevé, l’Organisation de l’Aviation Civile Internationale (OACI 1) a récemment défini un ensemble de recommandations visant à réduire davantage le nombre d’accidents en vol. Chaque État doit désormais exiger des exploitants aériens et des organismes de maintenance qu’ils mettent en place des Systèmes de Gestion de la Sécurité (SGS) afin d’évaluer précisément les risques opérationnels. Ainsi, les compagnies aériennes sont depuis 2006 dans l’obligation de passer progressivement d’un modèle basé uniquement sur le respect des normes (la conformité) à un modèle de gestion des risques tel que l’a défini l’OACI.

1. Un glossaire des termes aéronautiques est donné en Annexe A.1. Un SGS se décline en trois modes. Le mode réactif consiste à mener des enquêtes à la suite d’incidents survenus durant le vol afin d’en connaître les causes, puis à mettre en place des actions correctives. Le mode proactif se définit comme la connaissance des dangers et des défenses associées afin d’anticiper des situations à risque. Enfin, la démarche prédictive, complémentaire au réactif et au proactif, vise à développer une mesure objective des risques et de leurs origines pour être en permanence conscient du niveau de sécurité de la compagnie. Pour illustrer cette démarche de la gestion des risques, considérons un aérodrome présentant des caractéristiques particulières (présence de montagnes à proximité, pistes courtes, …). Le mode proactif d’un SGS doit alors identifier les dangers liés à ces caractéristiques pour permettre aux compagnies de former les pilotes et de mettre en place des procédures adaptées. Si un incident survient sur cet aérodrome, le mode réactif doit en identifier les causes pour éviter qu’il ne se reproduise dans le futur. Le volet prédictif se résume à mesurer le niveau de risque en tenant compte des caractéristiques de l’aérodrome et à suivre son évolution dans le temps, et ce afin d’identifier des causes d’incidents potentiels. Si les volets réactifs et proactifs sont bien intégrés par les compagnies aériennes, le mode prédictif n’est à ce jour pas mis en œuvre. Le rapport IATA 2013 sur la sécurité 2 souligne, en eet, que l’analyse prédictive est la prochaine étape pour compléter le SGS (Figure 1.1). Pour atteindre cet objectif, il est nécessaire d’exploiter les données des enregistreurs de vol, les boîtes noires. Elles sont recueillies par les compagnies après chaque vol et sont à ce jour uniquement exploitées pour s’assurer du respect de la conformité. Pour cela, les gestionnaires de la sécurité des compagnies aériennes utilisent l’analyse des vols (en anglais Flight Data Monitoring, FDM), outil permettant de détecter des événements survenus au cours des vols. Plus précisément, ces événements sont définis par des dépassements de seuils fixés par la compagnie sur certains paramètres préalablement choisis. Par exemple, l’événement “Speed High during Approach at 500 ft” s’intéresse à une vitesse excessive à l’altitude de 500 pieds lorsque l’avion est en phase d’approche (soit une minute environ avant l’atterrissage). L’information à laquelle donne accès l’analyse des vols est fortement réduite car elle correspond uniquement aux dépassements de seuils. De deux choses l’une : soit un événement est détecté, et dans ce cas, le vol est analysé, soit aucun dépassement de seuil n’est détecté et les données ne sont pas conservées. De plus, les analyses sont eectuées vol par l’échelle de la flotte. L’accident du vol Air France AF447 survenu en 2009 entre Rio et Paris illustre bien les limites de cette démarche. Le Bureau d’Enquêtes et d’Analyses (BEA) a montré que la catastrophe a en partie été causée par le givrage des sondes Pitot, instruments mesurant la pression totale de l’air pour, notamment, calculer la vitesse de l’avion. Or, plusieurs cas de givrage des sondes Pitot avaient été relevés avant l’accident mais le risque n’avait pas été correctement évalué. Le respect de la conformité n’est donc pas une démarche susante dans un objectif de gestion des risques dans le mesure où cette approche ne permet pas d’identifier les risques et de les anticiper. Le niveau de sécurité atteint aujourd’hui par le transport aérien est avant tout le fruit du respect de normes très strictes. Ces normes définissent un ensemble de marges de sécurité qui permettent d’évoluer dans une “zone” sure d’exploitation. La sécurité se définit alors comme le respect des marges de sécurité. Il faut donc savoir comment les marges sont utilisées afin de s’assurer du niveau de sécurité et de le maintenir. Plus les marges sont réduites, plus le risque est important. Par exemple, lors de l’atterrissage, il est demandé aux compagnies de vérifier que les performances de l’avion permettent l’arrêt sur moins de 60 % de la piste. Les 40 % restants définissent une marge de sécurité pour éviter les sorties de piste. Plus on s’éloigne du seuil de 60 % de la longueur de piste, plus le risque de sortie de piste est élevé. L’enjeu de cette thèse est de faire évoluer l’analyse des données des enregistreurs de vol par l’introduction de méthodes statistiques. Des situations à risque doivent être identifiées en mesurant l’utilisation de marges de sécurité. L’analyse prédictive des risques aériens revient à anticiper des scénarios critiques par la mise en place d’actions correctives (formations, nouvelles procédures, …). Dans cet objectif, il est crucial d’analyser tous les vols mis à disposition. De nouveaux facteurs de risque peuvent alors être identifiés. Ils permettent d’apporter une meilleure compréhension des risques et donc une meilleure vision du niveau de sécurité de la compagnie. Cette approche se diérencie des solutions utilisées actuellement par les exploitants aériens car elle utilise l’ensemble de l’information contenue dans les enregistreurs de vol là où l’analyse des vols FDM se contente d’examiner les vols un par un. Le but final de Safety Line est de proposer, en collaboration avec les experts aéronautiques, des solutions automatiques de traitements statistiques des données à grande échelle, en complément de l’analyse des vols.

Vitesses et accélérations

Plusieurs types de vitesses sont considérées en aéronautique. On distingue la vitesse air (air speed) – vitesse de l’avion par rapport à la masse d’air – et la vitesse sol (ground speed, GSC) qui correspond à la vitesse de déplacement par rapport au référentiel terrestre. La différence entre la vitesse air et la vitesse sol est la composante de vent sur la trajectoire de l’avion (voir la Figure 1.3). La vitesse et l’orientation du vent sont cruciales en pilotage car elles peuvent altérer la stabilisation de l’avion notamment en phase d’approche. La densité de l’air variant en fonction de l’altitude et de la température, différentes vitesses air sont employées. La vitesse indiquée (IAS) est donnée par la différence entre la pression totale – captée par les tubes Pitots – et la pression atmosphérique ambiante (dite pression statique). La vitesse conventionnelle (Calibrated Air Speed, CASC) correspond à la vitesse corrigée des erreurs d’instruments. En règle générale, les pilotes se réfèrent à la vitesse corrigée jusqu’à une altitude de transition où l’on contrôle la vitesse en nombre de Mach, rapport entre la vitesse vraie et la vitesse du son. La vitesse d’approche (VAPP) est une vitesse de référence que le pilote doit respecter au moment de la phase d’approche soit quelques minutes avant l’atterrissage pour conserver une marge suffisante par rapport au décrochage. Elle est calculée en fonction notamment de la masse de l’avion. Les vitesses sont exprimées en nœuds c’est-à-dire 0.514 m.s≠1. Enfin, la vitesse verticale (IVV) désigne le taux de chute et est exprimée en pieds par minute. Les accélérations longitudinale (LONGG), latérale (LATG) et verticale (VRTG) définissent les accélérations sur les diérents axes. Elles sont mesurées jusqu’à une fréquence de 8 Hz et l’unité de mesure est le g soit 9.81 m.s≠2.

Jeux de données utilisés

Les données étudiées pendant la thèse proviennent de deux compagnies et de deux types d’avion très diérents. Nous analysons en eet des moyen-courriers d’une part et des longcourriers d’autre part. Les diérences sont notamment les suivantes :

• Les avions moyen-courriers ont une masse plus faible que les long courriers et sont plus maniables. À l’atterrissage, la masse est déterminante car elle influe sur la décélération de l’avion.

• La façon de piloter et les procédures de vol ne sont pas les mêmes.

• Le rapport poids/puissance est diérent.

Quatre jeux de données sont extraits des enregistreurs de vol. Ils correspondent chacun à une compagnie et à un type d’avion (informations non précisées ici). Tous les paramètres de vol ne sont pas pris en compte. En eet, l’expertise métier est en mesure d’identifier ceux qui sont les moins informatifs pour le risque considéré. Les paramètres relatifs au décollage sont donc ici automatiquement supprimés. Nous décrivons dans les paragraphes qui suivent les diérents jeux de données exploités pendant la thèse. Les trois premières bases de données sont relatives au risque d’atterrissage long et la quatrième correspond à l’étude de l’atterrissage dur.

Algorithme filter

Un algorithme filter consiste à classer les variables selon un critère d’importance et à sélectionner les q variables qui maximisent ce critère. Cette approche vise à pré-traiter les variables en éliminant celles qui portent le moins d’information. On parle de sreening dans ce cas. Les critères usuels sont le coecient de corrélation entre Xj et Y , l’information mutuelle qui mesure la distance entre les distributions de probabilité entre Xj et Y et le test de Student (voir Lazar et al.; 2012). Le principal inconvénient de cette approche vient du fait que le choix final des variables se fait indépendamment des performances de l’algorithme de classification ou de régression.

Algorithme wrapper

Un algorithme de type wrapper, formalisé par Kohavi and John (1997) et Blum and Langley (1997), utilise la procédure d’apprentissage pour trouver un sous-ensemble optimal de variables au sens de l’erreur de prédiction. Une procédure ecace serait d’évaluer les performances de tous les sous-ensembles possibles, ce qui est évidemment impossible dès lors que la dimension du problème croît. C’est pourquoi, un algorithme wrapper emploie une stratégie pas-à-pas où les variables sont itérativement ajoutées (procédure ascendante ou forward) ou bien retirées (procédure descendante ou backward). Ces algorithmes sont un moyen d’approcher les performances d’une sélection exhaustive en guidant la recherche du meilleur sous-ensemble. En eet, pour déterminer les variables à ajouter ou à retirer, il est nécessaire de se munir d’un critère mesurant l’information portée par chacune des variables. Par exemple, Kohavi and John (1997) utilisent l’erreur de prédiction mais il est possible d’employer les mesures de rang décrites plus haut. Les critères d’information (AIC, BIC, Cp de Mallows, etc.) sont également utilisés dans le cas du modèle de régression linéaire (pour plus de détails, consulter Hastie et al.; 2001, Chap. 3). L’algorithme wrapper le plus connu est l’algorithme SVM Recursive Feature Elimination (ou SVM-RFE) introduit par Guyon et al. (2002). Nous développons plus en détail cet algorithme dans la section 2.4. Une adaptation aux forêts aléatoires est également proposée dans les chapitres 4 et 5. Ambroise and McLachlan (2002) ont identifié un biais de sélection dans le cas de l’algorithme SVM-RFE. Guyon et al. (2002) estiment l’erreur de prédiction par validation croisée Leave-One-Out à chaque étape de l’algorithme. Ambroise and McLachlan (2002) notent que procéder à une validation croisée de façon interne à l’algorithme SVM-RFE entraine une sous-estimation de l’erreur. Au même titre que le sur-apprentissage, la sélection et le test de chaque sous-ensemble doit s’eectuer sur des échantillons distincts. Ambroise and McLachlan (2002) suggèrent de procéder à la validation croisée de façon externe à l’algorithme. Cette approche est retenue notamment par Svetnik et al. (2004) et Duan et al. (2005).

|

Table des matières

1 Introduction

1.1 Contexte général et enjeux de la thèse

1.2 Données de vol

1.3 Atterrissage long et atterrissage dur

1.4 Contexte statistique

1.5 Organisation du manuscrit et contributions

1.5.1 Chapitre 2 : Analyse du risque d’atterrissage long

1.5.2 Chapitre 3 : Apprentissage de données fonctionnelles

1.5.3 Chapitre 4 : Corrélation et importance des variables dans les forêts aléatoires

1.5.4 Chapitre 5 : Mesure d’importance groupée et application à l’apprentissage de données fonctionnelles multivariées

1.5.5 Chapitre 6 : Comparaison de méthodes fonctionnelles appliquées aux données de vol

1.5.6 Chapitre 7 : Valorisation industrielle – Produit FlightScanner

2 Analyse des données de vol à 500 pieds pour le risque d’atterrissage long

2.1 Apprentissage statistique supervisé

2.2 Sélection de variables

2.3 Régression logistique

2.4 Machines à vecteurs de support

2.4.1 Principe général

2.4.2 Sélection de variables

2.5 Forêts aléatoires

2.5.1 Arbre de décision

2.5.2 Forêts aléatoires de Breiman

2.5.3 Importance des variables et algorithmes de sélection

2.6 Mesure d’importance par permutation et indices de sensibilité

2.6.1 Éléments d’analyse de sensibilité

2.6.2 Comparaison des indices de Sobol avec la mesure d’importance par permutation

2.7 Application au risque d’atterrissage long

2.8 Conclusion du chapitre

3 Apprentissage de données fonctionnelles

3.1 Introduction

3.2 Représentation fonctionnelle des données

3.3 Méthodes de réduction de dimension avec les ondelettes

3.3.1 Bases d’ondelettes

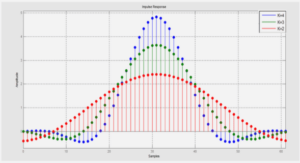

3.3.2 Débruitage par ondelettes

3.3.3 Seuillage consistant de n processus indépendants

3.3.4 Illustration numérique et commentaires

3.4 Réduction de dimension par analyse en composantes principales fonctionnelle

3.5 Méthodes d’apprentissage supervisé pour données fonctionnelles

4 Corrélation et importance des variables dans les forêts aléatoires

4.1 Introduction

4.2 Random forests and variable importance measures

4.3 Permutation importance measure of correlated variables

4.4 Wrapper algorithms for variable selection based on importance measures

4.5 Numerical experiments

4.5.1 Correlation eect on the empirical permutation importance measure

4.5.2 Variable selection for classification and regression problems

4.6 Application to flight data analysis

4.7 Conclusion

4.8 Proofs

5 Mesure d’importance groupée dans les forêts aléatoires et application à l’analyse de données fonctionnelles multivariées

5.1 Introduction

5.2 Grouped variable importance measure

5.2.1 Importance measure of a group of variables

5.2.2 Decomposition of the grouped variable importance

5.2.3 Grouped variable importances and Random Forests

5.3 Multivariate functional data analysis using the grouped variable importance

5.3.1 Functional representation using wavelets

5.3.2 Grouped variable importance for functional variables

5.3.3 Numerical experiments

5.4 A case study: variable selection for aviation safety

5.5 Additional experiments about the Grouped Variable Importance

5.6 Curve dimension reduction with wavelets

5.6.1 Signal denoising via wavelet shrinkage

5.6.2 Consistent wavelet thresholding for independent random signals

6 Comparaison de méthodes fonctionnelles appliquées aux données de vol

6.1 Comparaison des Chapitres 2, 4 et 5

6.2 Comparaison des forêts aléatoires avec le Group Lasso

6.3 Conclusion du chapitre

7 Valorisation industrielle – Produit FlightScanner

7.1 Introduction

7.2 Processus de traitement des données de vol implémenté dans FlightScanner

7.3 Interface utilisateur

7.4 Étude de l’atterrissage dur

7.4.1 Description du risque d’atterrissage dur

7.4.2 Données

7.4.3 Identification des facteurs de risque pour l’atterrissage dur

7.4.4 Prédiction et comparaison aux profils-types

8 Conclusion

8.1 Résumé des travaux

8.2 Perspectives

A Glossaire

A.1 Glossaire des termes aéronautiques

A.2 Glossaire des unités de mesure

A.3 Glossaire des paramètres de vol

Références bibliographiques

![]() Télécharger le rapport complet

Télécharger le rapport complet