Extrapolation de Richardson

Introduction

Les fonctions numériques sont des procèdes qui, à un nombre, associent un nombre unique ; l’utilité des fonctions est indispensable dans tous les domaines, ainsi elles servent à déterminer les relations entre différents facteurs, en d’autre termes elles permettent de représenter l’évolution d’une grandeur dans le temps ou de décrire une grandeur qui dépend de la position de mesure dans un espace, tel que la température ou la pression en thermodynamique.

Elles peuvent aussi modéliser l’influence d’un ou plusieurs paramètres sur un résultat, par exemple en biologie ou encore en chimie.En ce qui concerne la dérivée, certes il parait que ce n’est qu’une notion abstraite. Mais, elle aussi occupe une place primordiale dans les autres sciences.

Prenons le cas de physique, où elle sert à étudier le mouvement d’un objet, c’est-à-dire sa vitesse ainsi que son accélération.

Aussi le cas d’économie où elle peut servir à trouver le niveau de production qui maximise le bénéfice. Egalement son utilité en biologie dans le calcul du taux de croissance ainsi que dans la prédiction de l’évolution d’une colonie de bactéries. Et tout cela ce n’est que des applications parmi tant d’autres.

Du coup, l’objectif de mon projet est d’avoir une bonne approximation de la dérivée d’une fonction numérique connue seulement en un nombre fini de points tout en utilisant la méthode d’extrapolation de Richardson.

La théorie d’interpolation

Il y a plusieurs méthodes d’approximation des fonctions, tel que l’interpolation par les fonctions splines (graphique par ordinateur), les séries de Fouriers et leurs analogue discret (fonctions périodiques), et la méthode la plus classique : l’interpolation polynomiale grâce à sa simplicité au niveau de la détermination explicite du polynôme interpolé.

L’existence du polynôme est basée sur le théorème de Weirstrass

En ce qui concerne la construction du polynôme, il existe des méthodes directes et d’autres indirectes et chacune d’elles présente le même polynôme mais selon une base différente ainsi que des atouts et défauts distincts.

On étudie les méthodes les plus connues : la méthode de Vandermonde comme une méthode directe et la méthode de Lagrange et celle de Newton- Cotes comme méthodes itératives.

Remarque

Cette méthode ne peut être utilisé que pour ≤ 3 . Enfaite, si on augmente le nombre de points, la matrice de Vandermonde devient mal conditionnée car elle est pleine et il suffit juste une petite erreur sur les coefficients ou le second membre qui peut entrainer une erreur importante sur la solution du système.

Remarque

* Le polynôme de Lagrange n’est pas récursif donc on aura besoin du calcul des coefficients du polynôme chaque fois on change le nombre de points par exemple :

Selon la base canonique.

N.B : le polynôme interpolé obtenue avec la méthode de Lagrange est le même obtenue avec la méthode de Vandermonde, il est seulement exprimé selon des bases différentes.

Méthodes de Newton-Côtes

Cette méthode consiste à construire un polynôme selon la base de Newton qui interpole une fonction à partir de (n+1) points d’interpolation à l’aide de la notion des différences divisées et la récursivité du polynôme de Newton.

La dérivation

La dérivation numérique consiste à approximer la dérivée d’une fonction par différentes méthodes numériques soit dans le cas où le calcul analytique de la dérivée est très compliquées, soit on ne connait pas la forme analytique de la fonction.

Remarque

Dans certains cas on n’a pas la valeur de la fonction en les points nécessaires pour appliquer cette méthode, ce qui nous conduit à chercher une autre solution qui consiste à utiliser l’interpolation polynomiale aux points disponibles afin d’approximer la dérivée par la dérivation de l’interpolé de la fonction obtenu.

Extrapolation de Richardson

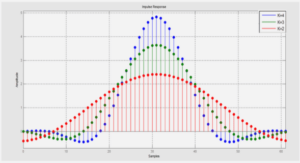

L’extrapolation de Richardson comporte à trouver une combinaison linéaire qui permet de se débarrasser du terme d’ordre inférieur dans l’expression de l’approximation de la dérivée afin d’augmenter l’ordre de la précision en utilisant les pas h, h/2, h/4,…etc.

Pour avoir en fin de compte une série d’approximations qui converge quadratiquement vers la dérivée.

Théoriquement

On essaye de comparer les différentes méthodes numériques de différentiation afin de voir la méthode la plus convenable et la plus rapide en convergence.

En outre, on cherche à montrer le rôle important que joue la méthode de l’extrapolation de Richardson dans la convergence vers la dérivée tout en précisant les erreurs entre les approximations obtenues par les autres méthodes et la dérivée .On prend par exemples les fonctions Pour chaque fonction, on calculera l’erreur obtenue par la méthode de l’approximation progressive et celle de différences centrées et on appliquera à chacune d’elles l’extrapolation de Richardson afin d’augmenter leurs ordre.

Bilan des Résultats

Dans chacune des fonctions étudiées, on remarque que Pour la méthode de différence centrée

Elle est d’ordre 2 et en appliquant une fois l’extrapolation de Richardson, elle devient d’ordre au moins 4 car les coefficients des puissances impaires de h sont nuls. Donc l’extrapolation de Richardson nous permet de gagner 2 ordres à chaque itération.

Convergence rapide Pour la méthode d’approximation progressive

Elle est juste d’ordre 1, et chaque fois on applique une itération de l’extrapolation de Richardson, on augmente d’un seul ordre.

Convergence lente par rapport à la méthode de différences centrées

En effet, en revenant aux résultats obtenus à l’ordre 4, par exemple pour la fonction , on remarque que les erreurs de l’extrapolation de Richardson appliquées à la méthode des différences centrées sont trop petites par rapport à ceux obtenues par l’application de l’extrapolation à l’approximation progressive pour de différents pas h.

Conclusion

Certes, il y a tant de méthodes d’approximations des dérivées des fonctions numériques. Mais peu qui peuvent assurer une bonne approximation de celles-ci. L’extrapolation de Richardson fait partie de ces méthodes là. Ainsi, son aspect itératif permet de gagner d’ordre à chaque itération selon la méthode choisie comme approximation initiale de la dérivée.

Et puisque le but des méthodes numériques est l’optimisation des calculs et du temps, il sera mieux de choisir l’approximation initiale de plus grand ordre afin de converger rapidement. Cette méthode introduite au début du XXe siècle par Lewis Fry Richardson, est un outil d’accélération de convergence non pas juste pour la dérivation mais encore pour l’intégration numérique, la résolution des équations différentielles et il en résulte d’autres méthodes comme celle de Romberg, de Gragg,…etc.

Et bien que l’extrapolation de Richardson soit principalement utilisée par les analystes, il existe aussi des situations probabilistes dans lesquelles celle-ci s’applique, notamment dès lors que le procédé de discrétisation s’intègre au sein d’une méthode de Monte-Carlo. Cependant, il ne faut pas la confondre avec l’extrapolation linéaire qui sert à approximer une fonction en un point en dehors de l’intervalle des points données en utilisant la régression et qui entre dans le cadre de prédiction.

Enfin, on peut dire que la méthode de l’extrapolation de Richardson est la méthode la plus convenable jusqu’aujourd’hui pour l’approximation d’une dérivée numériquement puisque on peut avoir une précision parfois très supérieure pour un temps de calcul comparable.

|

Table des matières

1 Introduction

2 La théorie d’interpolation

2.1 Méthode directe : Vandermonde

2.2 Méthodes itératives

2.2.1 Méthodes de Lagrange

2.2.2 Méthodes de Newton-Côtes

2.3 Erreur d’interpolation

2.3.1 Erreur de Lagrange

2.3.2 Erreur de Newton-Cotes

2.4 La formule de Taylor

3 La dérivation

3.1 Développement de Taylor

3.1.1 Méthodes de différences centrées

3.1.2 La dérivée d’ordre supérieure

3.2 Application de l’interpolation

4 Extrapolation de Richardson

4.1 Procédé générale

4.2 Erreur de l’extrapolation

4.3 Algorithme de l’extrapolation de Richardson

5 Application

5.1 Théoriquement

5.2 Pratiquement : Par Matlab

6 Conclusion

![]() Télécharger le rapport complet

Télécharger le rapport complet