Définition des digues fluviales

Une digue est « une construction établie dans le but de contenir les eaux ou de protéger de leurs effets (Kurtz, 1997) ». Une digue fluviale, ou encore digue de protection contre les inondations est une digue dont au moins une partie est construite en élévation au-dessus du niveau du terrain naturel et destinée à contenir épisodiquement un flux d’eau afin de protéger des zones naturellement inondables (Mériaux et al., 2004). Le Programme national américain d’assurance contre les inondations (NFIP) défini une digue comme « une structure, généralement un remblai de terre, conçue et construite pour contenir, contrôler ou détourner le flux d’eau de manière à réduire les risques d’inondation temporaire » ; il définit aussi le « système digue » comme « un système de protection contre les inondations qui se compose d’une digue ou de plusieurs digues, et les structures associées telles que les dispositifs de fermeture et de drainage qui sont construits et exploités conformément aux normes d’ingénierie relatives (NFIP, 2000) ». En général, la digue correspond à un ouvrage, le plus souvent en terre, construit le long du lit mineur du cours d’eau ou le long d’un canal ou le long du trait de côte et destiné à protéger les parcelles riveraines des venues d’eau ou à surélever la ligne d’eau (navigation, hydroélectricité) (Degoutte et al., 2012).

Les enjeux des territoires protégés par les digues fluviales

En France d’après le Ministère de l’écologie et du développement durable (MEDD, 2014), le risque inondation concerne une commune sur trois à des degrés divers dont 300 grandes agglomérations. Pour 160.000 km de cours d’eau, une surface de 22.000 km2 est reconnue particulièrement inondable : deux millions de riverains sont concernés. Les dégâts causés par les inondations représentent environ 80 % du coût des dommages imputables aux risques naturels, soit en moyenne 250 M€ par an. La moitié de cette somme relève des activités économiques (MEDD, 2014). Au titre d’exemple, sur les 450 km de la Loire Moyenne (entre le Bec d’Allier et le Bec de Maine), 600 km de digues protègent quelque 100.000 km² de vals inondables. Auxquels s’ajoutent les digues érigées le long des affluents tels que le Cher, l’Indre et la Vienne. Plusieurs villes importantes sont protégées par les digues comme : Tours avec 90.000 habitants concernés, Orléans et son agglomération avec 40.000 habitants, Blois avec 10.000 habitants, le Val d’Authion avec 45.000 habitants (Mériaux et al., 2001). Ces exemples montrent l’existence d’une forte interaction entre les ouvrages de protection contre les inondations et les territoires incluant les villes. En cas de défaillance, ces ouvrages sont donc susceptibles de propager des dysfonctionnements bien au-delà des zones soumises à l’aléa, et, par conséquent, causer beaucoup de dégâts. Ces ouvrages peuvent être considérés, du point de vue du génie urbain et de l’aménagement urbain, comme une porte d’entrées du risque au milieu urbain. Dès lors, une meilleure connaissance de leur fiabilité structurelle, face à un risque d’inondation redoutable, devient un enjeu urbain majeur pour les ingénieurs et pour les gestionnaires des ouvrages.

L’évaluation de la fiabilité structurelle des digues fluviales, leurs données disponibles et leurs incertitudes

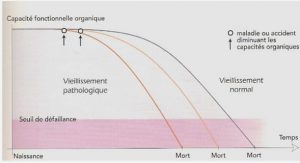

Définitions générales : La fiabilité est un élément essentiel pour les enjeux de sécurité et de performance des systèmes mécaniques et des systèmes de génie civil. L’estimation de la fiabilité permet à la fois de comprendre le passé et de préparer le futur d’un système en mode d’évaluation. De nombreuses difficultés se posent au contexte d’évaluation de la fiabilité d’un système ou d’un composant d’un système : 1) la nature du système/composant, 2) la qualité du retour d’expérience et sa nécessaire validation avant tout usage et, 3) le niveau de la maintenance préventive qui vise à réduire la probabilité de défaillance (Lannoy, 2009). Selon la norme Européenne EN 13306 (2001) liée aux domaines techniques, administratifs et de gestion de la maintenance, la fiabilité fonctionnelle est « l’aptitude d’un bien à accomplir une fonction requise, dans des conditions données, durant un intervalle de temps donné ». La Norme Européenne EN 1990 (2002) liée au domaine de la construction des systèmes de génie civil définit la fiabilité structurelle comme « la capacité d’une structure ou d’un élément structural à satisfaire aux exigences spécifiées, y compris la durée d’utilisation de projet, pour lesquelles il ou elle a été conçu(e). La fiabilité structurelle s’exprime habituellement en termes de probabilité ». En outre, cette norme exige qu’une structure (bâtiment et ouvrage de génie civil) doive être conçue et réalisée de sorte qu’elle doit, pendant sa durée de vie, résister à toutes les actions et influences susceptibles d’intervenir pendant son exécution et son utilisation et, elle doit aussi rester adaptée à l’usage pour lequel elle a été conçue. Dans ce contexte et précisément dans le contexte des ouvrages hydrauliques, la réglementation en France relative à la sûreté des ouvrages hydrauliques a évolué (décret du 11 décembre 2007), avec l’obligation faite pour les propriétaires des grands ouvrages de produire des études de dangers, des revues périodiques de sûreté, requérant d’évaluer régulièrement les ouvrages hydrauliques par des démarches d’analyse de risques et d’introduire autant que possible des démarches probabilistes. Or dans le domaine du génie civil, les ouvrages hydrauliques tels que les barrages et les digues ont toujours été considérés comme des ouvrages particuliers et sont restés à l’écart des règlements appliqués au bâtiment et aux ouvrages d’art. A ce titre, les Eurocodes qui visent à harmoniser progressivement le marché européen de la construction, n’ont pas vocation à être utilisés directement pour ces ouvrages spéciaux (Carvajal, 2009). Les méthodes de fiabilité des structures ont fait l’objet d’un développement important au cours de ces dernières années (Sudret, 2007). En revanche, la richesse de ces méthodes est fortement conditionnée par la pertinence de la représentation des données d’entrée, correspondant aux propriétés des matériaux et aux données techniques disponibles sur l’ouvrage. Dans le domaine de digues fluviales, l’évaluation de la fiabilité structurelle est particulièrement délicate en raison des faibles quantités de données disponibles. Les digues fluviales sont des ouvrages anciens, certaines datant du Moyen Age (Mériaux et al., 2001). Elles sont mal connues et ont généralement fait l’objet de peu de suivi au cours des siècles (Mériaux et al., 2001). Souvent, on ne possède ni leurs plans de construction ni les rapports d’éventuels travaux de réparation ou de confortement. Même lorsqu’elles sont gérées de manière correcte, ce problème d’acquisition de connaissance sur les ouvrages subsiste, en partie à cause de l’âge des digues, de leur construction par étapes successives, de leur fort linéaire et de l’absence d’instrumentation à l’intérieur des ouvrages (Mériaux et al., 2001). Ce manque de données rend la réalisation d’une étude d’analyse quantitative de fiabilité difficile à mettre en œuvre. Ce manque de données pourrait être présenté précisément par la présence des incertitudes entachant tous types de données disponibles sur les digues. D’une manière générale, l’incertitude « résulte essentiellement d’une épreuve dont le résultat n’est pas connu a priori et pourrait changer si on la recommençait ; elle représente la variabilité intrinsèque d’un phénomène (Boissier, 1993) ». Bouchon-Meunier (1995) la décrit comme « un doute sur la validité d’une connaissance ». Par exemple : je crois que la date de construction d’un bâtiment date de 1852 mais je n’en suis pas sûr (cas d’une connaissance précise mais incertaine). On distingue deux types d’incertitudes (entachant les données d’entrée) : incertitudes aléatoires et incertitudes épistémiques (Paté-Cornell, 1996 ; O’Hagan et al., 2006 ; Zio, 2009 ; Aven, 2010 ; Sallak et al., 2013). Les incertitudes aléatoires sont irréductibles et dues au caractère aléatoire ou à la variabilité naturelle d’un phénomène physique, tandis que les incertitudes épistémiques sont dues au caractère imprécis de l’information ou à un manque de connaissance et pourraient être réduites en faisant davantage d’efforts par le recueil de données, la consultation d’experts, les essais accélérés, etc. (Oberkampf et Helton, 2002 ; O’Hagan et al., 2006).

Les incertitudes entachant les données des digues : Dans le domaine des digues, les incertitudes épistémiques sont principalement les incertitudes liées à la dissémination des investigations le long des linéaires et la représentativité des données disponibles. Exemple : nous disposons de sondages géotechniques renseignant de la nature d’un remblai de digue dont on souhaite connaître la performance. Nous ne sommes pas certains que les sondages soient représentatifs de l’ensemble de l’ouvrage, longitudinalement comme transversalement. Nous pouvons en revanche réduire cette incertitude épistémique en augmentant le nombre de sondages. Nous trouvons également les incertitudes épistémiques liées aux modèles, qui reposent sur des hypothèses présentant des incertitudes. Exemple : les résultats d’une modélisation hydraulique de la ligne piézométrique au sein de la digue dépendent des hypothèses adoptées pour la perméabilité des matériaux, la durée de sollicitation des ouvrages, etc. (Vuillet et al., 2013). Dans le même ordre d’idée, les incertitudes aléatoires sont principalement les incertitudes liées à la variabilité naturelle des propriétés des matériaux. Exemple : nous possédons un grand nombre de mesures d’une propriété étudiée du remblai constitutif d’un corps de digue. On constate que d’un point à un autre, la propriété varie ; ceci implique, si la mesure de la propriété est considérée comme parfaite, une variabilité spatiale de cette propriété au sein du remblai. De même, pour un point donné la propriété mesurée peut varier au cours du temps à cause de mécanismes de dégradations ou de vieillissement. Nous trouvons également les incertitudes liées au caractère aléatoire des sollicitations hydrauliques et hydrodynamiques. Exemple : quelle est l’occurrence d’une crue atteignant telle hauteur critique et venant impacter une digue (Vuillet et al., 2013) ?

L’évaluation de la fiabilité structurelle des digues fluviales dans un contexte incertain Du point de vue de l’ingénierie, seul le mécanisme du glissement bénéficie d’une définition et de caractérisation de l’état-limite suffisamment précises pour permettre le calcul d’une probabilité de défaillance par des approches quantitatives. Les autres mécanismes de défaillance (érosion interne, affouillement, surverse) présentent des difficultés significatives pour l’évaluation d’une probabilité de défaillance. Ces difficultés proviennent, en premier lieu, de la forte présence d’incertitudes épistémiques sur les données (manque de données statistiques), et sur les mécanismes complexes de défaillance ; en deuxième lieu, elles proviennent des incertitudes aléatoires tout au long du linéaire de la digue, du fait de la variabilité naturelle de la disposition et des propriétés des matériaux constitutifs de l’ouvrage. Une autre difficulté réside également dans le manque des lois de comportement et de critères d’états-limites nécessaires pour modéliser le comportement réel de la défaillance des digues. Cela conduit à une prédominance du jugement expert dans l’évaluation d’une probabilité de défaillance.

Synthèse : La double difficulté du manque de données d’un côté et, les incertitudes qui les entachent d’un autre côté, freine la possibilité d’utiliser des méthodes statistiques et probabilistes d’analyse de fiabilité. Cela nécessite de disposer tout d’abord d’une source alternative de données et de méthodes adaptées à ce contexte permettant la réalisation d’une étude de fiabilité. Comme évoqué ci-dessus dans le domaine des digues, on utilise par défaut l’expertise humaine permettant la réalisation d’une analyse de fiabilité par la détermination de probabilités subjectives de défaillance à dires d’experts.

Construction d’un panel d’experts

Un panel d’experts réunit plusieurs spécialistes indépendants et reconnus dans les domaines correspondant au problème évalué. Le panel produit collectivement un jugement sur la valeur du problème évalué et de ses effets, où inversement, chaque expert, séparément, donne son jugement sur la valeur du problème évalué et de ses effets ; ces différents jugements feront l’objet d’une agrégation mathématique afin de déterminer une seule valeur finale. Le panel d’experts est un outil permettant de disposer rapidement et à faible coût d’un jugement global intégrant : 1) les principales informations connues sur le problème et 2) les multiples expériences antérieures et extérieures liées au problème évalué (Commission européenne, 1999). Le panel d’experts est un groupe de travail spécialement constitué et réuni à l’occasion d’évaluation ou de jugement d’un problème spécifique. On fait appel aux panels d’experts pour dégager un consensus sur des questions complexes et mal structurées pour lesquelles, les autres outils (analytiques, expérimentaux…) ne permettent pas d’obtenir des réponses fiables ou crédibles (Commission européenne, 1999). Par ailleurs, le processus de la construction d’un panel d’experts, ayant comme objectif d’avoir un jugement expert par consensus, peut être divisé en quatre étapes suivantes (Commission européenne, 1999) : 1) identification d’une liste d’experts potentiels, 2) sélection des experts, 3) investigations, et, 4) synthèse.

Etape 1 – Identification d’une liste d’experts potentiels : Cette étape consiste à sélectionner les membres du panel qui doivent être des spécialistes reconnus dans au moins un des champs concernés par le problème d’évaluation. Ils doivent avoir une large expérience du domaine et être indépendants des commanditaires qui gèrent la tâche d’évaluation. Ils doivent, par ailleurs, avoir la disponibilité et la volonté de s’impliquer dans l’évaluation.

Etape 2 – Sélection des experts : Le panel peut être généralement composé de six à douze membres appartenant aux différents champs d’expertise. L’objectif est d’avoir un panel d’experts ayant une diversité de spécialités pour mieux répondre aux problèmes du contexte d’évaluation.

Etape 3 – Investigations : Les experts se réunissent régulièrement pour réaliser la tâche demandée selon un plan de temps bien déterminé au préalable. Afin de donner leurs avis sur le problème d’évaluation, les experts doivent examiner et consulter la base de données liée au problème d’évaluation: 1) la documentation liée au problème, 2) les rapports d’activités, 3) les études préalables réalisées, 4) les enquêtes et 5) les publications. Dans un certain cas spécial, le panel pourrait réaliser des visites sur le terrain, individuellement par chaque expert mais, il est préférable de les réaliser en binômes pour limiter autant que possible les biais susceptibles d’entacher leurs jugements.

Etape 4 – Synthèse : Le panel produit un rapport et formule des conclusions et des recommandations acceptées collectivement. Si les points de vue divergent, le panel discute jusqu’à obtention d’un consensus. En cas de désaccord, il peut être utile d’exprimer la conclusion majoritaire et d’annexer un commentaire de l’expert minoritaire.

Introduction au concept de calibration et d’agrégation du jugement d’expert

La calibration des avis experts est une étape qui consiste à évaluer et pondérer les avis experts par rapport à des variables dont les vraies valeurs sont connues. Ces dernières s’appellent « variables de calibration ». Cette procédure permet de caractériser les experts en tant que sources d’information, en accordant à leurs estimations un poids de calibration qui d’un côté, reflète la qualité et la quantité de l’information donnée par chaque expert et, d’un autre côté, permet de pondérer les estimations des experts en vue de les combiner en un seul avis (O’Hagan et al., 2006). Il est utilisé ensuite pour pondérer et combiner des avis experts donnés sur des variables d’intérêt dont les vraies valeurs sont inconnues. O’Hagan et al. (2006) associe les différents modèles de calibration aux modèles d’agrégation des avis experts. Il distingue entre deux approches d’agrégation : une approche d’agrégation mathématique et une approche d’agrégation comportementale. L’approche mathématique contient plusieurs modèles comme la méthode bayésienne, le regroupement d’opinions et la méthode classique de Cooke (O’Hagan et al., 2006). L’approche comportementale constitue en un groupe d’élicitation ou panel d’expert ayant comme objectif de fournir une seule réponse par consensus (O’Hagan et al., 2006). Dans le cadre scientifique de notre recherche, nous nous intéressons aux modèles mathématiques d’agrégation et de calibration des avis experts comme le modèle classique de calibration de Cooke (1991) et le modèle d’agrégation des avis experts de Lichtendahl et al. (2013). En effet le modèle de Cooke (1991) permet, d’un côté de réaliser une analyse rigoureuse en vue d’attribuer un poids de calibration à chaque expert du panel pour les caractériser en tant que sources d’information et, d’un autre côté il est possible de l’associer à d’autres modèles mathématiques de traitement de jugement d’expert dans l’objectif d’agréger les avis experts calibrés. Aussi le modèle d’agrégation des avis experts de Lichtendahl et al.(2013) permet d’agréger les avis experts donnés sous format probabiliste et de déterminer un seul avis expert agrégé. Dans la suite nous aborderons en détail les principes de ces deux modèles de calibrations et d’agrégation des avis experts.

|

Table des matières

INTRODUCTION

Partie I Contexte d’évaluation de la fiabilité des digues fluviales

1 Etat de l’art sur les méthodes d’évaluation de la fiabilité structurelle des digues fluviales

1.1 Les digues

1.2 Approches courantes de l’ingénierie pour l’évaluation de la sûreté des digues fluviales

1.3 Approche fonctionnelle déterministes pour l’évaluation de la sûreté des digues

1.4 Approches probabilistes pour l’évaluation de la sûreté des digues

1.5 Synthèse

2 Experts, jugement expert et biais

2.1 Experts et panel d’experts

2.2 Les biais

2.3 Synthèse

3 Traitement du jugement expert mis en œuvre pour l’évaluation des ouvrages hydrauliques

3.1 Traitement du jugement expert dans la littérature statistique

3.2 Traitement et élicitation quantitatifs des dires d’experts mis en œuvre pour l’évaluation de la sûreté des ouvrages hydrauliques

3.3 Traitement et élicitation des dires experts mis en œuvre pour l’évaluation de la performance des digues fluviales

3.4 Synthèse

4 Proposition de thèse

4.1 Problématique de la thèse

4.2 Objectif de la thèse

4.3 Questions scientifiques

4.4 Méthodologies scientifiques disponibles

4.5 Démarches de la thèse

Partie II Méthodologies pour l’identification et la réduction des biais heuristiques susceptibles d’altérer les évaluations expertes du niveau de sûreté des digues fluviales

5 Méthodes de recueil et de traitement des évaluations à dires d’experts

5.1 Principes des méthodes de traitement du jugement d’expert

5.2 Méthodes d’élicitation du jugement d’expert

5.3 Méthodes de calibration et d’agrégation des évaluations à dires d’experts

5.4 Méthodes de dé-biaisage du jugement d’expert

5.5 Récapitulatif des méthodes de traitement des biais du jugement d’expert

5.6 Synthèse

6 Proposition d’une démarche de traitement du jugement d’expert pour l’évaluation probabiliste de la fiabilité structurelle des digues fluviales à partir du jugement d’expert

6.1 Principes de la démarche proposée

6.2 Démarches pour l’élicitation des jugements d’experts

6.3 Démarches pour la calibration et l’agrégation des jugements d’experts

6.4 Démarches pour le dé-biaisage des jugements d’experts

6.5 Approches proposées

6.6 Synthèse

Partie III Application et valorisation

7 Présentation de l’étude de cas

7.1 Données géométriques

7.2 Données géotechniques

7.3 Données hydrauliques

7.4 Synthèse

8 Application de l’approche « EiCAD »

8.1 Approche « EiCAD » – Elictation individuelle, Calibration, Agrégation et Débiaisage des avis experts

8.2 Comparaison des résultats des modalités

8.3 Conclusion générale de l’approche « EiCAD »

9 Application de l’approche « EiDA »

9.1 Approche « EiDA » – Elicitation individuelle, Dé-biaisage et Agrégation des avis experts

9.2 Comparaison des modalités

9.3 Conclusion générale de l’approche « EiDA »

10 Comparaison des approches « EiCAD » et « EiDA »

10.1 Comparaison quantitative des approches « EiCAD » et « EiDA » selon les modalités d’application

10.2 Application d’ « EiCAD » et d’ « EiDA » sur les variables d’intérêt

10.3 Analyse inter-comparée des approches

CONCLUSION

BIBLIOGRAPHIE

Télécharger le rapport complet