Télécharger le fichier pdf d’un mémoire de fin d’études

L’oralisation pour l’apprentissage de la lecture

L’apprentissage de la lecture chez l’enfant passe par l’oralisation. Or, l’oralisation de la lecture en classe est chronophage, car elle nécessite d’être réalisée de manière individuelle et séquentielle, c’est-à-dire un·e élève après l’autre. Elle est donc aujourd’hui très peu pratiquée en classe alors qu’elle est essentielle pour apprendre à lire.

Importance de l’oralisation pour l’enfant

D’après [Beaume 1987], il faut distinguer deux termes : la lecture orale et la lecture à voix haute.

La lecture orale désigne le fait pour l’enfant d’oraliser sa lecture avant d’être capable de lire silencieusement. Elle permet à l’apprenant·e de transformer les signes écrits en sons, et de construire le sens de ce qu’il ou elle lit par l’écoute de ces sons. L’oralisation précède et permet la compréhension. Lorsque l’enfant arrive à déchiffrer seul·e la plupart des mots rencontrés, la lecture orale guidée par un·e adulte permet d’améliorer significativement la capacité de l’enfant

à reconnaître un mot, ainsi que sa fluence et sa compréhension, d’après le rapport de 2000 du National Reading Panel 9, une institution du département de l’éducation des États-Unis. Cette observation s’applique aussi bien aux bon·ne·s lecteur·rice·s qu’aux élèves en difficulté, sur une large fourchette de niveaux de lecture.

La lecture à voix haute n’est possible qu’à un niveau plus avancé, car elle est précédée d’une lecture silencieuse visant à la compréhension du texte, et consiste ensuite à lire ce texte avec restitution de sens, pour soi-même ou pour un auditoire [Beaume 1987]. L’enseignement de la fluence par des exercices de lecture à voix haute a montré des effets positifs sur le niveau global de lecture des élèves en bénéficiant, d’après le rapport de 2005 du National Reading Panel 10. La lecture à voix haute d’un texte permet de travailler la maîtrise du texte, la prononciation, l’articulation, l’intonation, l’interprétation et la restitution du sens du texte [Ros-Dupont 1999]. Enfin, d’après le même ouvrage, la lecture à voix haute joue un rôle important dans la motivation de l’élève à apprendre à lire : être capable de lire un texte à un·e parent·e, un·e ami·e ou un petit frère ou petite sœur est source de satisfaction pour l’enfant.

Concernant les modalités d’enseignement de la lecture orale ou à voix haute, il a été observé que la répétition permet d’améliorer la qualité de la lecture [Levy 1995]. Une amélioration dans la vitesse de lecture et la compréhension a été notée lorsqu’un·e élève lit un passage de façon répétée [Stoddard 1993]. Enfin, il est important pour l’élève de bénéficier d’un retour sur sa lecture, par un·e enseignant·e ou un·e parent·e10.

Cette étude nous confirme l’importance pour les élèves de s’entraîner à lire oralement, puis à voix haute pour développer leurs capacités de lecture. Nous nous intéressons dans cette thèse principalement à la lecture orale, puisque nos données de parole proviennent d’enfants utilisateurs de Lalilo en classes de CP, CE1 et CE2, dans lesquelles le niveau de lecture des élèves nécessite encore souvent de passer par la lecture orale avant de pouvoir lire silencieusement. Nous étudierons dans notre travail les particularités acoustiques et linguistiques de la lecture orale de jeunes enfants et leur impact sur la précision de la reconnaissance automatique de la parole.

Pratiques de lecture orale en classe

Afin de comprendre les pratiques de lecture orale à l’école en France, et en déduire des applications utiles de la reconnaissance vocale pour l’apprentissage de la lecture, j’ai créé un sondage et l’ai envoyé à plus de 600 professeur·e·s utilisant Lalilo. Nous avons reçu 79 réponses, principalement d’enseignant·e·s de CP (49,4%), de classes mixtes CP-CE1 (13,4%), de CE1 (7,6%) ainsi que de classes ULIS (Unités Spécialisées d’Inclusion Scolaire), des classes spécialisées pour enfants avec un handicap cognitif (8,9%). Nous présentons ici les résultats de ce sondage.

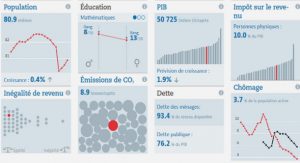

Les graphiques de la figure 1.5 présentent le temps passé en moyenne par semaine à apprendre à lire en classes de CP et CE1. Sachant que les élèves passent environ 30 heures en classe chaque semaine, nous pouvons constater que l’apprentissage de la lecture occupe une part très importante de l’enseignement, notamment en CP. Cela est d’autant plus vrai que ces temps ne représentent que l’enseignement spécifique de la lecture, alors qu’en réalité les élèves s’entraînent à lire dans chaque matière, par la lecture et compréhension des énoncés.

Paradoxalement, nous voyons sur la figure 1.6 que la moitié des professeur·e·s évaluent la lecture à voix haute de leurs élèves individuellement moins d’une fois par mois, ce qui ne paraît pas suffisant pour suivre les progrès et difficultés de chaque élève. Une proportion significative (20,3%) des répondant·e·s ont déclaré évaluer leurs élèves continuellement à partir des interventions de chacun dans l’enseignement commun, mais pas forcément de façon individuelle. Ces observations pourraient témoigner d’un manque de temps et d’outils dédiés pour l’évaluation individuelle de la lecture à voix haute.

Les répondant·e·s devaient également choisir les tâches de lecture orale données aux élèves individuellement pour évaluer leur niveau de lecture. Nous voyons sur la figure 1.7 que les tâches les plus courantes sont la lecture orale d’histoire, avec support visuel et sans questions de compréhension, et la lecture orale de liste de mots, chronométrée ou non. La lecture de phrases ou de mots isolés sont également donnés, mais plutôt pour l’entraînement et non pour l’évaluation, qui nécessite un contenu assez long.

Des questions sur la pertinence de faire un retour à l’enfant ont été posées : 86,1% des répondant·e·s trouvent utile de faire un retour à l’enfant à la fin de sa lecture, et 20,3% au moment de l’erreur. Cela dépend évidemment du contenu à lire (mots, phrases, histoire) et du cadre de la lecture : en entraînement, le retour est préféré relativement immédiat (après le mot ou la phrase) alors qu’en évaluation le retour se fait généralement en fin de lecture afin de ne pas perturber l’élève dans sa lecture. 85,9% des répondant·e·s souhaitent un retour sonore, avec lecture du mot correct à l’élève, et 71,8% un retour visuel, par exemple en affichant les mots contenant des erreurs en rouge.

Enfin, les enseignant·e·s ont dû choisir, parmi une liste de métriques pour l’évaluation du niveau de lecture orale créée avec l’aide de l’équipe pédagogique de Lalilo, les cinq métriques qu’il·elle·s utilisent le plus souvent. Les réponses, détaillées figure 1.8, montrent que la métrique la plus utilisée est le nombre de mots corrects par minute, suivie de près par le pourcentage de succès (nombre de mots correctement lus divisé par nombre de mots lus). Un score d’expressivité est également beaucoup utilisé, évalué de façon subjective par l’enseignant·e, ainsi que le temps moyen pour lire un mot, mesuré entre la fin du mot précédent et la fin du mot courant afin d’inclure le temps de réflexion entre mots. Arrivent ensuite diverses métriques mesurant un nombre d’évènements : auto-corrections montrant que l’enfant a compris son erreur, substitutions/suppressions de phonèmes ou mots, hésitations intra- ou inter-mots…

Les insertions et évènements liés à la fluence (faux départs et répétitions) semblent moins importants pour l’évaluation de la lecture orale. Ces réponses sont bien sûr liées aux classes enseignées par les répondant·e·s : les erreurs de fluence auraient sûrement plus d’importance pour des enseignant·e·s de niveaux plus élevés.

Ce sondage nous confirme l’importance de la lecture orale dans les classes de CP, CE1 et CE2, et suggère que les enseignant·e·s pourraient bénéficier d’outils dédiés pour les aider à faire lire oralement leurs élèves. Il semble également important de donner un retour à l’enfant sur sa lecture, ce que l’enseignant·e n’a pas toujours le temps de faire régulièrement avec chaque enfant de façon individuelle, mais qu’un système de reconnaissance vocale pourrait fournir. Nous apprenons également quelles métriques utilisent les enseignant·e·s pour évaluer le niveau de lecture d’un·e élève, ce qui nous permet de réfléchir à la possibilité de générer ces métriques à partir d’un système de reconnaissance automatique de la parole.

La reconnaissance vocale pour l’apprentissage de la lecture

La reconnaissance automatique de la parole paraît apte à répondre aux différents besoins des élèves et enseignant·e·s, étudiés dans les sections précédentes. La plateforme Lalilo contient un exercice de lecture orale, qui nous intéressera tout particulièrement dans cette thèse. Il utilise en effet la reconnaissance automatique de la parole de l’enfant pour lui faire un retour sur la qualité de sa lecture. L’amélioration de la précision de cet exercice, par l’amélioration du système de reconnaissance automatique de la parole, est donc l’objectif premier de cette thèse.

Utilité de la reconnaissance vocale pour la lecture orale en classe

Un exercice de lecture orale permet tout d’abord de fournir un outil aux élèves pour s’entraîner à lire oralement sans subir la pression de la présence d’un public (enseignant·e ou camarades) qui peut être intimidante. Le système de RAP permet de fournir un retour à l’enfant, essentiel d’après le rapport du National Reading Panel 10 et les résultats de notre sondage.

Parmi les métriques couramment utilisées par les enseignant·e·s (voir figure 1.8), une grande partie sont mesurables à partir des sorties d’un système de RAP : nombre de mots corrects par minute, pourcentage de succès, temps moyen pour lire un mot, nombre d’évènements spécifiques… Outre la qualité de lecture de l’enfant, certaines métriques de fluence ont montré des capacités à prédire avec précision des scores de compréhension écrite [Kim 2011, Sabatini 2019]. Elles pourraient ainsi être utilisées pour identifier en amont des élèves risquant d’avoir des difficultés en compréhension [Roehrig 2008] et leur offrir un soutien supplémentaire dès le plus jeune âge.

Dans le cadre de notre sondage pédagogique, et dans la perspective d’améliorer l’exercice de lecture orale de Lalilo pour répondre aux besoins des professeur·e·s, nous leur avons demandé quelles informations et fonctionnalités supplémentaires leur seraient utiles. Nous voyons sur la figure 1.9 que les trois réponses les plus fréquentes relèvent d’analyses détaillées des lectures orales d’un élève à partir des sorties du système de RAP. Ces analyses dépendent de la qualité de la reconnaissance : le système doit non seulement être capable de détecter que l’enfant a fait une erreur, mais aussi de savoir sur quel mot et de reconnaître l’erreur faite (substitution d’un [b] par un [d], lecture de « ent » muet à la fin d’un mot…). 67,1% de répondant·e·s ont également manifesté leur intérêt pour un accès aux enregistrements de leurs élèves, afin de pouvoir écouter leur lecture et en évaluer la qualité ell·eux-mêmes. Cette fonctionnalité a été ajoutée à l’interface professeur·e en 2021 (voir figure 1.10).

L’exercice de lecture orale de Lalilo

L’exercice de lecture orale existe dans la plateforme depuis 2018, et a été amélioré de façon itérative grâce aux retours des utilisateur·rice·s de Lalilo. Le contenu proposé à la lecture orale a également évolué : dans un premier temps uniquement des mots isolés étaient proposés, puis des phrases de quatre à huit mots. Récemment ont été ajoutées des listes de syllabes et de mots et des phrases longues pour correspondre aux besoins des enseignant·e·s (voir figure 1.7), ainsi que des lettres et syllabes isolées pour les plus jeunes enfants. Parmi les 35 millions d’exercices joués en France durant l’année scolaire 2020-2021, plus de 400 000 étaient des exercices de lecture orale.

L’exercice se déroule de la façon suivante :

1. Le mot ou la phrase à lire est affichée pendant que l’enfant écoute l’instruction de l’exercice ;

2. L’enfant clique sur le microphone et lit à voix haute ;

3. L’enfant écoute son enregistrement et indique s’il·elle est content·e de sa lecture ou non. Sinon, l’enfant a la possibilité de se réenregistrer ;

4. Une fois sa réponse validée, que la lecture soit correcte ou non, l’enfant entend la lecture correcte du contenu à lire.

Le contenu à lire est choisi par l’algorithme d’apprentissage adaptatif : en fonction de son niveau, l’enfant doit lire un certain contenu, et le(s) mot(s) à lire correspondent à une leçon en cours d’acquisition par l’enfant.

Le fonctionnement du système global de RAP permettant de faire un retour à l’enfant dans l’exercice de lecture à voix haute est décrit sur la figure 1.12. Nous avons accès à deux sources d’informations à l’entrée : le texte à lire et l’enregistrement de la lecture de l’élève. Tout d’abord, une étape de pré-traitement consiste à extraire des paramètres acoustiques du signal audio afin de condenser l’information utile à la reconnaissance. Le processus d’extraction est décrit dans le chapitre 3. Ces paramètres servent ensuite à deux tâches en parallèle : un alignement forcé et une reconnaissance de phonèmes. Cette thèse porte uniquement sur la brique de reconnaissance automatique de phonèmes, encadrée en rouge sur la figure 1.12.

La tâche d’alignement forcé consiste à localiser chaque mot et phonème prononcé sur l’enregistrement de parole grâce à un système de RAP. Le texte effectivement lu par l’enfant pouvant être différent du texte qu’il·elle devait lire (erreurs de lecture, répétitions, omission de mots…), le système utilise un modèle de langage modifié, incorporant les possibles altérations du texte de référence. En s’appuyant sur l’enregistrement de lecture, le module d’alignement forcé peut donc déjà prédire la présence de potentielles erreurs de fluence. En sortie, nous obtenons les frontières temporelles de chaque mot et chaque phonème supposés lus par l’enfant.

La modélisation acoustique pour la reconnaissance de phonèmes constitue le sujet central de cette thèse et sera bien sûr décrite de façon exhaustive dans la suite de ce manuscrit : nous n’en faisons qu’une description générale dans cette section. La tâche de reconnaissance de phonèmes ne s’appuie pas sur le texte à lire, mais uniquement sur les paramètres acoustiques du signal audio. Son objectif est de détecter le plus précisément possible les phonèmes réellement émis par l’enfant, ainsi que leur position dans le signal de parole. La reconnaissance de phonème est préférée à une reconnaissance classique de mots, moins précise et ne permettant pas de gérer des erreurs de lecture menant à des mots non existants ou incomplets.

À partir des sorties de ces deux modules de reconnaissance vocale est calculé un score de Goodness of Pronunciation (GOP) [Witt 2000, Kanters 2009], mesurant la probabilité que l’enfant ait prononcé le phonème correspondant au graphème à lire. Des paramètres dérivés sont également calculés, comme la moyenne et variance du GOP sur un mot. D’autres paramètres sont extraits du texte à lire (nombre de phonèmes, nombre de lettres, difficulté du mot…), de l’enregistrement brut (taux de saturation) ou des sorties du module d’alignement forcé (durée du mot, temps de parole de l’enfant, rapport signal à bruit…) et de reconnaissance de phonèmes (distance de Levenshtein [Levenshtein 1966] entre la séquence de phonèmes prédite et la séquence de phonèmes correspondant aux graphèmes à lire…).

Ces paramètres fournissent de l’information à deux algorithmes : un module de décision, qui calcule une probabilité d’exactitude pe de la lecture de l’enfant, et un module de confiance, qui calcule une probabilité de confiance pc du système de décision. Le premier est un algorithme de machine learning fondé sur des arbres de décision, nommé XGBoost 11. Le second utilise le Trust Score [Jiang 2018], score qui mesure l’accord entre le module de décision et un second module fondé sur l’algorithme des plus proches voisins. À l’aide de seuils scorrect et sconfiance fixés sur la probabilité d’exactitude et la probabilité de confiance, le système rend sa décision finale pour chaque mot du texte à lire. Les seuils sont choisis de façon à minimiser le taux de faux positifs, c’est-à-dire la détection d’une mauvaise lecture alors que l’enfant a correctement lu, qui causent énormément de frustration. Il existe trois cas possibles, définis dans le tableau 1.1. Dans le premier cas, le système est certain que la lecture est correcte : l’enfant reçoit des félicitations, et le système d’apprentissage adaptatif considère la question comme réussie. Dans le second cas, le système est certain que la lecture est incorrecte : l’enfant reçoit des encouragements à poursuivre ses efforts, et le système d’apprentissage adaptatif considère la question comme incorrecte. Enfin, si le système est incertain, l’apprentissage adaptatif ne tient pas compte de cette question, et il est demandé à l’élève de s’auto-évaluer. Cela permet, scientifiquement, d’avoir une indication sur le retour que le système aurait dû fournir, et pédagogiquement d’entraîner l’enfant à prendre conscience de son apprentissage. Une bonne précision du module de reconnaissance de phonèmes est donc primordiale pour fournir un retour adapté à l’enfant, dans lequel le système global a confiance : nous travaillons dans cette thèse à l’amélioration de cette précision.

Modèles acoustiques génératifs GMM-HMM

Les ancêtres des modèles actuels ont émergé dans les années 70, grâce à l’utilisation des chaînes de Markov cachées (Hidden Markov Models, HMM), formalisées dans [Baum 1967], pour la reconnaissance automatique de la parole [Baker 1975, Jelinek 1976]. Des travaux majeurs introduisant la théorie des HMM et présentant des exemples d’application aux problèmes de la RAP ont contribué à démocratiser leur utilisation [Rabiner 1983, Levinson 1983, Rabiner 1986]. En effet, puisque la parole présente une structure temporelle séquentielle, les HMM fournissent une architecture particulièrement adaptée pour sa modélisation. Les HMM avaient ainsi pour rôle de modéliser l’enchaînement temporel d’unités de la parole, dont la distribution statistique était modélisée par une simple distribution Gaussienne. Cette distribution se fonde sur l’hypothèse que les données à modéliser (ici, les paramètres acoustiques) sont symétriques et uni-modales, ce qui n’est absolument pas le cas, d’après [Gales 2008], pour des données de parole, dans lesquelles le genre, l’accent et les fréquences du locuteur ou de la locutrice forment plusieurs modes.

Au milieu des années 80, des techniques de modélisation statistique plus avancées, telles que les mélanges de lois Gaussiennes (Gaussian Mixture Model, GMM) [Juang 1985], sont introduites. Les GMM sont des distributions très flexibles capables de modéliser des distribu-tions asymétriques et multi-modales, et donc mieux adaptées à la modélisation de la parole. Les GMM ont ainsi été combinés aux HMM pour obtenir les systèmes hybrides tels que nous les connaissons aujourd’hui : les GMM-HMM.

Dans un modèle acoustique GMM-HMM dit « monophone », c’est-à-dire traitant chaque phone indépendamment de ses voisins, chaque phone est représenté par un HMM à trois états modélisant le début, le milieu et la fin du phone. Une représentation de ce HMM est affichée en figure 2.2.

Les probabilités de transition aij entre deux états si et sj sont apprises par le HMM durant l’entraînement. Lorsque nous entrons dans un état sj , un vecteur acoustique y est émis grâce à la distribution bj () associée à cet état. Cette distribution est modélisée par le GMM, mélange de composantes gaussiennes qui sont sommées selon : M bj (y) =cjmN (y; μ(jm), Σ(jm)) (2.4) où cjm est la probabilité a priori de chaque composante m pour l’état sj , et dont la somme sur m = 1,…,M est unitaire. μ et Σ sont les moyennes et variances associées à la gaussienne m pour l’état sj .

Les modèles GMM-HMM sont soumis à deux hypothèses découlant du HMM. La première considère qu’un état est conditionnellement indépendant de tous les autres états sachant l’état précédent : cela limite donc la dépendance d’un état uniquement à l’état précédent. La seconde concerne les émissions acoustiques : celles-ci sont conditionnellement indépendantes des autres émissions et ne dépendent que de l’état qui les a générées.

Différentes techniques d’amélioration des GMM-HMM ont émergé. Les modèles « triphone » instaurent la prise en compte du contexte et des effets de co-articulation en modélisant des trinômes de phones [Schwartz 1985]. Les triphones rares, ne pouvant être correctement modélisés, ont ensuite été regroupés grâce à des arbres de décision [Bahl 1991]. Des techniques d’adaptation ont ensuite été utilisées pour améliorer les performances de ces modèles, comme l’analyse discriminante linéaire (Linear Discriminant Analysis, LDA), technique de sélection de paramètres, la méthode Speaker Adaptive Training (SAT) [Anastasakos 1997], qui consiste à modéliser des caractéristiques du·de la locuteur·rice à partir des paramètres acoustiques, ou encore la méthode Feature-space Maximum Likelihood Linear Regression (fMLLR) [Gales 1998], visant à adapter les paramètres acoustiques à l’environnement et au·à la locuteur·rice.

Les modèles GMM-HMM restent cependant limités par les problèmes suivants :

— les fonctions de densité de probabilité sont décrites par des mélanges de Gaussiennes, dont la complexité et donc la qualité de modélisation doit être ajustée à la quantité de données disponibles;

— l’algorithme d’entraînement cherche à maximiser la vraisemblance avec la distribution réelle des données plutôt que les probabilités postérieures, impliquant ainsi une pauvre

Reconnaissance automatique de la parole capacité de discrimination.

Modèles acoustiques hybrides DNN-HMM

L’idée de remplacer les GMM par des réseaux de neurones artificiels (Artificial Neural Network, ANN) est apparue à la fin des années 80. Les ANN qui ne comportaient qu’une seule couche neuronale étaient cependant incapables d’apprendre des représentations complexes comme celle de la parole, et les puissances de calcul disponibles à cette époque n’étaient pas suffisantes pour l’apprentissage automatique de réseaux de neurones avec un grand nombre de couches. Des réseaux de neurones peu profonds (Deep Neural Networks, DNN) sous la forme de simples perceptrons multi-couches (Multi-Layer perceptron, MLP) ont toutefois été utilisés avec succès pour des tâches primaires [Morgan 1990, Lippmann 1990, Bourlard 1990], par exemple de la reconnaissance de chiffres énoncés oralement. Ces réseaux MLP avaient cependant tendance à mal reconnaître les sons contenant une grande variabilité temporelle, comme les consonnes plosives, de par leur incapacité à gérer la nature séquentielle temporelle des signaux de parole. Pour pallier à ce problème, [Waibel 1989] a alors proposé les réseaux de neurones à délais temporels (Time-Delay Neural Networks, TDNN), qui sont encore utilisés aujourd’hui et dont le fonctionnement sera détaillé au chapitre 3.

Ce n’est qu’à partir des années 2000, après le développement des puissances de calcul de nos ordinateurs et l’apparition des GPU, que les DNN se sont démocratisés. Ils sont d’abord utilisés en conjonction avec les GMM : les systèmes « tandem » consistent à entraîner un classifieur DNN à prédire des probabilités postérieures de phonème indépendamment du contexte, et à se servir des représentations extraites comme paramètres d’entrée d’un système GMM-HMM [Hermansky 1999, Ellis 2001]. En 2006, [Hinton 2006] propose un des premiers modèles profonds efficace en remplacement des GMM : ce modèle génératif, nommé Deep Belief Network (DBN), est un empilement de sous-réseaux sous forme de machines de Boltzman restreintes [Hinton 1983]. Un modèle DBN a ensuite été utilisé pour initialiser les poids d’un DNN par [Mohamed 2011], dont le modèle DNN-HMM final surpasse un modèle GMM-HMM pour une tâche de RAP.

Les modèles DNN-HMM présentent cependant une tendance à s’adapter trop fortement aux données d’entraînement et à ne pas pouvoir généraliser les connaissances acquises sur des don-nées inconnues et potentiellement légèrement différentes. La technique de dropout [Hinton 2012] a permis de résoudre ce problème de sur-apprentissage, et a rendu les modèles DNN-HMM plus populaires. La création de nouvelles fonctions d’activation, par exemple la fonction Rectified Linear Unit (ReLU) [Nair 2010] et ses dérivées, remplaçant les fonctions classiques linéaire et sigmoïde, a également apporté des solutions aux problèmes de disparition ou d’explo-sion de gradients des DNN. Les i-vecteurs, proposés initialement pour la reconnaissance de locuteur·rice [Dehak 2011], encodent de l’information sur l’identité vocale du locuteur ou de la locutrice, et ont amélioré les performances de modèles DNN-HMM [Saon 2013, Senior 2014]. De nouvelles architectures de DNN sont ensuite apparues. Les TDNN, introduits à la fin des années 80, ont refait surface et se sont installés dans les pratiques courantes grâce à leur utilisation dans l’outil Kaldi [Povey 2011]. Les RNN [Rumelhart 1986] se sont ensuite démocratisés pour les signaux de parole [Graves 2013], avec pour objectif d’en saisir la dynamique temporelle, puis les réseaux de neurones convolutionnels (Convolutional Neural Networks, CNN) [Abdel-Hamid 2014], initialement créés pour le traitement d’image [Lecun 1995] et permettant de modéliser une invariance temporelle.

Les DNN ont l’avantage, par rapport aux GMM, de modéliser des représentations plus complexes et non fixes grâce à leur capacité à apprendre. Ce sont de plus des modèles discriminants, qui offrent une meilleure distinction entre classes en étant entraînés à modéliser directement les probabilités postérieures et à minimiser l’erreur de reconnaissance.

Un des inconvénients majeurs des modèles fondés sur des HMM reste tout de même la complexité de la procédure d’entraînement. Il est tout d’abord souvent nécessaire de générer des alignements des transcriptions sur les fichiers audio, lorsque ceux-ci ne sont pas pré-alignés manuellement. Une étape de post-traitement, appelée le décodage, est ensuite nécessaire pour générer la séquence de sortie à partir des différents modules : modèle acoustique, dictionnaire de prononciation et modèle de langage. De plus, ces modules étant entraînés indépendamment des autres, il peut y avoir des décalages de comportement entre les différents modules.

Approches End-to-end

Les approches end-to-end représentent une part importante de cette thèse, et serons présentées en plus grand détail dans le chapitre 5. Nous ne présentons en conséquence dans cette section qu’un bref historique de l’apparition de ces modèles dans l’état de l’art de la reconnaissance automatique de la parole.

En réaction à la complexité d’entraînement des modèles hybrides DNN-HMM, les approches end-to-end ont été créées dans un objectif de simplicité. Premièrement, elles se débarrassent de la nécessité de pré-aligner les données avec un modèle supplémentaire, et donc d’entraîner ce modèle. Ensuite, elles visent à unifier le processus d’entraînement grâce à un modèle unique, évitant ainsi les éventuels décalages entre modules. Enfin, également dans un objectif de simplicité, les systèmes end-to-end ont introduit la possibilité d’agir au niveau du caractère plutôt que du phonème : cela élimine l’étape préliminaire de conversion des transcriptions textuelles en phonèmes, ainsi que l’étape de post-traitement visant à retrouver les mots à partir des phonèmes prédits.

Un premier pas vers la RAP end-to-end a été fait par [Graves 2006] avec la fonction CTC, dans le cadre de la reconnaissance de phonèmes sur le corpus TIMIT [Garofolo 1993b]. Leur modèle est composé d’un simple encodeur à base de couches RNN. Il utilise la fonction CTC pour apprendre l’alignement entre les informations acoustiques et les transcriptions phonétiques, puis pour prédire les séquences de phonèmes. Il obtient un taux d’erreur de phonème (Phoneme Error Rate, PER) de 30,5% sur TIMIT. Le système RNN-CTC est perfectionné dans [Graves 2014b], introduisant l’utilisation des caractères plutôt que des phonèmes, ainsi que l’insertion d’un modèle de langage au moment de l’inférence.

Les premières architectures constituées d’un encodeur et d’un décodeur, appelées sequenceto-sequence (seq2seq), ont été introduites dans le domaine de la traduction automatique neuronale [Sutskever 2014], puis ont rapidement été intégrées pour la reconnaissance automa-tique de la parole [Chorowski 2014, Lu 2015]. Dans un système seq2seq, l’encodeur a pour rôle d’extraire l’information acoustique des paramètres audio, et le décodeur, celui de prédire une séquence d’unités de parole (caractère ou phonème) à partir de l’information acoustique et des unités déjà prédites. Les deux modules sont généralement constitués de réseaux récurrents, particulièrement adaptés à la modélisation de la parole.

[Chorowski 2014] a ajouté le concept d’attention, précédemment présenté pour de la génération d’écriture manuscrite [Graves 2014a] puis pour de la traduction automatique neu-ronale [Bahdanau 2014], pour lier l’encodeur et le décodeur du modèle seq2seq. Ce mécanisme permet de chercher efficacement la portion d’information acoustique la plus pertinente pour la prédiction d’une unité de parole, étant donné celles déjà prédites. [Chan 2016] met également en avant un modèle seq2seq avec de l’attention, baptisé Listen, Attend and Spel l (LAS), qui est un des premiers modèles seq2seq à utiliser des caractères plutôt que des phonèmes. Évalué sur la tâche Google Voice Search, il obtient un taux d’erreur mot (Word Error Rate, WER) de 10,3%. [Chiu 2018] reprend le modèle LAS et ajoute quelques améliorations, comme l’utilisation de sous-mots (word pieces) formés de plusieurs graphèmes au lieu de graphèmes individuels, et de mécanismes d’attention à plusieurs têtes. Cela lui permet de diminuer le WER à 5,6% sur Google Voice Search. Les différentes têtes de ce mécanisme portent sur des projections linéaires de la séquence à traiter, dont les sorties sont ensuite concaténées pour former un unique vecteur d’attention.

En comparaison avec un système encodeur-décodeur sans attention, l’utilisation de celle-ci empêche un sur-apprentissage des transcriptions d’entraînement. L’avantage de l’attention par rapport à la fonction CTC est qu’elle ne suppose aucune condition d’indépendance entre symboles ou entre trames audio. L’inconvénient, en revanche, est que l’attention est trop flexible pour la reconnaissance de la parole : le signal de parole étant intrinsèquement séquentiel, l’attention peut faire des erreurs en se dispersant de façon non monotone sur toutes les trames du signal. Pour limiter cet inconvénient, [Chorowski 2015] présente un système à base d’attention améliorée, la contraignant à être plus attentive à la localisation des trames audio, et l’empêchant de se concentrer sur une unique trame. Cette technique d’attention permet de réduire le PER sur TIMIT de 18,7% à 17,6%. [Watanabe 2017] propose par ailleurs une architecture seq2seq combinant une fonction CTC et un mécanisme d’attention afin de tirer parti des avantages de chacune de ces méthodes. Ces deux paradigmes sont assemblés pendant l’entraînement grâce à une combinaison linéaire des fonctions de coûts associées, et pendant l’inférence par une moyenne pondérée entre leurs scores de prédiction. Les différentes sorties (CTC, attention et combinée) obtiennent, sur le jeu de test eval92 du corpus Wall Street Journal (WSJ) [Garofolo 1993a], des taux d’erreur caractère (Character Error Rate, CER) respectifs de 9,0%, 8,2% et 7,4%.

Les mécanismes d’attention se développent rapidement, et en viennent à remplacer les couches de RNN des encodeurs et décodeurs de systèmes seq2seq. [Vaswani 2017] présente pour la traduction automatique neuronale un système entièrement fondé sur de l’attention, nommé Transformer, et introduit ainsi les mécanismes d’auto-attention. Ces mécanismes ont le même fonctionnement que les mécanismes d’attention classiques, mais au lieu de chercher la correspondance entre informations acoustiques de l’encodeur et informations textuelles du décodeur, ils relient différentes positions d’une même séquence (acoustique ou textuelle) pour en extraire une représentation. Le modèle Transformer utilise des mécanismes d’attention multi-têtes pour améliorer la qualité et la diversité des représentations extraites. Le Transformer est bientôt adapté pour la RAP par [Dong 2018], obtenant un WER de 10,9% sur WSJ eval92 sans utiliser de modèle de langage. Les auteur·rice·s proposent en outre un système d’attention 2D à insérer avant l’encodeur pour extraire des représentations à partir des dépendances temporelles et spectrales d’un spectrogramme. Les modèles Transformer ont ensuite adopté l’architecture combinée CTC/attention [Karita 2019a], qui montre une meilleure précision (WER de 10,2% sur WSJ eval92) et une convergence plus rapide.

De par la grande diversité des modèles à l’état de l’art, et le développement extrême-ment rapide de nouvelles architectures, il peut être difficile de sélectionner l’approche la plus appropriée à une application. [Karita 2019b] fournit une étude comparative des approches hybrides (DNN-HMM), end-to-end type LAS et end-to-end type Transformer, sur une grande sélection de tâches de RAP. Leurs résultats indiquent que l’architecture Transformer sur-passe rigoureusement l’architecture LAS sur tous les jeux de données testés. Par exemple, le Transformer obtient un WER de 2,6% et 5,7% sur les jeux test_clean et test_other du corpus Librispeech [Panayotov 2015], contre 3,3% et 10,8% pour le LAS. L’approche hybride reste cependant significativement plus performante sur des données bruitées : elle obtient un WER de 11,4% sur le jeu de test et05_real du corpus CHIME4 [Barker 2017] (contre 14,5% pour le Transformer) et de 81,3% contre 87,1% sur le jeu de test kinect du corpus CHIME5 [Barker 2018]. Elle résiste également face au Transformer sur des jeux de données bien connus tels que WSJ (WER de 2,3% sur eval92, contre 4,4%).

Particularités de la parole d’enfants

De nombreux projets de recherche portent sur la caractérisation des différences entre la parole d’adultes et la parole d’enfants, tant sur le côté acoustique que phonologique. Des articles de revue fournissent des analyses sur la parole d’enfants : [Kent 1976] réunit les résultats d’un certain nombre d’études acoustiques et les lie au développement anatomique et neuro-musculaire des mécanismes de parole lors de la croissance de l’enfant. [Mugitani 2012] se concentre sur le développement du conduit vocal (depuis les plis vocaux jusqu’aux lèvres) et l’influence de son évolution sur les fréquences de la parole d’enfants. [Potamianos 2007] étudie les caractéristiques acoustiques et linguistiques de la parole d’enfants lorsqu’elle est lue ou spontanée.

Hauteur de la fréquence fondamentale et des formants

Très tôt ont été observées des différences dans la hauteur de la fréquence fondamentale et des formants, ainsi que dans leurs variabilités inter- et intra-locuteur·rice·s [Eguchi 1969, Kent 1976, Lee 1999]. Étude clé dans le domaine, [Eguchi 1969] se concentre sur trois caractéristiques de la parole : (1) la fréquence fondamentale f0, (2) les fréquences des premier et deuxième formants f1 et f2 des sons vocaliques, et (3) le délai d’établissement du voisement (paramètre temporel défini comme l’intervalle de temps entre le relâchement d’une plosive et la reprise du voisement). Son ouvrage montre tout d’abord que les fréquences f0, f1 et f2 des enfants entre 3 et 13 ans évoluent à la baisse avec l’âge.

Il a fallu attendre que les technologies radiographiques soient remplacées par d’autres comme le scanner ou l’imagerie par résonance magnétique (IRM), moins nocives pour le développement de l’enfant, pour pouvoir étudier l’anatomie de l’appareil de production de la parole chez l’enfant, et faire le lien entre son évolution pendant la croissance de l’enfant et l’abaissement des fréquences. Dans [Mugitani 2012], les auteur·rice ·s précisent que la forme et la longueur de ce canal définissent les caractéristiques acoustiques des expressions vocaliques d’une personne, notamment les fréquences f0, f1 et f2. La fréquence fondamentale f0 dépend de la longueur et du volume des plis vocaux [Hirano 1981], et les fréquences des premier et second formants (f1 et f2) diminuent avec l’agrandissement du conduit vocal [Kent 1992]. Les enfants présentent ainsi des fréquences plus élevées de par la plus petite taille de leur conduit vocal et de leurs plis vocaux, et ces caractéristiques évoluent jusqu’à atteindre un niveau adulte vers l’âge de 14-15 ans [Mugitani 2012, Lee 1997]. Les zones de production de chaque voyelle dans l’espace f1/f2 sont également décalées par rapport à celles des adultes. Ce décalage est cependant différent pour chaque voyelle à cause du développement non linéaire de la cavité vocale, dont la forme influence la formation des voyelles [Lee 1997]. Cela implique un espace vocalique et une gamme de fréquences plus larges que pour les adultes.

Mécanismes d’articulation non stables

[Eguchi 1969] étudie de plus les déviations standards des fréquences f0, f1 et f2, qui révèlent une diminution uniforme des variabilités intra-locuteur·rice entre 3 et 11 ans. Concernant le délai d’établissement du voisement, une forte variabilité intra-locuteur·rice est également observée chez les jeunes enfants, et décroît graduellement entre 3 et 8 ans. D’après [Kent 1976], les trois caractéristiques étudiées par [Eguchi 1969] sont chacune liées à des mécanismes de production de la parole : (1) l’ajustement du larynx, (2) la position des articulateurs pour la production de voyelles et (3) la coordination articulatoire-laryngienne. L’ensemble des tendances de variabilité intra-locuteur·rice observées corrobore ainsi une amélioration du contrôle moteur des mécanismes de parole entre l’âge de 3 et 11 ans.

[Lee 1999] confirme ces observations, et présente additionnellement des études sur l’évo-lution des durées de segments de parole (voyelles, consonne fricative [s], phrase), qui di-minuent globalement avec l’âge. Dans la totalité de leurs études, les variabilités inter- et intra-locuteur·rice chutent drastiquement entre 8 à 12 ans (selon le paramètre étudié), révélant de fortes variabilités pour les jeunes enfants de 5 à 8 ans. La diminution de la durée segmentale pouvant être reliée à une amélioration de la vitesse d’articulation, les auteur·rice ·s suggèrent que le contrôle des mécanismes d’articulation ne se rapproche de la précision d’un adulte qu’à partir de 8-9 ans. Ces conclusions rejoignent celles de l’étude de [Kent 1980] portant sur les durées des segments de parole d’enfants de 4, 6 et 12 ans récitant des phrases, ainsi que celles de [Lee 1997], qui estime que le niveau adulte est atteint un peu plus tard, vers 11 ans. Sur la base d’études similaires, [Smith 1978] nuance néanmoins les différences entre enfant et adulte, arguant que le système de production de la parole d’un jeune enfant est plus sophistiqué qu’on ne le croit.

Faible capacité de co-articulation

Dans [Lee 1997], une analyse de la variabilité spectrale entre la première moitié et la seconde moitié d’une voyelle révèle d’importantes valeurs pour les enfants de moins de 10 ans, qui sont probablement dûes à des mouvements abrupts de la langue lors de la transition entre la voyelle et la consonne suivante : cela suggère une capacité de co-articulation encore faible chez les jeunes enfants. [Sereno 1985] proposait déjà l’idée que les enfants de 3 à 7 ans présentaient une co-articulation moins précise et plus variable que celle des adultes, et n’étaient pas encore capables d’anticiper la co-articulation entre consonnes et voyelles. Plus récemment, [Gerosa 2006b] étudie les transitions consonne-voyelle et la différence spectrale entre la consonne et la voyelle d’une paire. Ses résultats indiquent que l’effet de la co-articulation est moins marqué chez les jeunes enfants, et que le risque de confusion entre différents phonèmes émis par des enfants est plus grand, de par la faible différence spectrale entre leurs productions de différents phones.

Qualité linguistique et prosodique dégradée

Le lent développement des mécanismes d’articulation peut causer des variantes linguis-tiques et de prononciation chez les jeunes enfants. D’après [Fringi 2015], qui cite [Lust 2006] et [Cohen 2011], un positionnement non précis des lèvres et de la langue lorsque l’enfant apprend à parler peut entraîner des omissions ou substitutions de phonèmes, qui ont tendance à disparaître avec l’âge, mais peuvent persister jusqu’à l’âge de 6 ans.

Sur de la parole lue, [Lee 1999] relève une décroissance de la durée pour lire une phrase entre 7 et 14 ans, avec une diminution totale de la durée de 45%. Cette mesure est liée au taux de parole (ratio entre le nombre de mots émis par l’enfant et le temps de parole), mais dépend également de la capacité de lecture de l’enfant. Sur de la parole spontanée dans le cadre d’une interaction avec un ordinateur, [Potamianos 1998] trouve également que le taux de parole d’enfants de 11 à 14 ans est 10% plus élevé que celui d’enfants plus jeunes.

[Lee 1999] identifie de plus une présence importante de disfluences (suppression de pho-nèmes, mauvaises prononciations) chez les enfants de 5-6 ans, mais qui ne sont pas nécessai-rement causées par de faibles capacités de lecture, puisque les enfants non lecteurs devaient répéter les phrases plutôt que les lire. Sur de la parole spontanée d’enfants légèrement plus âgés (8-10 ans), [Potamianos 1998] observe une fréquence d’occurrence de fautes de prononciation deux fois plus élevée que chez les 11-14 ans, ainsi que 60% plus de bruits de respiration.

Reconnaissance automatique de la parole d’enfants

Dans le cadre de sa thèse, et de la collecte du corpus de lecture orale LetsRead auprès de jeunes enfants AL portugais, [Proença 2018] analyse les différents types d’erreurs de lecture et disfluences, et leur fréquence d’occurrence en fonction de l’âge des enfants. Les données qu’il récolte auprès d’enfants de 6 à 9 ans (du CP au CM1) sont constituées de phrases et de pseudo-mots, qui sont des mots non-existants créés spécialement pour évaluer la conscience phonémique des enfants en éliminant la possibilité que l’enfant connaisse le mot par cœur. Le pourcentage total d’erreurs est de 18,3% sur les phrases, et de 74,1% sur les pseudo-mots, qui représentent une tâche de lecture bien plus difficile. Le nombre d’erreurs de fluence et de déchiffrage diminue évidemment avec l’âge : sur les phrases, les élèves de CP du jeu de données ont lu 33,4% des mots avec une erreur, ceux de CE1 19,4%, et ceux de CE2 et CM1 16,4% et 12,3%. Les erreurs de déchiffrage les plus fréquentes des élèves de CP et CE1, qui nous intéressent dans cette thèse, sont les faux départs (par exemple, pour le mot « pouce » [pus], l’enfant lit [pu…pus]), les substitutions de mots (« pouce » substitué par « pause » [poz]), les substitutions de phonème ([pas]) et les répétitions de mots ([pus…pus]). Les élèves de CP et CE1 ont de plus tendance à lire plus lentement, à faire plus de pauses intra-mot et d’extensions de phones, tandis que les enfants un peu plus âgés (CE2-CM1) tendent à insérer ou supprimer des phonèmes ou mots à cause d’une lecture trop rapide.

Il convient enfin de signaler que certains types d’erreurs faites par les enfants AL peuvent s’apparenter à des évènements présents dans d’autres types de parole atypique :

— parole pathologique : par exemple, le bégaiement se révèle par des répétitions de mots (entiers ou partiels) et des allongements de phones [Ellis 2009], et certains types d’apha-sie, un trouble neurologique du langage, impliquent des substitutions de mots ou des confusions de phonèmes [Alexander 2008] ;

— parole d’apprenant·e de seconde langue (L2) : parmi les « déviances » d’apprenant·e·s L2 identifiées par [Detey 2016], les déviances segmentales (insertions, suppressions, substitutions de phonèmes) et supra-segmentales (liées au rythme et à l’intonation) ressemblent notamment aux erreurs de déchiffrage et de fluence trouvées dans la parole d’enfants AL. Les évènements liés à l’accent et à la distorsion de certains phones ne se retrouvent cependant pas dans notre type de parole.

Avec l’essor des systèmes fondés sur la reconnaissance vocale et leur intégration dans notre vie quotidienne, les enfants deviennent de plus en plus usagers de ces technologies. Le domaine de la RAP pour voix d’enfants s’est donc développé graduellement depuis une trentaine d’années, et gagne en visibilité depuis quelques années seulement.

Jeux de données de parole d’enfants

Le domaine de recherche étant relativement nouveau, les données de parole d’enfants sont encore rares. En langue française, aucun jeu de données n’est actuellement disponible publiquement : dans cette thèse, nous utiliserons un petit corpus de données récoltées par nos soins, comme nous le décrirons dans le chapitre 4.

[Claus 2013] établit une liste exhaustive des jeux de données existants dans différentes langues et contenant la parole d’enfants d’âges divers. Nous présentons ici les quelques jeux de données de parole d’enfants en langue anglaise sur lesquels s’appuient la plupart des systèmes à l’état de l’art en reconnaissance automatique de la parole d’enfants, que nous décrirons dans la section suivante. Le tableau 2.1 présente des informations générales sur ces jeux de données. Nous voyons que les jeux de données sont extrêmement diversifiés en termes de type de parole, du nombre et de l’âge des locuteur·rice·s, et de la quantité de données. De plus, certains corpus ne sont annotés qu’en partie et ne sont donc pas exploités entièrement actuellement.

|

Table des matières

I Contexte de la thèse et état de l’art

1 Lalilo, et les enfants apprenantes le cteurrices

1.1 Présentation de Lalilo

1.1.1 Lalilo, l’entreprise

1.1.2 Lalilo, le produit

1.2 L’oralisation pour l’apprentissage de la lecture

1.2.1 Importance de l’oralisation pour l’enfant

1.2.2 Pratiques de lecture orale en classe

1.3 La reconnaissance vocale pour l’apprentissage de la lecture

1.3.1 Utilité de la reconnaissance vocale pour la lecture orale en classe

1.3.2 L’exercice de lecture orale de Lalilo

1.4 Bilan

2 État de l’art : reconnaissance automatique de la parole d’enfants

2.1 Reconnaissance automatique de la parole

2.1.1 Modèles acoustiques génératifs GMM-HMM

2.1.2 Modèles acoustiques hybrides DNN-HMM

2.1.3 Approches End-to-end

2.2 Particularités de la parole d’enfants

2.2.1 Hauteur de la fréquence fondamentale et des formants

2.2.2 Mécanismes d’articulation non stables

2.2.3 Faible capacité de co-articulation

2.2.4 Qualité linguistique et prosodique dégradée

2.3 Reconnaissance automatique de la parole d’enfants

2.3.1 Jeux de données de parole d’enfants

2.3.2 Systèmes existants

2.4 Bilan

II Établissement du modèle de référence pour la reconnaissance de phonèmes sur parole d’enfant

3 Système de référence : paramètres et modèles

3.1 Paramètres acoustiques

3.1.1 Paramètres fondés sur du traitement du signal

3.1.2 Paramètres extraits par des modèles auto-supervisés

3.1.3 Méthodes d’adaptation des paramètres

3.2 Gestion du manque de données

3.2.1 Apprentissage par transfert

3.2.2 Augmentation de données avec bruit de brouhaha

3.3 Architecture du système de référence

3.3.1 Architecture du TDNNF

3.3.2 Paramètres et entraînement du TDNNF-HMM

3.3.3 Décodage avec le TDNNF-HMM

3.4 Bilan

4 Système de référence : résultats et analyses

4.1 Présentation des données de parole

4.1.1 Données de parole d’adultes : Common Voice

4.1.2 Données de parole d’enfants : Lalilo

4.2 Métriques d’évaluation

4.3 Expériences et évaluations

4.3.1 Comparaison des modèles TDNN-HMM et TDNNF-HMM

4.3.2 Choix des paramètres audio

4.3.3 Évaluation de la méthode d’apprentissage par transfert

4.3.4 Évaluation de la méthode VTLN

4.3.5 Évaluation de la méthode d’augmentation de données avec bruit

4.4 Bilan

III Modélisation acoustique end-to-end et améliorations

5 Méthodes et architectures de nos modèles end-to-end

5.1 Méthodes choisies pour la transcription en phonèmes de parole d’enfant

5.1.1 Réseaux de neurones récurrents

5.1.2 La fonction CTC

5.1.3 Les mécanismes d’attention

5.2 Méthodes d’inférence

5.2.1 Greedy search, ou recherche gloutonne

5.2.2 Beam search, ou recherche en faisceau

5.3 Modèles acoustiques end-to-end mises en place pour la parole d’enfant

5.3.1 RNN-CTC

5.3.2 Listen, Attend and Spell

5.3.3 Listen, Attend and Spell + CTC

5.3.4 Transformer

5.3.5 Transformer + CTC

5.4 Bilan

6 Modélisation acoustique end-to-end : résultats et analyses

6.1 Présentation du corpus Lalil-o-fficiel

6.2 Comparaison des modèles hybrides et end-to-end

6.2.1 Comparaison sur la parole d’adultes

6.2.2 Comparaison sur la parole d’enfants

6.3 Analyses détaillées des performances pour notre application Lalilo

6.3.1 Application aux tâches de lecture de Lalilo : mots isolés et phrases

6.3.2 Influence des particularités de la lecture d’AL

6.4 Bilan

7 Amélioration de la robustesse aux erreurs de lecture et au bruit

7.1 Augmentation par ajout de bruit de brouhaha

7.2 Augmentation par simulation d’erreurs de lecture

7.2.1 Méthodes de simulation d’erreurs

7.2.2 Expériences et évaluation globale

7.2.3 Évaluation de la robustesse aux erreurs de lecture

7.3 Augmentations combinées

7.4 Bilan

Conclusion

A Quelques histoires pour la première collecte auprès des familles

B Documents officiels pour la collecte de parole d’enfant en école

C Format des annotations en base de données 1

D Algorithme progressif-rétroprogressif CTC

Bibliographie

Télécharger le rapport complet