Télécharger le fichier pdf d’un mémoire de fin d’études

La typologie de la data dans les différents secteurs culturels

Introduction

L’usage des données dans les industries culturelles (musique en ligne, vidéos à la demande, livre numérique et jeux vidéo) prend plusieurs formes, afin de configurer la création en fonction des besoins et goûts supposés des consommateurs.

Les industries culturelles et de contenu produisent et gèrent des données, qui interviennent à toutes les étapes de la production et de la diffusion des contenus, grâce à des outils et des techniques nourris par de larges corpus de données.

Les données structurées et non structurées

Plusieurs contenus ont été publiés sur le web. Outre les informations scientifiques, se sont développés des contenus journalistiques, fictionnels, musicaux ou encore audiovisuels, selon des modalités extrêmement diverses19.

Les données structurées concernent des données structurées sémantiquement comme une notice bibliographique qui recense les informations, telles que les auteurs, le titre, la date de publication, le contenu d’une œuvre décrite en mots clés. Une œuvre elle-même peut désormais être considérée comme une donnée structurée quand elle est encodée dans un langage de type XML structurant le contenu en différents zones.

Au contraire les données non-structurées sont assimilables à des données de flux, qui se renouvellent rapidement, elles sont générées souvent par des interactions ou des capteurs, elles ne subissent pas de traitements sémantiques pensées en amont par l’homme ; par leur volume, elles sont donc assimilables à du big data. Les processus dynamiques de partages entre internautes génèrent aussi un flot de données non structurées qui portent de nouvelles valeurs exploitables dans des services inédits à grande échelle.

Caractéristiques des données structurées :

Elles permettent d’ajouter des informations sémantiques qui aident notamment les robots à mieux comprendre les contenus culturels ;

Nécessitent des traitements préalables à leur usage : tri, indexation et résumé etc. ;

Elles proviennent désormais tant des bases de données internes qu’externes ;

Les valeurs de ces données sont déterminées et connues à l’avance ;

Les données sont stockées de manière organisée, facilement compréhensibles et repérables.

Nous ne pouvons pas parler de big data au sens originel du terme pour ce type de données.

Caractéristiques des données non structurées :

Elles proviennent majoritaires d’interactions, de transactions continues, de capteurs, d’échanges entre internautes, à des échelles de masses critiques importantes ;

Une valorisation majeure concerne l’alimentation par ces données d’ algorithmes de prédiction et de recommandation personnelles provenant des traces numériques ;

La personnalisation est un enjeu principal : proposition de contenus adaptés aux goûts et aux habitudes de chacun (playlists de Deezer ou Spotify, recommandations personnalisées de vidéos pour Netflix) ;

Dans les jeux vidéo, les données incitent à acheter d’autres jeux, mais aussi à adapter le jeu en fonction des difficultés rencontrées par les joueurs ou des niveaux qu’ils apprécient (comme pour Steam) ;

Pour les livres, les données d’usage aident notamment à mesurer le temps passé à lire le livre en relevant les passages les plus lus (c’est l’exemple d’Amazon qui arrive de la sorte à anticiper le potentiel de vente de certains ouvrages).

Ces données non structurées sont à considérer comme du big data 20 : citons par exemple l’émergence d’environnements immersifs qui déploient l’adaptation et la personnalisation des contenus culturels en temps réel par le biais des capteurs corporels (rendant compte de l’humeur, du degré du stress, des mouvements cardiaques de l’utilisateur etc.) pour ainsi proposer les contenus adaptés ou en concevoir de nouveaux plus innovants. Ces données de flux sont organisées en bases de données NoSQL (comme MongoDB, Cassandra ou Redis) qui implémentent des systèmes de stockage considérés comme plus performants que le traditionnel SQL pour l’analyse de données de masse (orienté clé/valeur, document, colonne ou graphe).

Data et les médias

La révolution digitale n’est pas uniquement le résultat du développement des infrastructures technologiques, mais elle concerne également la gouvernance et la valorisation des données au cœur de la convergence de plusieurs secteurs d’activité économique.

Les acteurs économiques s’intéressent aux données produites par leurs activités, pour tenter de mieux comprendre la valeur qu’ils apportent à leur écosystème. Chaque acteur doit maîtriser les bonnes pratiques du management des données structurées et non structurées associées à leurs activités opérationnelles ; les acteurs des industries culturelles, a fortiori, sont confrontés à de réels enjeux liés à l’exploitation et la valorisation de leurs données.

Toutefois, le manque de compétences techniques et une gouvernance de l’information en silos entravent souvent les initiatives initiées21.

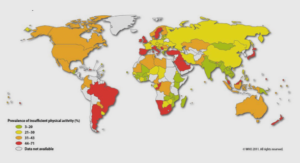

Dans la 15ème édition de l’étude annuelle « Global Entertainment & Media Outlook », sur les perspectives de l’industrie des médias et des loisirs, PwC prévoyait une croissance de 5 % en moyenne par an entre 2013 et 2018. Les dépenses totales du marché sur le numérique (excluant l’accès à l’internet) progresseraient de 12,2% en moyenne par an entre 2013 et 2018 et représenter 65% de la croissance du marché. La publicité tient le haut du pavé et concerne directement l’exploitation des données. En 2018, 33% des revenus publicitaires mondiaux seraient digitaux, à comparer aux 17% des revenus consommateurs.

Les médias gèrent aujourd’hui une masse importante de données disponibles liées à leur audience, levier important de la compétitivité des entreprises. Le secteur des médias constitue également un terrain propice au développement de projets liés aux données, à cause de la multiplication des vecteurs de diffusion-réception connectés à internet (TV connectée, Set top box, mobile, web, tablette, objet connecté, etc…), le volume de données lié à cette consommation diversifiée ne cesse de croître.

Sur un autre registre, l’avènement du big data a révolutionné encore cette corrélation de la donnée et l’optimisation des services fournis au public, en jouant deux cartes principales :

Le contenu personnalisé :

L’accumulation des données importantes sur les consommateurs (intérêts, âge, genre…) déployées pour prédire et anticiper les comportements, pour ne faire acheminer à l’utilisateur que le produit adéquat, au bon moment au bon endroit.

Prenons un exemple, Netflix a produit la série « House of Cards » en fonction des goûts et centres d’intérêts de ses utilisateurs. Alors que le Huffington Post améliore l’expérience utilisateur de son site web moyennant le big data acquis et traité en temps réel.

L’Equipe fournit des offres sur mesure aux clients en utilisant des données sur les usages digitaux des consommateurs de la marque (abonnés et visiteurs gratuits). L’idée est de mieux vendre les produits existants (comme le papier, premier quotidien français) et d’innover.

La publicité ultra-ciblée :

Dans une logique de RTB (Real Time Bidding). Le big data permet de repérer les types de profils qui regardent quels programmes et quelles rubriques et ainsi ajuster les publicités. Ainsi si deux profils différents suivent un même programme, ils ne visionneront pas les mêmes spots publicitaires.

Ainsi, le projet lancé par le groupe Figaro vise à optimiser la vente de ses abonnements, avec une forte dimension publicitaire. A partir des recueils de données, il s’agit d’accompagner les annonceurs sur la connaissance client grâce au trafic généré.

Le digital représente une part grandissante dans les revenus des groupes de presse (50 % du CA pour le Figaro, environ 40 % pour l’Equipe)22. La publicité en ligne permet aux sites de gagner de l’argent et de diffuser des contenus gratuits et ceci grâce à la valorisation des données.

Les groupes de presse procèdent à l’analyse de leur lectorat sur la base des données relatives à la catégorisation socioprofessionnelle, ils achètent des données affinitaires et comportementales anonymes de plusieurs fournisseurs de données comme Google et Facebook23.

Renouvellement de pratiques professionnelles : le data journalisme

Le data journalisme s’est affirmé ces dernières années comme une nouvelle pratique professionnelle mobilisant des compétences informatiques : « S’il y a une révolution de toute façon elle ne vient pas de nous, journalistes, mais des pouvoirs publics qui pour leurs propres raisons mettent à disposition de plus en plus de données publiques. Grâce aux outils fournis par l’informatique, on peut beaucoup plus facilement transformer ces données et produire des nouveaux contenus » (entretien avec un data journaliste pour un média pureplayer, 21 février 2017)24.

En utilisant la data dans la presse, une nouvelle organisation des salles de rédaction a progressivement émergé. L’intégration de ces nouvelles sources d’information nécessite la maîtrise de processus d’identification, de collecte et de filtrage des données, de mise en forme et de restitution sous forme de data-visualisations et de scénarisations. Cette rencontre de la data avec la presse a donné naissance à de nouvelles pratiques axées sur trois niveaux de compétences : journaliste-designer-développeur (figure 5) 25.

L’exploitation des données dans le travail quotidien d’un data journaliste prend la forme d’une chaîne de traitement, qui consiste à récupérer et à intégrer les données, procéder à leur préparation et à leur nettoyage, puis les analyser pour les interpréter d’un ou de plusieurs points de vue possibles (calculs statistiques, croisement avec d’autres jeux de données, recherche de corrélations et visualisations intermédiaires). Dans la pratique, la préparation des données requiert notamment un recoupement des sources et des entretiens avec les spécialistes pour pouvoir statuer sur la pertinence des données d’entrée. Cette phase est chronophage. La créativité des data journalistes renvoie ensuite à leur capacité à créer des liens entre les données, à les croiser et identifier des relations originales qui n’étaient pas explicites auparavant.

La restitution revêt plusieurs formes allant de l’éditorial à la visualisation, en passant par les applications web. Néanmoins, la touche artistique et esthétique est sollicitée pour rendre ces données intelligibles et exploitables. De ce fait, les visualisations permettent des économies de temps par rapport à la lecture d’un article. De même, la personnalisation de la forme et du contenu au profil et au contexte de l’utilisateur peut être une orientation possible26.

Les deux quotidiens de référence, précurseurs en matière de data-journalisme, sont The New York Times (USA) et The Guardian (GB), qui ont constitué des équipes réunissant cette triple compétence27.

Data pour les médias : opportunité et défi

La data dans le secteur de la presse a permis à des groupes de coupler l’interactivité au journalisme d’analyse et d’investigation. A titre d’illustration, The Guardian a constaté que ses enquêtes du data-journalisme étaient les plus lues et sur lesquelles les lecteurs passaient le plus de temps en ayant la possibilité de télécharger des données brutes et d’interagir avec le media, ce qui contribue parallèlement à attirer les annonceurs et à générer de nouveaux revenus publicitaires28.

Dans cette tendance, les groupes médias deviendraient des spécialistes de l’exploitation de données à la fois à travers le data-journalisme, mais également par la mise à disposition de données brutes (data store) ou la vente de data-visualisations et d’applications pour des entreprises ou des collectivités (figure 6) 29.

Figure 6: Le nouveau business modèle de la presse à l’ère de la data (CULTURE RP, 2013)

Dans ce business modèle, les médias collectent les données des différentes sources, de l’open data, ou les recueillent à partir des investigations particulières, pour les rendre accessibles aux utilisateurs finaux, aux développeurs ou organisations intéressés par la data.

Coté défi, la nature des actions mises en œuvre ou non par les acteurs des médias et de la presse conditionne la diffusion et la qualité de l’information accessible aux citoyens. A titre d’illustration, la circulation de l’information durant la campagne électorale présidentielle de 2016 aux États-Unis a été entachée par la désinformation sur les réseaux sociaux, un phénomène auquel nous n’échappons pas.

En pratique, la nouvelle forme d’investigation et d’exploitation de données dans les médias, permet de simplifier l’information et produire du sens, en vue de de faciliter l’analyse des sujets complexes avec un maximum de recul, de recoupement et de vérification de l’information, pour contourner le risque de désinformation au moyen du croisement entre le travail de recueil et de traitement des données et le travail journalistique.

L’usage de la data dans les médias s’intègre dans une logique de précision et d’exactitude, puisqu’il s’agit d’une analyse de données conditionnée par le récit à établir, ce qui prémunit les lecteurs du biais de l’absence de fiabilité de l’information.

En résumé, l’accessibilité des données doit être corrélée à l’œil critique éditorial du « quatrième pouvoir », pour tirer bénéfice des potentialités des données, mais dans un cadre plus éthique. De menace à ressource, concilier la disponibilité des données avec l’interaction des publics, requiert l’analyse de données dans leur processus de production et de diffusion du contenu journalistique en relation avec la mission du média.

Data dans le secteur de l’édition

Le secteur de l’édition est caractérisé par l’importance des métadonnées, à la fois pour le commerce du livre et pour l’accessibilité et la circulation dans les bibliothèques. Le contexte numérique a renouvelé les standards de ces métadonnées. En France, par exemple, le Syndicat national de l’Edition anime un groupe de travail expert sur ces questions en lien avec les acteurs internationaux30.

La CLIL (La Commission de Liaison Interprofessionnelle du Livre) a procédé à la normalisation des données nécessaires à la description et la commercialisation des livres, pour en extraire des métadonnées riches, circulant dans des formats compréhensibles, utilisant les normes et les schémas ci-après : ISBN (International Standard Book Number) Numéro international normalisé permettant l’identification d’un livre dans une édition donnée sur tout support ;

DublinCore : un schéma générique de métadonnées, destiné à la description des ressources numériques à travers quinze champs de métadonnées relatifs au contenu, à la propriété intellectuelle et à « l’instanciation » : titre, créateur, éditeur, sujet, description, source, langue, relation, couverture, date, type, format, identificateur, collaborateur et droits ;

Norme ONIX 3.0 : il s’agit d’une norme permettant l’échange et l’interopérabilité des fichiers de métadonnées relatifs aux livres physiques et numériques ;

Classification Thèmes CLIL (France) et THEMA (internationale) : c’est une classification thématique du livre physique, visant à structurer une grande librairie générale31.

La convergence avec les métadonnées élaborées avec les SID est accélérée par le numérique mais certains référentiels restent encore différents, ancrés dans des pratiques professionnelles respectives32.

Nous allons insister désormais sur les données non structurées et massives qui renouvellent actuellement le secteur de l’édition même si tous les éditeurs ne s’y investissent pas encore.

Les données comportementales des lecteurs sont devenues de nouveaux enjeux :

Plus précisément, les livres ont le défi de capter les attentes des consommateurs, avec une expérience personnalisée, ciblée et interactive. Pour y parvenir, il est possible de récupérer des données sur les divers aspects de l’engagement du lecteur avec les livres (données pertinentes provenant des réseaux sociaux, des capteurs d’internet des objets et des recherches Google etc.), et de mobiliser des outils analytiques comme Google Analytics et Shopify33.

Au niveau de la capture des engagements des utilisateurs, la nature des données produites autour de l’objet « livre » dans le monde de l’édition concerne les avis, les notes et commentaires recueillis par les plateformes de vente ou les réseaux sociaux, le temps passé sur un livre. Un livre peu acheté mais lu rapidement en entier laisserait supposer que les lecteurs ont apprécié celui-ci malgré, peut-être, un manque de mise en avant par l’éditeur.

Les données liées au comportement de lecture peuvent être approfondies : durée de lecture, pourcentage d’un livre lu et passages les plus marquants ouvrent la voie à la personnalisation et à la recommandation personnalisée. Aujourd’hui, des plateformes de streaming telles que Youboox recueillent des millions d’informations sur les habitudes de lecture et peuvent les partager avec l’industrie du livre pour en faire un atout.

En matière d’optimisation du marketing éditorial, les données sur le temps utilisé pour la lecture et les chiffres de vente d’un livre déterminent les futurs best-sellers et les éditeurs peuvent grâce ces données anticiper le succès d’une série. Si le tome 2 n’est terminé que par 50 % des lecteurs contre 90 % pour le premier, cela pourrait remettre en cause une suite possible. De la même façon, un livre peu sélectionné, mais souvent toujours terminé par le lecteur peut questionner l’adéquation de sa couverture qui ne semblerait pas inciter les lecteurs à le découvrir. Le big data peut ainsi optimiser le marketing des éditeurs à travers l’analyse du comportement des lecteurs, aboutissant à la création de designs de couverture attractifs pour augmenter les ventes34.

Nous allons évoquer désormais deux exemples d’usages des données dans le secteur du livre dans une vision d’aide à la décision mobilisant des algorithmes d’intelligence artificielle.

Le rapport de stage ou le pfe est un document d’analyse, de synthèse et d’évaluation de votre apprentissage, c’est pour cela chatpfe.com propose le téléchargement des modèles complet de projet de fin d’étude, rapport de stage, mémoire, pfe, thèse, pour connaître la méthodologie à avoir et savoir comment construire les parties d’un projet de fin d’étude.

|

Table des matières

Introduction générale

I. Problématique de recherche : objectifs et questions de recherche

II. Les méthodes, cadre conceptuel et contraintes de recherche

III. La structure de la thèse

Partie I : La data dans les industries culturelles : analyse comparative de points saillants

Chapitre 1 : Les transformations liées aux données dans les industries culturelles

Introduction

1. Industries culturelles et nouveaux enjeux

2. Numérique, données et économie de la culture

Chapitre 2 : La typologie de la Data dans les différents secteurs culturels

Introduction

1. Les données structurées et non structurées

2. Data et les médias

3. Renouvellement de pratiques professionnelles : le data journalisme

4. Data pour les médias : opportunité et défi

5. Data dans le secteur de l’édition

6. Data dans le secteur de la musique

7. Data dans le secteur du E-Learning

8. Synthèse sur l’usage de la Data dans les industries culturelles

9. Les freins de l’exploitation de la data dans les industries culturelles

Conclusion

Partie II : Data et les SID

Chapitre 1 : Croissance des données dans les SID et diversification des services associés

Introduction

1. Typologie des données dans les SID

2. L’exemple d’Online Computer Library Center OCLC) : évolution des services de la Data

3. La mise en place d’un projet de Linked Open Data (LOD)

4. De meilleures possibilités de recherche

5. Les catalogues documentaires augmentés

6. La visualisation des données d’activités du SID : l’exemple du projet « Prévu »

Conclusion sur la croissance des données du SID

Chapitre 2 : Le Big data dans les SID

Introduction

1. Le big data : dimensions et infrastructure

2. Pouvons-nous parler de big data dans les SID ?

3. Le développement du data mining dans les SID

4. L’impact du big data sur l’évolution des compétences des professionnels des SID

Conclusion

Partie III : Les systèmes de recommandation et leur développement

Chapitre 1 : La modélisation des systèmes de recommandation, introduction

Chapitre 2 : Les approches de recommandation

Introduction

1. L’approche objet ou basée sur le contenu (Content-Based Filtering)

2. L’approche de la recommandation sociale ou de filtrage collaboratif (Collaborative Filtering)

3. L’approche de la recommandation hybride (Hybrid Filtering)

4. Autres approches de recommandation

Conclusion

Chapitre 3 : Les algorithmes de recommandation

Introduction

1. L’apprentissage automatique

2. Les algorithmes de recommandation à base de contenu

3. L’algorithme de filtrage collaboratif à base de mémoire

4. L’algorithme de filtrage collaboratif à base de modèle

Conclusion

Partie IV : Etude de cas : conception et modélisation d’un SR pour le catalogue de l’IMIST

Chapitre 1 : Présentation de l’IMIST, de son offre et de ses services documentaires

Introduction

1. Présentation du contexte et du corpus d’étude

2. Le système documentaire actuel de l’Institut Marocain de l’Information Scientifique et Technique

3. Le système intégré de gestion de bibliothèque au sein de l’IMIST

Conclusion

Chapitre 2 : La donnée et l’enjeu de sa valorisation

Introduction

1. Exploitation actuelle de la donnée : une enquête générale sur l’usage des données à l’IMIST

2. Vers une personnalisation des catalogues en utilisant les données

3. Les besoins formulés

4. L’objectif de la solution envisagée

5. Vers la modélisation d’un système de recommandation appliqué aux services d’information

documentaire : constats et orientations

Conclusion

Chapitre 3 : Conception et modélisation

Introduction

1. Le corpus de l’IMIST : les utilisateurs et leurs données

2. La classification supervisée du corpus

3. La « non pertinence » des résultats sur le catalogue en ligne

4. Vers un modèle de système de recommandation appliqué aux services d’information documentaires (SID)

5. L’architecture fonctionnelle du modèle proposé

6. L’extraction de fichiers logs (Input)

7. La transformation des données implicites en données explicites (traitement)

8. Le chargement de données

9. Le nettoyage de données (traitement)

10. La définition des plages de notes (traitement)

11. Le stockage sous le format final

12. Le scénario de recommandation

13. Les objectifs du modèle de recommandation proposé

14. La description des acteurs intervenant dans le modèle proposé

Conclusion

Chapitre 4 : La mise en oeuvre du prototype du système de recommandation

Introduction

1. L’architecture technique du système

2. Un aperçu sur Spark

3. La mise en place du prototype du système de recommandation

4. Le cas de l’utilisateur authentifié

5. Le cas de l’utilisateur anonyme

Conclusion

Chapitre 5 : Evaluation du prototype de SR proposé

Introduction

1. L’évaluation hors ligne : le calcul des fonctions d’erreur (RMSE, MSE)

2. Le calcul du temps d’exécution du programme

3. L’évaluation en ligne implicite

4. L’évaluation explicite des utilisateurs par un questionnaire

Conclusion

Limites du modèle et prototype proposés

Conclusion générale et perspectives

Publications relatives à la thèse

Annexes

Annexe 1 Questionnaire sur l’usage de la data dans l’offre documentaire destinée aux chercheurs a

l’IMIST

Annexe 2 mini- questionnaire sur la satisfaction d’un échantillon des utilisateurs du prototype de

recommandation

Télécharger le rapport complet