Télécharger le fichier pdf d’un mémoire de fin d’études

Les modèles de mélange gaussien

Dans cette section, nous présentons notre premier classifieur, à savoir le GMM soustractif. Issu de la référence de la tâche 3 du challenge DCASE 2016 [128], il consiste à apprendre un modèle pour détecter la présence et un autre pour détecter l’absence de chaque classe. Il s’agit par ailleurs d’une méthode très prisée avant l’avènement des réseaux de neurones [130]. Comme expliqué dans la section 2.3.2, on l’utilise avec un vecteur d’entrée comprenant 20 MFCC auxquels on enlève le premier, 20 ∆MFCC et 20 ∆2MFCC. Cette section vise à reproduire etétudier superficiellement ce classifieur afin de s’assurer de la justesse de son comportement par rapport à l’état de l’art, avant d’en analyser l’implémentation sur système embarqué dans le chapitre 5.

On commencera par exposer le fonctionnement précis de ce GMM soustractif. Ensuite, on l’implémentera et on vérifiera son bon fonctionnement. Enfin, on étudiera le comportement duGMM soustractif face à différents paramètres qui influent sur la complexité de la phase de test du système.

Fonctionnement théorique d’un modèle de mélange gaussien soustractif

Pour construire un GMM, on suppose que les descripteurs de chaque classe suivent un mélange d’une ou plusieurs lois gaussiennes. Ainsi, chacune des C classes va être représentée indépendamment par un mélange de variables suivant chacune une loi normale multi-dimensionnelle, c’est-à-dire ayant une densité de probabilité pour chacune des nc gaussiennes : f(x; µk, Σk) = 1 (2π) N/2det(Σk) 1/2 exp − 1 2 (x − µk) ⊤Σ −1 k (x − µk) (2.10)

N avec N la dimension (ici la longueur du vecteur des descripteurs), µk ∈ R

N le vecteur moyenne de la ke gaussienne et Σk ∈ MN (R) sa matrice de covariance définie positive. Pour cela, comme on l’observe sur la figure 2.7 qui résume le fonctionnement du GMM soustractif, on extrait les descripteurs du signal audio et on encode les annotations sous la forme d’une matrice 1-parmi-n, ou one-hot labels (étendue à un signal polyphonique comme vu dans la section 2.2.2). A chaque trame, on vérifie dans la matrice la présence de chaque classe i : si elle est présente, on met à jour le modèle de mélange gaussien de classe suivant la méthode d’espérance-maximisation (EM) [38] décrite dans l’encadré 2.5 ; sinon, on ne change rien.

Implémentation et vérification de l’algorithme

Dans cette section, on s’intéresse à vérifier le fonctionnement du GMM soustractif. Celui-ci est implémenté en Python 3 à l’aide des bibliothèques dcase_util pour la gestion de la chaîne de classification, librosa pour le traitement du signal audio [124], scikit-learn pour l’apprentissage du GMM [149] et sed_eval pour le calcul des critères de performance [127].

Les modèles de mélange gaussien

Bien que l’algorithme d’EM utilisé pour les GMM converge toujours vers un maximum local [38], il reste nécessaire de vérifier que notre classifieur converge au cours de l’apprentissage, ceci afin de s’assurer qu’aucun dysfonctionnement ne vienne perturber nos résultats.

Après avoir vérifié que ses performances correspondent à l’état de l’art, on examine le rôle de paramètres qui jouent sur l’apprentissage, à savoir la nature de l’initialisation et le seuil de décision.

Validation du fonctionnement du GMM soustractif

Pour chaque classe, l’apprentissage d’un GMM consiste à entraîner différentes gaussiennes en déterminant leurs statistiques (probabilité d’apparition, vecteur moyenne, matrice de covariance) sur une séquence de données. Ces données, initialisées à une certaine valeur selon le type d’initialisation choisi (K-moyenne ou aléatoire), doivent tendre vers un maximum local à une vitesse que l’on souhaite la plus haute possible, ces deux éléments dépendant notamment de l’initialisation. Dans le cas présent, on fixe une initialisation aléatoire, qui est détaillée dans l’annexe B.

On visualise différents éléments nous permettant de nous assurer de la convergence : la norme du vecteur moyenne, le déterminant et le conditionnement de la matrice de covariance, le tout pour chacune des quatre gaussiennes de chaque mélange, ainsi que la borne inférieure de la log-vraisemblance calculée sur les données d’entraînement, et ce pour les GMM de présence et d’absence de toutes les classes. On entraîne nos classifieurs sur cent époques, et on relève les mesures toutes les dix époques. Parmi les six classes de notre base de données, on illustre sur la figure 2.8 la convergence du système par la classe people speaking (personnes parlant), pour laquelle la convergence est la plus lente. On observe, comme on s’y attendait, que les valeurs de toutes ces statistiques convergent correctement vers une valeur constante. Le GMM d’absence, qui est entraîné par davantage de données (en effet, chaque classe est majoritairement absente sur l’ensemble de la BDD), converge très rapidement. Au contraire, le GMM de présence, qui est entraîné par moins de données, n’atteint sa convergence qu’au bout de 80 époques. Ce phénomène peut également être observé pour les autres classes, mêmes si celles-ci ont une convergence plus rapide, probablement en raison de la complexité du signal de parole et de sa relation étroite avec les MFCC. Par ailleurs, on note que, pour les deux GMM, les gaussiennes 1 et 3 ont des statistiques très proches les unes des autres ; cela n’est cependant pas le cas pour toutes les classes. Considérant à présent la norme des vecteurs moyenne et la borne inférieure de la log-vraisemblance, les valeurs de celles-ci sont tout à fait représentatives dece qui peut être obtenu pour notre application. Il en est de même pour le déterminant et le conditionnement des matrices de covariance, que nous souhaitons tout de même commenter ici.

En effet, le conditionnement d’une matrice représente le ratio entre sa valeur propre la plusélevée et celle la plus faible, ce qui nous donne ici un ratio très important pour les gaussiennes2 et 4 dont les valeurs sont, par exemple, de 1063 et 3753 après 80 époques. Il est important d’y faire attention car des valeurs d’ordres de grandeur supérieur pourraient empêcher d’obtenir une vraisemblance convenable. De la même manière, le déterminant des matrices peut prendre des valeurs extrêmement faibles (respectivement 3.57 × 10−22 et 2.26 × 10−10 pour les deux gaussiennes étudiées précédemment) ou au contraire extrêmement fortes (9.42 × 106 pour la gaussienne 3 du GMM de présence). Or dans le calcul de la vraisemblance, la racine carrée du déterminant est au dénominateur ; dans certains cas, même si la racine carrée a tendance à écraser les valeurs extrêmes, la log-vraisemblance va se révéler très forte ou au contraire très faible quel que soit le vecteur de descripteurs de test, ceci à cause de ce déterminant.

Etude du comportement

Nous avons établi le bon fonctionnement du GMM soustractif, ainsi que le seuil de décision optimal pour maximiser ses performances à paramètres fixés. D’autres paramètres peuvent néanmoins modifier le comportement du classifieur, comme le type de la matrice de covariance, le nombre de gaussiennes… En parallèle, la plupart de ces paramètres jouent un rôle primordial dans la complexité du test effectué par le classifieur, complexité qui déterminera ultérieurement la consommation d’énergie et le matériel d’un système de classification embarquée. Par exemple, l’entraînement d’un grand nombre de gaussiennes pour chaque GMM augmente la complexité du système à chacune de ses utilisations alors que la nature de l’initialisation, qui n’a lieu que pendant la phase d’apprentissage, ne l’augmentera pas (on estime que les paramètres, après la phase d’apprentissage, sont stockés dans la mémoire du système).

Si nous n’évaluerons pas dans ces travaux la complexité et la consommation du système de classification, nous étudions néanmoins dans cette section les paramètres qui les influencent lors de la phase de test, à savoir le nombre de gaussiennes et le type de la matrice de covariance des GMM, et la normalisation des descripteurs.

Choix du nombre de gaussiennes

Dans un premier temps, on va s’intéresser au nombre de composantes gaussiennes nc dans les GMM. Ce paramètre, qui définit la précision de la modélisation des groupements d’individus, doit être choisi avec attention. En effet, si le nombre de gaussiennes est trop faible, cellesci risquent d’avoir des difficultés à prendre en compte une grande quantité d’individus voire se retrouver entre deux groupements distincts ; mais si ce nombre est trop élevé, le moindre changement dans la base de test pourra ne pas être repéré en raison du sur-apprentissage. Le nombre optimal de composantes peut être déterminé à l’aide de plusieurs méthodes : par critère d’information (Akaike, bayésien…), par mélange de processus de Dirichlet ou par optimisation utilitaire [196]. Face à la complexité d’optimiser plusieurs GMM simultanément avec le même critère, on choisit cette dernière méthode, qui consiste à déterminer simplement la valeur de nc qui maximise les performances que l’on souhaite mesurer.

Jusqu’à présent, nous utilisions des GMM à quatre composantes, qui sont connus dans la littérature pour être relativement efficaces. Souhaitant rester à un niveau de complexité relativement faible, on choisit d’observer les performances de classification pour un nombre de composantes compris entre 1 et 10. On conserve également un seuil de décision constant de 35 car, en observant les courbes de taux d’erreur en fonction de la F-mesure et du seuil pour chaque valeur de nc, il semble que ce seuil reste un bon compromis entre les deux mesures.

Les résultats sont ainsi présentés pour les valeurs de nc considérées sur la figure 2.11. Ceux-ci sont sans équivoque : la F-mesure est bien meilleure pour nc = 4 que pour les autres valeurs.

Si la modification du seuil pourrait éventuellement accroître la F-mesure, elle aurait également pour effet d’augmenter le taux d’erreur, qui est déjà équivalent à celui des GMM à quatre composantes pour nc > 6, et supérieur pour les autres. Le choix du nombre de gaussiennes va donc se porter à 4.

Le réseau neuronal convolutif et récursif

Dans cette section, nous présentons le second classifieur utilisé dans nos travaux, à savoir un CRNN. Celui introduit ici est inspiré de la référence des tâches de détection des challenges DCASE 2019 et 2020 [191], et qui est encore régulièrement utilisé comme modèle. Comme on l’a indiqué dans la section 2.3.2, son entrée n’est non pas le vecteur des MFCC et de ses dérivées mais le mel-spectrogramme associé. Comme pour le GMM, nous cherchons principalement ici à reproduire l’état de l’art.

On commencera par décrire le fonctionnement de ce CRNN et l’intérêt de ses différentes couches. Par la suite, comme pour le GMM, on l’implémentera et on vérifiera qu’il fonctionne.

Enfin, on étudiera le comportement du CRNN en relation avec différents paramètres qui influent sur la complexité de la phase de test du système.

Fonctionnement théorique d’un réseau neuronal convolutif et récursif

A l’origine, les réseaux connexionnistes ont pour but de modéliser les systèmes cérébraux [38]. Ils se sont rapidement avérés très performants pour tout type de classification et se sont répandues en tant que méthode majoritaire en apprentissage automatique. Pour la classification acoustique, qui cherche à simuler l’écoute et la compréhension sonore humaine, il était donc logique d’utiliser également les réseaux neuronaux. Dès 2016, ils deviennent majoritaires dans les solutions proposées aux différentes tâches du challenge DCASE [128]. En 2017, le gagnant de la tâche 3 de détection en environnement réel utilise un CRNN qui s’impose peu à peu [3]. Le CRNN que nous utilisons est celui présenté sur les figures 2.15 et 2.16, issu du gagnant de la tâche 3 du challenge DCASE 2017 [3] et repris dans les éditions suivantes. Il est constitué de trois blocs convolutifs suivis de deux couches récurrentes. L’entrée de ce réseau est un ensemble de matrices constituées par les descripteurs d’une succession de nseq trames, c’est-à-dire le vecteurs des 40 coefficients du mel-spectrogramme. À noter que ces descripteurs sont normalisés pour être centrés et réduits [26, 50]. Cet ensemble de matrices est découpé en plusieurs lots (mini-batch en anglais) qui sont successivement présentés en entrée du réseau de neurones. Les paramètres de celui-ci sont mis à jour après le passage de chaque lot.

Les blocs convolutifs L’utilisation de plusieurs trames permet aux couches convolutives d’apprendre à percevoir non seulement les informations importantes à chaque trame, mais également la relation avec les précédentes et les suivantes, comme le faisaient les ∆MFCC et ∆2MFCC pour le GMM. Ce phénomène est particulièrement utile pour les signaux audio qui présentent une corrélation temporelle court-terme, c’est-à-dire sur un petit nombre de trames successives [196]. Au sein de notre réseau, chaque bloc convolutif est formé par une succession de plusieurs couches indiquées sur les figures 2.15 et 2.16 :

Une convolution 2D Cette première couche réalise une convolution entre un filtre de taille tf et une portion de même dimension de l’entrée (en glissant à chaque fois de np pixels sur l’image), et répète cette opération avec nf filtres différents. La succession des couches convolutives entraîne un apprentissage de plus en plus fin sur les données [38]. À noter que, pour la première couche, le signal est remodelé par une couche nommée Reshape qui indique que nous n’utilisons qu’un seul canal (la couche convolutive peut théoriquement en traiter plusieurs).

Une normalisation batch Afin d’accélérer l’apprentissage grâce à des données correctement mises en forme, une normalisation est appliquée à la sortie de la couche convolutive.

Il s’agit ici d’une normalisation par batch, c’est-à-dire que les données sont centrées et réduites par rapport à une moyenne et une variance calculées sur l’ensemble des données d’un même mini-batch.

Une couche d’activation Une couche d’activation non linéaire est ensuite appliquée pour activer seulement certains neurones du réseau. On utilise ici la fonction d’activation rectified linear unit (ReLU), qui a prouvé son efficacité dans les réseaux sans pré-entraînement [38].

Un MaxPooling en 2D Aussi appelée couche d’agrégation et de sous-échantillonnage, elle a pour but de réduire la taille des entrées tout en assurant leur robustesse au bruit et distorsions. Pour cela, on découpe chaque entrée à l’aide d’une fenêtre glissante (en glissant à chaque fois de nm pixels sur l’image), et une valeur unique est calculée puis conservée à partir de ces portions d’entrée. Dans le cas du MaxPooling, on conserve la valeur maximale d’une fenêtre de taille tm.

Une couche Dropout La dernière couche de ce bloc est celle de dropout, qui consiste à désactiver temporairement certains neurones pour permettre un meilleur apprentissage pour les autres (notamment les moins utilisés), ce qui permet d’éviter le surapprentissage. Cette couche est caractérisée par le taux td de neurones désactivés.

Les paramètres utilisés pour ce bloc sont indiqués dans la table 2.11.

Transmission point-à-point au travers d’un canal de communication

Une communication point-à-point est définie comme la transmission d’information entre deux nœuds, l’émetteur étant appelé la source et le récepteur le destinataire. Nous nous intéressons communication est alors half-duplex, ou à l’alternat [15]. Nous supposerons en outre que la source et le destinataire sont toujours représentés par les mêmes nœuds : le canal transporte donc l’information dans un seul sens, et il est considéré comme simplex, ou monodirectionnel. Le signal source traverse un système complexe composé de plusieurs blocs qui forment la chaîne de communication. Ces blocs, présentés dans cette section, permettent de transmettre le signal le plus efficacement et le plus exactement possible.

Dans cette section, on commencera par présenter le modèle mathématique général de la chaîne de transmission. Afin d’établir un contexte précis pour nos travaux, on détaillera ensuite les caractéristiques du canal de propagation et de la modulation.

|

Table des matières

1 Introduction

1.1 Introduction générale

1.2 Motivations et problématiques

1.3 Contributions de nos travaux

1.4 Structure de la thèse

2 Détection d’événements sonores

2.1 Introduction

2.2 Généralités sur la classification acoustique

2.2.1 Les types de la classification

2.2.2 Les étapes d’une détection d’événements acoustiques

2.2.3 Les propriétés des données audio

2.2.4 Le choix d’un classifieur

2.3 Les outils de la classification

2.3.1 Les bases de données

2.3.2 Descripteurs d’un signal audio

2.3.3 Critères de performance en classification

2.4 Les modèles de mélange gaussien

2.4.1 Fonctionnement théorique d’un modèle de mélange gaussien soustractif

2.4.2 Implémentation et vérification de l’algorithme

2.4.3 Etude du comportement

2.5 Le réseau neuronal convolutif et récursif

2.5.1 Fonctionnement théorique d’un réseau neuronal convolutif et récursif

2.5.2 Implémentation et vérification de l’algorithme

2.5.3 Etude du comportement

2.6 Conclusion

3 Consommation d’énergie d’un système communicant

3.1 Introduction

3.2 Transmission point-à-point au travers d’un canal de communication

3.2.1 Modèle d’une communication point-à-point

3.2.2 Le canal de propagation

3.2.3 Modulation du signal

3.3 Transmission coopérative à l’aide d’un noeud-relai

3.3.1 Modèle d’une communication avec relai

3.3.2 Protocoles de coopération

3.3.3 Combinaison des signaux à la réception

3.4 Mesurer les performances de la transmission

3.4.1 Probabilité d’erreur en réception

3.4.2 Efficacités du canal

3.4.3 Capacité de Shannon

3.4.4 Métriques du coopératif

3.5 Consommation d’énergie d’une communication

3.5.1 Modèle énergétique d’une transmission point-à-point

3.5.2 Modèle énergétique d’une transmission coopérative

3.6 Lien entre énergie et efficacité spectrale

3.6.1 Lien entre consommation d’énergie et capacité

3.6.2 Capacité pour un signal modulé

3.6.3 Minimisation de la consommation

3.7 Conclusion

4 Analyse d’un modèle de consommation réaliste

4.1 Introduction

4.2 Vers un modèle de consommation plus réaliste

4.2.1 Coefficient de l’amplificateur de puissance

4.2.2 Puissance des convertisseurs

4.2.3 Limitation de la puissance de transmission

4.3 Une meilleure estimation de l’efficacité spectrale b

4.3.1 Capacité du canal

4.3.2 Efficacité spectrale pour un modèle de consommation plus réaliste

4.3.3 Résultats expérimentaux

4.4 Influence de la position du relai

4.4.1 Variation du relai sur l’axe source-destinataire

4.4.2 Variation du relai dans un espace à deux dimensions

4.5 Conclusion

5 Détection d’événements sonores au sein d’un système embarqué multicapteurs

5.1 Introduction

5.2 Contexte d’une classification sonore embarquée

5.2.1 Introduction d’un système distribué multi-nœuds

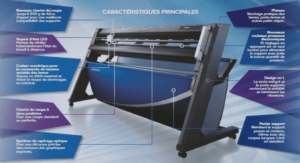

5.2.2 Exemples de systèmes utilisables

5.3 Introduction d’éléments de spatialisation dans la classification

5.3.1 Descripteurs spatiaux

5.3.2 Utilisation des différents canaux et nœuds au sein du système

5.4 Amélioration des données dans un système contraint

5.4.1 Augmentation de données compatibles avec la polyphonie

5.4.2 Expériences sur le recouvrement et la technique du mixup

5.5 Encodage des descripteurs en virgule fixe

5.5.1 L’algorithme Linde-Buzo-Gray (LBG)

5.5.2 Quantification des descripteurs

5.5.3 Résultats expérimentaux

5.6 Influence de la transmission sur la classification d’événements sonores

5.6.1 Présentation du système

5.6.2 Résultats expérimentaux

5.6.3 Augmentation de données pour la transmission de descripteurs

5.7 Conclusion

6 Conclusions et perspectives

6.1 Conclusion

6.2 Perspectives

6.3 Publications

A Liste des descripteurs dits « artisanaux »

B Description de l’initialisation aléatoire d’un GMM

C Preuves de convexité et calcul de b ∗

C.1 Démonstration de la convexité de l’énergie totale pour un modèle simplifié issue de l’équation

C.2 Calcul de b ∗ pour un modèle simplifié de l’énergie

C.3 Validation de la convexité de l’énergie totale pour un modèle avancé sur un canal additive white Gaussian noise (AWGN) issue de l’équation 4.26

D Détails sur le facteur de roll-off et l’efficacité du drain 180

D.1 Origine du facteur de roll-off

D.2 Calcul et propriétés de l’efficacité du drain

Bibliographie

Télécharger le rapport complet