Introduction

Des problèmes statistiques dans la conduite d’essais cliniques sont fréquents. Le choix de la taille de l’échantillon, l’interprétation des résultats, la validité d’un modèle, l’étendue des outils statistiques et des règles d’arrêt peuvent compliquer les analyses statistiques.

La mise en marché d’un médicament passe par plusieurs études différentes (ou essais cliniques) avec chacune différents objectifs. Dans notre cas nous nous intéressons à une étude de phase II avec différents objectifs classés par ordre d’importance. Les études de phase II sont considérées comme des intermédiaires sensibles dans le sens où l’on ne possède généralement pas assez de sujets pour conclure d’une manière définitive, mais peuvent directement stopper le développement d’un nouveau médicament.

Nous reprenons la méthodologie statistique pour répondre à ces différents objectifs, en particulier deux critères de décision ainsi qu’une approche Bayésienne sont proposés. Des simulations nous ont permis de faire un contrôle de cohérence de ces critères. Par la suite une revue de la littérature nous a permis d’expliquer théoriquement cette approche, ainsi que d’adapter nos outils statistiques à l’approche Bayésienne pour proposer une modélisation du phénomène observé.

Dans la partie 1 nous rappelons la base de l’analyse de survie, dans la partie 2 nous présenterons deux modèles semi-paramétriques, dans la partie 3 nous présenterons quelques principes de l’analyse bayésienne et dans la partie 4 nous expliquerons l’approche recommandée.

Analyse de survie

Dans cette partie nous allons présenter et introduire les définitions et notations de base de l’analyse de survie. On peut trouver différentes notations dans les articles et livres pour représenter nos prédicteurs, notre variable de survie et l’indicateur de censure. Nous utiliserons les notations jugées comme les plus adaptées.

Remarques

Le vocabulaire « durée de vie », « décès de l’individu » est une convention de l’analyse de survie bien que la théorie s’applique dans divers domaines où l’événement d’intérêt peut représenter par exemple la durée de latence d’un patient séropositif, la durée de chômage pour les licenciés, etc. (ii) On s’est placé dans le cas ou T admet une densité par rapport à la mesure de Lebesgue sur ; toutes les fonctions définies dans cette partie sont définies sur [0 , +∞[. -(iii) De même, sauf si précisé on considèrera qu’un individu ne peut « mourir » qu’une seule fois.

Censure et troncature

Définition 12.1 Une observation est censurée lorsque la durée exacte est inconnue mais que l’on dispose d’une information partielle sous la forme d’un minimum ou d’un maximum ou les deux. Si l’on observe la variable de censure C, et non T, et que l’on sait que T > C (respectivement T < C, < T< ), on dit que T est censurée à droite (respectivement à gauche, par intervalle).

Définition

Un jeu de données est sujet à la troncature lorsque le caractère incomplet du jeu de données est dû à un processus de sélection systématique inhérent à la planification expérimentale. Lorsqu’en raison de la planification expérimentale on recueille des observations seulement sur les individus pour lesquels l’évènement d’intérêt se produit au-delà d’un seuil aléatoire ou fixe (respectivement avant, au-delà d’un premier seuil mais avant un deuxième seuil), il s’agit de données tronquées à gauche (respectivement à droite, par intervalle).

La troncature se distingue de la censure dans le sens où la troncature élimine une partie de nos observations de notre échantillon, tandis que pour la censure l’observation est présente dans l’échantillon mais incomplète.

On parle de censure non-informative ou censure aléatoire lorsque la censure est indépendante de l’événement étudié.

Différentes approches

Plusieurs modélisations sont possibles avec chacune avantages et inconvénients, présentons brièvement sans exhaustivité des avantages et inconvénients.

Pour l’approche paramétrique on fait l’hypothèse que la loi de probabilité réelle de la population appartient à une classe particulière de lois, qui dépendent d’un certain nombre fini de paramètres. L’avantage de cette approche est la relative facilité d’analyse en termes d’estimation des paramètres, de construction de tests et d’intervalle de confiance. L’inconvénient est une possible inadéquation entre le phénomène observé et le modèle choisi.

Pour l’approche non-paramétrique on fait un minimum d’hypothèses sur la densité réelle des observations. L’avantage est la capacité à s’ajuster à quasiment tous les jeux de données. L’inconvénient est la taille de l’échantillon nécessaire ainsi que l’estimation des paramètres qui est plus compliquée.

L’approche semi-paramétrique est une sorte de compromis entre les deux, le paramètre à estimer a une composante appartenant à un espace de dimension finie et une composante appartenant à un espace de dimension infinie. On est souvent seulement intéresser à estimé seulement le paramètre de dimension finie.

Définition

Le rapport des hasards (ou Hazard Ratio en anglais) est défini mathématiquement par son nom (implicitement dit le rapport des fonctions de hasard pour deux populations différentes, ou deux sous parties d’une même population). On notera HR.

Remarque

Le terme rapport des hasards est souvent employé en même temps qu’on fait l’hypothèse des risques proportionnels, et est donc supposé constant dans le temps c’est aussi dans ce cadre que nous sommes et donc nous le définissons à l’intérieur de la partie sur le modèle de Cox bien qu’on aurait pu le définir dans le chapitre 1.

Remarques

Le modèle de Cox est habituellement vu comme un modèle semiparamétrique, bien qu’on puisse aussi le traiter de manière non-paramétrique ou paramétrique (avec des splines par exemple voir [10], ou avec une loi exponentielle, weibull ou gompertz [2]). (ii) Dans le cas d’un modèle mal spécifié (s’il manque une variable explicative par exemple) l’estimateur du maximum de vraisemblance partielle de est biaisé.

Statistique Bayésienne

Dans cette partie nous allons présenter quelques éléments de la statistique bayésienne. Dans la premiere partie nous avons vue trois approches permettant de modéliser un phénomène complexe par un modèle probabiliste, maintenant nous considérons deux approches statistiques d’un point de vue plus général qui est l’approche fréquentiste ou classique et l’approche bayésienne. Bien que d’un point de vue pragmatique on puisse ne pas faire de distinction entre les deux approches, pour une meilleur explication et compréhension nous faisons une séparation entre les deux. Nous ferons aussi une séparation entre inférence et décision. Il serait impossible de mettre assez de sources ici mais le lecteur voulant s’intéresser au sujet pourra se référer à [8],[17], [19], et des auteurs tels que Berger, Lindley, Savage, etc pour une réel compréhension et non une illusion de compréhension.

Moyenne de modèles

En pratique dans l’approche classique lors de la construction d’un modèle on fait souvent de nombreux tests pour inclure certaines variables explicatives ou non, souvent à la suite des autres, on doit aussi faire certains choix, et on ne tient pas compte de toutes les erreurs que l’on a pu faire lors du choix du modèle. On a des critères mesurant comment le modèle s’ajuste aux données avec une pénalité sur le nombre de paramètres pour favoriser les modèles simples, ce qui nous permet de choisir le « meilleur modèle ». Un des avantages de l’approche bayésienne qui ne semble pas être présent en statistique classique est de tenir compte de toutes ces erreurs, avec la même philosophie que pour le paramètre de notre modèle on va essayer de tenir compte de l’incertain de notre modèle.

Non-paramétrique

Nous avons vu dans la partie 2 plusieurs modèles semi-paramétriques, en revanche dans un cadre Bayésien on doit tout modéliser et donc il n’y a pas de semi-paramétrique.

Reprenons les méthodes que nous avons vues précédemment pour éliminer un paramètre de nuisance d’un point de vue général. Supposons que nos paramètres d’intérêts sont notés , et nos paramètres qui n’ont pas un intérêt premier. La façon classique de faire est de trouver et qui maximisent la vraisemblance. Si appartient à un espace de dimension infinie cette maximisation peut présenter des difficultés et on est obligé d’utiliser une approche non-paramétrique alors que notre but est simplement de faire une inférence.

Applications et discussion

Applications

Les nombreux exemples que nous avons vus peuvent être directement appliqués lors de l’analyse principale du jeu de données pour répondre aux différentes questions de l’étude. Dans le cas de la moyenne de modèle le package bic.surv du logiciel R est recommandé plutôt que SAS. Dans le cas où l’hypothèse de proportionnalité du modèle de Cox ne tient pas nous avons vu que stratifier par variables explicatives pouvait être une solution ; d’autres solutions sont possibles tel que stratifier l’axe du temps ou changer de modèle (un modèle additif par exemple ou un modèle plus général).

Calcul du nombre de sujets

On souhaite comparer deux traitements, un connu contre un nouveau. Une des étapes principale de la statistique est de passer des données au modèle de la façon la plus rigoureuse possible afin de tirer les conclusions les plus précises et les plus justes possibles quant au phénomène observé. Nous nous plaçons une étape avant c’est-à-dire au moment de désigner une stratégie afin d’aboutir à l’objectif principal de l’essai clinique. La fin principale de l’essai clinique est d’évaluer l’effet du nouveau traitement comparé à l’ancien, puis lors de l’arrêt de l’étude de prendre une décision justifiée (ou de justifier une décision) quand à poursuivre ou non l’essai clinique dans une autre phase. Le moyen est de déterminer le nombre de sujets nécessaire pour atteindre un niveau d’évidence suffisant. On se place dans le cadre le plus simple au point de vue de l’interprétation où on suppose que les données vont suivre un modèle de Cox avec un simple effet des médicaments sans interactions avec d’autres variables explicatives.

Conclusion

Ainsi, j’ai effectué mon stage de fin d’étude du Master de Statistique de Strasbourg. Les questions initiales ont été explorées par simulations puis répondus et expliqués par la théorie. Des pistes de réflexions ainsi que des outils statistiques ont étés proposés. Lors de ce stage j’ai pu mettre en perspective et mieux comprendre les connaissances théoriques acquises pendant ma formation universitaire grâce à une réel réflexion et une recherche bibliographique, j’ai pu voir différents intérêt de passer par un cadre formaliste pour résoudre un problème et enfin ce stage a été une bonne introduction au domaine biostatistique et aux essais cliniques dans l’industrie pharmaceutique. J’aborde avec confiance la suite

|

Table des matières

Remerciements

Introduction

Analyse de survie

1.1 Fonctions de survie et de hasard

1.2 Censure et troncature

1.3 Différentes approches

Modèles semi-paramétriques

2.1 Modèle de Cox

2.2 Modèle au hasard constant par morceaux

Statistique Bayésienne

3.1 Présentation générale

3.3 Non-paramétrique

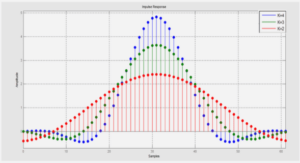

3.4 Algorithmes de simulations

Applications et discussion

4.1 Exemple

4.2 Calcul du nombre de sujets

References

![]() Télécharger le rapport complet

Télécharger le rapport complet