Approches orientées aux charges thermostatiques

Les principaux travaux réalisés dans la littérature considérant de façon très détaillée le chauffage par convecteurs et le chauffage de l’eau sanitaire ont été faits en France [66].

Une première approche proposée comporte une représentation temps-fréquence fondée sur l’utilisation conjointe d’un détecteur de non-stationnarités dans le plan temps-fréquence (spectrogramme) et d’une méthode d’ extraction des motifs fréquents [67]. La reconnaissance des profils thermostatiques stationnaires est faite en évaluant la densité des événements. Pour détecter le régime stationnaire, un test d’hypothèses est fait en utilisant une fonction de contraste, la décision sur la reconnaissance ou non est prise à partir d’une règle de seuillage.

Une deuxième approche de type probabiliste est proposée pour la décomposition de la courbe agrégée contenant seulement des charges pour le chauffage [68]. Celle-ci considère que la courbe agrégée de puissance est constituée uniquement par un mélange d’un nombre inconnu de créneaux quasi périodiques. La période de régulation et la puissance nominale de chaque élément sont de caractère déterministe, en contrepartie, le nombre de cycles, le rapport cyclique de chacun et le moment de début sont considérés comme des variables aléatoires. La solution du problème d’estimation de cycles thermostatiques est faite en utilisant un algorithme d’optimisation basé sur les Monte-Carlo par Chaînes de Markov (MCMC) à Sauts-Réversibles (RJMCMC) [69]. Cette méthode s’ inscrit dans le cadre du formalisme bayésien et elle génère des données permettant une solution au sens du maximum a posteriori.

Cependant, le comportement de l’ algorithme dans un scénario ayant plus de charges autres que le chauffage et le problème de similitude de signatures restent à étudier. Nonobstant, ces études dévoilent des pistes importantes dans la construction d’ une approche générale pour les charges thermostatiques. D’abord, le caractère non déterministe de la plupart des paramètres reliés à la détection de profils amène à considérer les modèles stochastiques ayant un cadre de résolution bien défini tel que le formalisme bayésien. D’ autre part, les problèmes reliés au chevauchement d’événements et de signatures ne sont pas assez étudiés dans le domaine, un obstacle qui rend difficile la comparaison des méthodes existantes.

Synthèse des revues et critères pour la sélection du modèle

Généralement, les différentes méthodes Machine Learning (ML) utilisées pour la solution du problème NILM peuvent être regroupées dans deux grandes familles bien définies: les modèles génératifs et les modèles discriminants [54]. Nous allons présenter certains critères qui nous permettront de choisir, parmi ces familles, une méthode bien adaptée à la problématique de thèse.

Dans la famille de modèles génératifs, nous trouverons les méthodes modélisant les relations entre les charges et les observations à partir de lois jointes. Ces approches, issues du théorème de Bayes, développent généralement toute la structure de la solution à partir des hypothèses faites sur les relations de dépendance entre données, modèles et paramètres.

Comme leur nom l’indique, les modèles génératifs sont capables de générer des données synthétiques à partir de l’échantillonnage des distributions. Cette capacité facilite énormément la création de scénarios de simulation, et dans certains cas, cette qualité est exploitée pour résoudre des problèmes d’ inférence complexes. Dans le domaine NILM, les modèles génératifs sont présentes dans un grand nombre d’approches modélisant des automates probabilistes à états finis. Ceci à travers les modèles de Markov et leurs variantes connexes. Une autre caractéristique importante des modèles génératifs est reliée à leur capacité intrinsèque de gérer les incertitudes. En effet, à partir des définitions des intervalles de confiance et de crédibilité le système peut prendre des décisions adéquates face aux événements rares. Un événement rare ou inconnu est très probable dans les profils de consommation agrégée. Ils sont normalement introduits par des charges non modélisées et d’ utilisation peu fréquente. Ils sont aussi induits par des variations significatives dans le mode d’opération d’un appareil, par exemple, si un utilisateur oublie d’éteindre le four électrique le matin et celui-ci reste en fonctionnement toute la journée.

Par ailleurs, dans la famille de modèles discriminants nous retrouvons les approches ciblant la classification à partir de règles qui vont tracer les frontières de décision. Un vaste et varié nombre d’ approches NILM peuvent entrer dans cette famille [70]. Parmi les plus populaires, nous soulignons, les réseaux de neurones artificiels (ANN) [50], les Machines à vecteurs de support (SVM) [26], la régression logistique et les k plus proches voisins (KNN) [71 ]. La famille discriminante est très utilisée dans les problèmes d’apprentissage supervisé et elle présente de bonnes performances dans la classification de caractéristiques non chevauchées.

L’hybridation avec des modèles des automates déterministes permet leur application dans l’analyse séquentielle [42].

Les descriptions faites préalablement sur les deux familles peuvent être approfondies et probablement d’autres familles pourront être proposées. Cependant, pour le domaine NILM, nous pourrions classifier presque toutes les approches existantes dans ces deux catégories. Par ailleurs, afin de déterminer la méthode plus adaptée au problème de surveillance concerné dans cette thèse, nous allons présenter par la suite des critères de sélection selon les besoins et les exigences actuelles pour les systèmes NILM. En effet, tel que discuté dans la méthodologie, nous avons basé l’analyse sur des approches non-déterministe. Toutefois, nous représenterons quelques arguments justifiant ce choix. D’abord, il faut signaler qu’il existe un grand nombre de critères qui pourront être ajoutés pour avoir une vision plus large sur la qualité des modèles disponibles. Nous pouvons citer la robustesse, la convergence, l’apprentissage non supervisé, le temps réel, l’optimalité, l’efficacité, entre autres. Ces critères sont bien étudiés et démontrés pour le cas des modèles génératifs.

Toutefois, nous voulons énoncer quelques exigences complémentaires dans le développement des approches NILM. Celles-ci font du formalisme bayésien une méthodologie assez appropriée pour le problème formulé :

Analyse séquentielle: possibilité de modéliser la structure temporelle des données et d’évaluer le profil sur des périodes de temps ajustés aux durées des cycles d’opération de charges. Sur ce point, le succès des méthodes Markoviennes dans plusieurs domaines d’application de l’intelligence artificielle se trouve précisément dans la gestion cohérente des données séquentielles discrètes. En effet, à partir du modèle génératif, on peut calculer la vraisemblance d’une séquence d’états et évaluer en termes des probabilités s’il elle a été générée par un modèle spécifique [72].

Gestion des connaissances a priori : cette capacité permet au système d’intégrer de façon cohérente les informations de haut niveau préalables. Ceci est important quand on dispose de l’information statistique générale ou de paramètres sur le mode d’opératoire d’une charge plutôt que des échantillons de leurs signatures électriques. Par exemple, la valeur de la puissance moyenne demandée par des réfrigérateurs standards peut être incluse en tant qu’hyperparamètre [73].

Extensibilité : l’approche doit permettre une croissance progressive des connaissances en s’appuyant sur la capacité d’intégrer de nouveaux modèles sans affecter les structures existantes. En effet, l’agrégation probabiliste encadrée dans les techniques FHMM permet de prédire les combinaisons d’observations à partir des modèles préalables et les nouveaux sans re-entraîner et sans redéfinir les paramètres de l’algorithme de désagrégation. À cet égard, on privilégie les techniques capables de modéliser la distribution marginale du profil agrégé par ses causes (profils individuels). De cette façon, au moment d’ inclure une nouvelle charge dans l’analyse, l’approche sera capable de prédire la nouvelle distribution du profil agrégé plutôt que l’ estimer directement à partir des données.

Gestion de l’incertitude : la méthode est capable de modéliser les aspects non déterministes des profils d’ intérêt, de plus, elle doit être en mesure de dissocier les événements rares ou inconnus. En effet, les variations non déterministes des signatures macroscopiques demeurent une difficulté importante à gérer dans les approches NILM existantes. Ces variations sont normalement provoquées par des changements dans les habitudes d’ utilisation des charges et des facteurs environnementaux non mesurés.

Par exemple, la variation du nombre de personnes dans une maison peut changer la signature macroscopique de la cuisinière ou de réfrigérateur, ainsi que la variation de la température extérieure change significativement la signature de l’ensemble des éléments de chauffage.

Unicité méthodologique: tous les processus et méthodes associées découlent de l’analyse statistique et probabiliste. Par conséquent, peu de paramètres ou de procédures non liés aux modèles individuels sont requis.

Introduction

Modélisation de multiples éléments thermostatiques

Comme discuté préalablement dans le Chapitre 1, l’utilisation d’un grand nombre des charges à états finis configure un cas particulier d’agrégation de la courbe de consommation.

En ce qui concerne la complexité de l’analyse des charges thermostatiques, la littérature NILM a identifié le problème de chevauchement ou similarité de signatures comme un défi majeur dans le développement et le déploiement de systèmes adressés à la surveillance de ce type de charges. Afin d’attaquer ces problèmes, nous développons dans ce chapitre une approche basée sur l’analyse des profils stochastiques discrets. Cette proposition permet d’exploiter efficacement la structure temporelle des processus discrets afin de mieux expliquer la consommation des charges individuelles, même quand leur puissance est très semblable en amplitude. Celle-ci est une méthode d’analyse basée sur la caractérisation macroscopique de la puissance active. Elle permet aussi de modéliser la composition des profils générés par un nombre fini d’éléments. Cette composition de charges donne lieu à un cas particulier des machines à états finis (FSM) dans lequel les modèles de transition entre les états agrégés peuvent être construits à partir de la combinaison de modèles élémentaires.

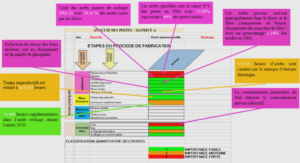

En outre, pour la surveillance des charges à états finis non déterministes, les HMM avec les variantes connexes se présentent comme l’état de l’art dans le domaine [21 ]. Les HMM s’inscrivent dans une méthodologie assez générale qui permet d’accomplir dans le même cadre théorique l’apprentissage, la détection, la classification et la décomposition des profils influencés par des incertitudes. Ces modèles comprennent l’analyse stochastique de séquences d’états discrets, ce qui donne une perspective plus large dans la modélisation et la reconnaissance des profils. Les HMM sont décrits par une structure composée d’ états discrets et de lois gouvernant les transitions. À cet égard, nous examinons l’application de variantes des HMM à partir de la manipulation des descripteurs statistiques d’une charge de type l, tout en arrivant à une description du comportement non déterministe des charges composées de multiples sous-profils thennostatiques. Une illustration schématisant la structure générale du processus de modélisation et désagrégation est montrée à la Figure 3-1. Cette stratégie pennet de construire des modèles factoriels à partir de la combinaison des paramètres identifiables à partir de données expérimentales par une approche d’ apprentissage supervisé ou bien semi-supervisé.

Afin d’établir les fondements théoriques de l’approche factorielle utilisée, nous étudierons dans un premier temps l’aspect aléatoire du comportement des profils à deux états. La contribution principale dans cette première étude réside dans l’incorporation des distributions sur les durées des états pour le calcul de matrices de transitions tout en gardant une complexité réduite dans les procédures d’ estimation des états cachés. Une fois que les modèles subjacents sont déterminés, nous proposons une approche capable de combiner les paramètres individuels vers une structure à multiples états. Cette dernière possibilité simplifie de façon considérable l’analyse des lois de transition pour les charges composées de plusieurs éléments résistifs.

Modèle probabiliste à deux états

Bien que le caractère thermostatique est relié à l’existence de deux types d’opérations, ce . . concept peut être étendu à des machines à deux états d’opération même si la consommation à l’ état « ON » n’est pas strictement constante. En effet, il n’est pratiquement pas possible de trouver un appareil avec une consommation strictement constante. Le fait d’avoir des charges constituées de résistances fixes n’ assure pas une demande en puissance invariante dans le temps. En pratique, les variations de la puissance consommée par des charges résistives sont causées par des fluctuations dans la tension du réseau ou par les changements de la température interne des éléments chauffants. Par ailleurs, d’incertitudes plus considérables, mais moins étudiées dans le domaine, sont introduites par des facteurs gouvernant la durée des états [37].

En fait, il est très difficile sinon impossible de déterminer avec exactitude le temps d’ utilisation d’une charge résidentielle. Dans ce contexte, les méthodes à effets aléatoires constituent un moyen plus élaboré d’ étudier les variabilités et incertitudes.

De façon générale, le comportement de puissance des profils à deux états est lié à l’existence d’une variable permettant la régulation des charges de type tout-ou-rien (ON-OFF).

Dans le processus de modélisation que nous développons pour la surveillance de charges de type l, nous relions la variable de contrôle thermostatique au concept d’ état de la charge.

Le fonctionnement du contrôle thermostatique est relativement simple, le contrôleur habilite l’écoulement de puissance pendant une période de temps vers une charge ayant une impédance à valeur nominale constante, il interrompt l’écoulement par la suite, pendant une autre période de temps. Ce cycle peut se répéter plusieurs fois de façon régulière ou jamais. Le temps moyen dans l’état « ON » dépend des besoins énergétiques du système et de la nature de la charge.

Les convecteurs pour le chauffage de l’espace, gérés par les thermostats électroniques ou bimétalliques, sont des exemples concrets de ce type de comportement. Ce groupe inclut également d’autres charges telles que les chauffe-eau électriques, les résistances (serpentins) des cuisinières et la plupart des réfrigérateurs.

L’information non mesurée ou cachée comprend toutes les grandeurs physiques négligées par le système d’acquisition de données. Des exemples de ces grandeurs sont: la température de l’eau dans le chauffe-eau électrique, la température interne de la charge, ou bien le rapport cyclique d’un thermostat pour le chauffage de pièces. Cependant, pour le contrôle thermostatique en général, les effets de la plupart des variables non observées sont transmis de façon directe ou indirecte à la variable d’état Zk. Cette dernière s’avère aussi non mesurable, mais éventuellement estimable à partir des modèles.

|

Table des matières

Résumé

Remerciements

Table des matières

Table des figures

Liste des tableaux

Liste des symboles

Liste des acronymes

Chapitre 1· Introduction

1.1 Contexte général et motivation

1.2 Bénéfices de la surveillance de charges dans le secteur résidentiel

1.3 Problématique de thèse

1.4 Objectifs et contributions

1.5 Méthodologie

1.6 Plan du manuscrit

Chapitre 2· NILM· État de l’art

2.1 Généralités sur la surveillance non-intrusive

2.1.1 Catégorisation des charges

2.1.2 Type de caractéristiques .

2.2 Désagrégation de mélanges additifs

2.2.1 Apprentissage automatique.

2.2.2 Optimisation combinatoire

2.2.3 Analyse séquentielle déterministe

2.2.4 Analyse séquentielle probabiliste

2.3 Approches orientées aux charges thermostatiques

2.4 Synthèse des revues et critères pour la sélection du modèle

Chapitre 3 – Modélisation de multiples éléments thermostatiques

3.1 Introduction

3.2 Modèle probabiliste à deux états

3.2.1 Les états cachés et les observations associées

3.2.2 Analyse probabiliste de la dynamique des états

3.2.3 Modèle de transition incluant la durée du séjour

3.2.3.1 Le temps de séjour et l’analyse de survie conditionnelle

3.2.3.2 Risque instantané et probabilité de transition

3.2.4 Reconnaissance probabiliste des profils à deux états .

3.2.4.1 Maximisation du logarithme de la vraisemblance

3.2.4.2 Maximisation du logarithme de la vraisemblance

3.2.4.3 Programmation dynamique pour l’ inférence des états

3.2.4.4 Étiquetage de séquences

3.2.4.5 Puissance et énergie moyenne d’un profil thermostatique

3.3 Agrégation de modèles et détection parallèle des états

3.3.1 Transitions entre super-états

3.3.2 Émissions agrégées

3.3.3 Pré-allocation des probabilités de transition avec les opérations de Kronecker

3.3.4 Algorithme de Viterbi

3.4 Synthèse du chapitre

Chapitre 4 – Évaluation de la méthode

4.1 Cadre comparatif et scénarios d’évaluation

4.2 Apprentissage supervisé des approches NILM étudiées

4.2.1 Estimation des états à partir des profils individuels

4.2.2 Entraînement des modèles à durée explicite

4.2.3 Entraînement des modèles FHMM

4.2.4 Entraînement des modèles RNN

4.3 Métriques et indicateurs de performance

4.3.1 Métriques pour la détection de l’état

4.3.2 Métriques pour la reconstruction du profil

4.4 Résultats préliminaires

4.4.1 Désagrégation des charges conventionnelles à deux états

4.4.2 Effet des charges inconnues

4.5 Désagrégation de charges thermostatiques actives à des puissances similaires

4.6 Cas des charges de chauffage contrôlées par des thermostats électroniques

4.6.1 Modèle MLI avec rapport cyclique stochastique

4.6.2 Initialisation et mise à jour des paramètres

4.6.3 Résultats

4.7 Discussion sur les résultats de la validation

Chapitre 5 – Conclusions et recommandations

5.1 Synthèse des travaux

5.2 Limitations et difficultés

5.2.1 Complexité de la méthode factorielle

5.2.2 Maximums locaux dans l’apprentissage de Viterbi

5.2.3 L’hypothèse d’indépendance entre les éléments

5.3 Recommandations

Bibliographie

5.3.1 Lois paramétriques alternatives pour la durée de l’état

5.3.2 Distributions priori sur les paramètres de la loi de Weibull

5.3.3 Estimation non supervisée des paramètres thermostatiques

5.3.4 Profit des ressources NILM disponibles

![]() Télécharger le rapport complet

Télécharger le rapport complet